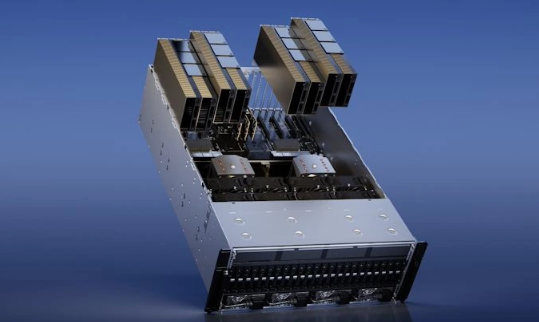

【ITBEAR科技資訊】3月22日消息,英偉達(dá)在GTC Spring 2023主題演講中推出了全新的雙GPU產(chǎn)品H100 NVL,該產(chǎn)品可滿(mǎn)足不斷增長(zhǎng)的人工智能市場(chǎng)需求。據(jù)悉,H100 NVL在頂部配備了3個(gè)NVlink連接器,使用兩個(gè)相鄰的PCIe顯卡插槽。H100 NVL最高可提供188GB HBM3顯存,單卡顯存容量為94GB。這在運(yùn)行大型語(yǔ)言模型(LLM)時(shí)非常重要,因?yàn)槌R?guī)顯卡的顯存無(wú)法駕馭龐大的數(shù)據(jù)流。H100 NVL的顯存容量更高,能夠滿(mǎn)足這種需求。

H100 NVL的功耗略高于H100 PCIe,每個(gè)GPU的功耗為350-400瓦(可配置),比H100 PCIe增加了50W。然而,總性能實(shí)際上是H100 SXM的兩倍。FP64為134 teraflops,TF32為1979 teraflops,F(xiàn)P8為7916 teraflops,INT8為7916 teraops。此外,內(nèi)存帶寬也比H100 PCIe高得多,每個(gè)GPU為3.9TB/s,總和為7.8TB/s,而H100 PCIe僅為2TB/s,H100 SXM為3.35TB/s。

據(jù)ITBEAR科技資訊了解,H100 NVL為大型語(yǔ)言模型等需要大量顯存的應(yīng)用提供了更好的解決方案,同時(shí)提供了高性能和高內(nèi)存帶寬。這將使研究人員更容易處理海量數(shù)據(jù),訓(xùn)練出更準(zhǔn)確的模型,從而加速人工智能的發(fā)展。英偉達(dá)表示,H100 NVL已經(jīng)開(kāi)始出貨,但并未透露其價(jià)格。