為人工智能訓練和推理建立數據中心的熱潮已經導致市場瘋狂。例如,Credo上周上漲了 27%。Vicor 上漲了 30%,還有許多其他公司與 Nvidia 并駕齊驅,但在筆者看來,他們都不值得今天的受益,而且另一方面,許多公司沒有得到他們應得的適當榮譽。

IT 預算有限。它們可能會有所增加,但鑒于宏觀經濟的不確定性,大多數企業的資本支出和運營支出最有可能必須保持固定。因此,Nvidia 銷售的主要繁榮直接來自購買較少的非 GPU 服務器。市場已經認識到,由于 AI 支出的轉移,傳統 CPU 的銷售將會疲軟。Nvidia 在今年余下時間的數據中心收入高于英特爾數據中心,這清楚地證明了這一點。

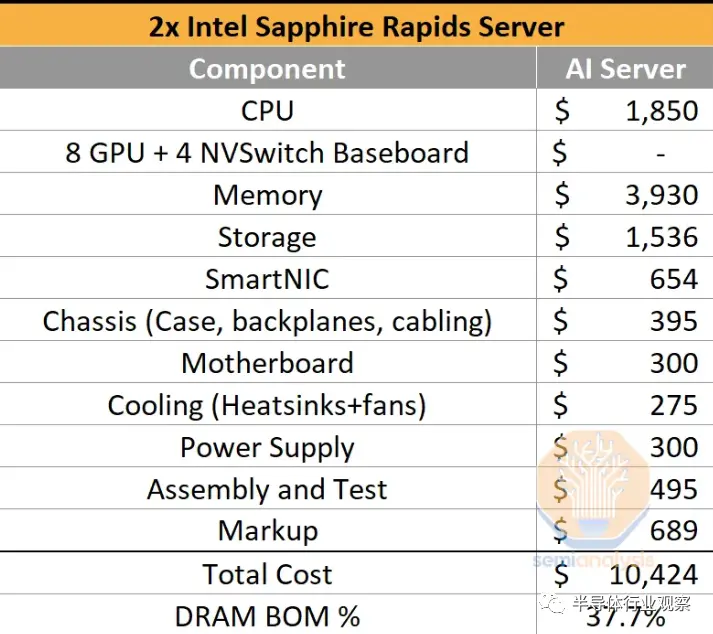

以上是僅標準 CPU 服務器的示范性成本明細。典型的 CPU 服務器差異很大,因此請務必認識到這只是我們認為高性能但高容量的負載。對于大量購買者而言,總成本約為 10,424 美元,其中包括原始設備制造商的約 700 美元利潤。內存幾乎占服務器成本的 40%,每個插槽 512GB,總計 1TB。服務器周圍還有其他一些內存,包括網卡、BMC、管理網卡等,但這些對于 DRAM 端的總成本來說是微不足道的。我們確實將這些組件包含在上下共享的 BOM 成本中。

NAND占總BOM的14.7%。不可否認,許多人已經轉向網絡存儲,所以這個數字比更現代的架構應該有的數字要高得多,但這更多是因為其他服務器有大量的 NAND 和很少的其他東西。內存作為一個整體的成本是傳統服務器部署成本的一半以上。值得一提的是,在這個成本計算中,我們忽略了網絡。

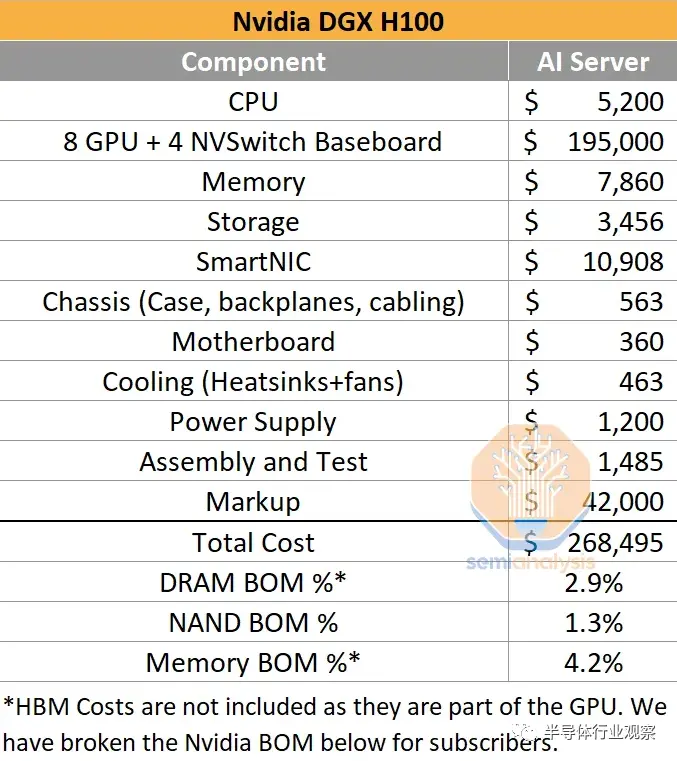

總的來說,雖然仍然會有很多普通服務器,但隨著人工智能時代的到來,它們的比例會降低。單位服務器的百分比將低得多,但以美元計算,差距是巨大的。隨著數據中心轉向加速計算,分配給各種組件的成本發生了巨大變化。Nvidia 的 DGX H100 售價約為 270,000 美元。下面的成本明細包括 Nvidia 在 GPU + Switch 基板和整個 DGX 服務器上的標記。

另外,我們還有一個 8 GPU + 4 NVSwitch 基板 BOM 成本明細,包括供電、內存、組裝、冷卻、GPU 成本、CoWoS 成本、裸片成本、成品率成本、HBM 成本等。

Nvidia 每臺 DGX H100 的毛利潤接近 190,000 美元。當然,研發和其他運營費用會降低很多。無論如何,盡管每臺服務器的 DDR5 內存增長到 2TB,但這種巨大的利潤率伴隨著內存成本占服務器百分比的巨大變化。前端網絡中還會有其他基于 CPU 和存儲的服務器,但在排除 HBM 時,AI 服務器本身分配給內存的總成本不到 5%。

HBM 成本顯然非常重要,特別是考慮到 Nvidia 目前正在單一采購其所有 HBM3。我們在下面為訂戶分擔這些費用。

GPU一卡難求,專家:至少等六個月!

谷歌首席執行官將人工智能革命比作人類對火的駕馭. 現在,要是這個行業能夠確保數字引火物為其提供燃料就好了。

作為新一代人工智能系統生命線的先進芯片的短缺引發了一場鎖定計算能力和尋找解決方法的競賽。用于 AI 的圖形芯片或 GPU 幾乎全部由制造。但隨著ChatGPT 的病毒式成功,對它們的需求激增遠遠超過了供應,ChatGPT 是一種能夠以類似人類的方式回答問題的聊天機器人。

“因為存在短缺,這與你認識的人有關,”Lamini 的聯合創始人兼首席執行官 Sharon Zhou 說,Lamini 是一家幫助公司構建人工智能模型(如聊天機器人)的初創公司。“這就像大流行期間的衛生紙。”

亞馬遜網站和等云服務提供商微軟可以向 ChatGPT 背后的公司 OpenAI 等客戶提供的處理能力。AI 開發人員需要服務器容量來開發和操作他們日益復雜的模型,并幫助其他公司構建 AI 服務。

即使是世界上聯系最緊密的科技企業家也在努力確保產能。在 5 月 16 日關于 AI 的國會聽證會上,OpenAI 首席執行官Sam Altman表示,由于處理器瓶頸,如果使用 ChatGPT 的人少一些會更好。

“在這一點上,GPU 比藥物更難獲得,” Elon Musk在 5 月 23 日告訴華爾街日報CEO 委員會峰會。

不過,成為馬斯克有其好處。知情人士稱,今年早些時候,急需甲骨文計算能力的初創公司突然被告知買家搶購了甲骨文的大部分備用服務器空間。知情人士說,初創公司被告知買家是馬斯克,他正在打造自己的 OpenAI 競爭對手 X.AI。

獲得數以萬計的高級圖形芯片對于培訓可以生成原始文本和分析的大型 AI 模型的公司來說至關重要。創始人說,如果沒有它們,人工智能背后的大型語言模型的工作就會運行得慢得多。Nvidia 的高級圖形芯片擅長同時進行大量計算,這對于 AI 工作至關重要。

瑞銀分析師估計,較早版本的 ChatGPT 需要大約 10,000 個圖形芯片。馬斯克估計更新版本需要 Nvidia 先進處理器的三到五倍。

一些投資者正在梳理他們的網絡以獲得備用計算能力,而另一些投資者則在協調處理器和服務器容量的批量訂單,這些處理器和服務器容量可以在他們的 AI 初創公司之間共享。據 AI 投資者和初創公司稱,初創公司正在縮小他們的 AI 模型以提高效率,他們購買自己的帶有相關圖形芯片的物理服務器,或者轉而使用甲骨文等不太受歡迎的云提供商,直到短缺問題得到解決。

其他創始人只是乞求亞馬遜和微軟的銷售人員獲得更多權力。

周說,她與一位前 Nvidia 工程師共同創立的 Lamini 擁有所需的芯片。她和接受《華爾街日報》采訪的許多其他創始人拒絕確切說明他們是如何獲得這些資產的。

“業界對 GPU 的需求強勁,”OpenAI 發言人表示,并補充說該公司致力于確保其客戶擁有所需的容量。

甲骨文和馬斯克沒有回應置評請求。微軟和亞馬遜拒絕置評。

Nvidia 最近表示,它正在擴大供應以滿足不斷增長的需求,但許多 AI 創始人預計短缺至少會持續到明年。對 Nvidia 產品的需求推動該公司股價上漲約 167%。芯片成本各不相同,但一些零售商以約 33,000 美元的價格出售 Nvidia 的高級 AI 芯片,盡管在需求旺盛的情況下它們可以在二級市場上獲得更高的價格。

一些公司正在封鎖云容量,因為擔心他們以后無法訪問它們。“人們現在只是繼續為它們付費,即使他們不需要它們,”Arthur 的首席執行官 Adam Wenchel 說,該公司開發工具來保護公司免受數據泄露等 AI 風險的影響。

創始人和投資者表示,能夠獲得計算能力的公司仍需等待數周才能使用它。Perplexity AI 的首席執行官 Aravind Srinivas 說:“即使你已經預付了費用,也不意味著 GPU 會在第二天或一周內送到你這里來。”該公司構建了一個人工智能驅動的對話搜索工具。“你只需要等待。”

服務器制造商及其直接客戶表示,他們需要等待六個月以上才能獲得 Nvidia 最新的圖形芯片。Supermicro的首席執行官表示,該公司的圖形芯片系統訂單處于歷史最高水平,該公司正急于增加制造能力。

所有這些都為這些先進的芯片創造了二級市場,部分涉及大型加密公司,這些公司在繁榮時期購買芯片進行采礦,而現在在數字貨幣市場低迷的情況下不需要。

AI研究公司Generally Intelligent的首席執行官邱侃君自去年以來一直在為自己的服務器購買先進的圖形芯片,以渡過當前的短缺。一位風險投資家最近給她發消息,詢問她是否有閑置產能可以出租給其他初創公司。秋還沒有決定是否放棄她的芯片。

與此同時,OpenAI 的奧特曼和其他員工一直在處理來自在其平臺上構建人工智能服務的公司的投訴。

為醫生開發人工智能助手的 Nabla 的首席執行官兼創始人亞歷克斯勒布倫表示,OpenAI 的軟件可能需要長達兩分鐘的時間來響應查詢。Nabla 使用 AI 自動生成筆記、推薦信和臨床建議,其客戶希望這些筆記能夠立即生成。

Lebrun 說,作為一種解決方法,Nabla 已經構建了一些更簡單的模型來更快地生成材料的初稿,然后依靠最新版本的 ChatGPT 進行最終調整。“優秀的初創公司是那些學會如何解決所有這些限制的公司,”Lebrun 說,并補充說他直接向 Altman 提出了這些問題。

Altman 和其他 OpenAI 代表告訴創始人,該公司正在與其最大的投資者和數據中心提供商微軟合作解決這個問題。

【來源:半導體行業觀察】