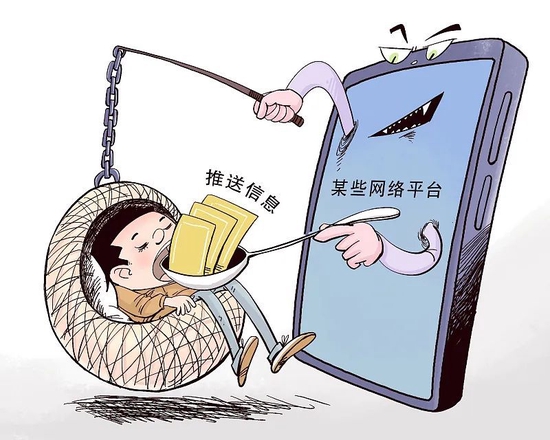

近年來,隨著算法強勢崛起,用戶簡直被“寵上了天”。比如,打開資訊類App,“愛看”的信息總是第一時間躍入眼簾;規劃出行道路時,算法會把最短或最快的路線推薦給我們;點外賣時,平臺會優先呈現評分高、距離近的餐館,等等。

但是算法有時像是“天使”,有時像是“魔鬼”。“困在算法里”儼然成為一種新型社會焦慮,據不完全統計,當前基于算法的個性化內容推送已占整個互聯網信息內容分發的70%左右。平臺通過算法推薦賦予用戶信息定制功能的同時,算法操縱輿論、制造“信息繭房”、濫用數據等亂象也逐漸凸顯出來。

圖源:視覺中國(17.650, -0.16, -0.90%)

那么,今天的我們應該以何種態度對待算法?筆者認為,規范算法推薦需謹防“五種風險”。

一防主流價值觀受到算法沖擊。馬克思曾說過,“人們為之奮斗的一切,都同他們的利益有關。”這句話用在奉行“流量至上”的一些社交平臺上再合適不過。在資本裹挾下,它們將主流價值觀與網民偏好人為割裂開來,想當然地以為“高大上的內容會影響流量”,為獲取流量利益不斷炒作桃色、暴力等事件,導致主流價值的傳播空間被大大擠壓,造成網絡信息“劣幣驅逐良幣”。

比如,一些短視頻平臺時常出現“賣慘營銷”視頻。有媒體報道,這些賣慘視頻的背后,實為一條“吸引眼球—賺取流量—變現獲利”的產業鏈,盡管這些視頻述說著不同的故事,但其共性和本質仍為“求關注”“蹭熱點”。

二防“信息繭房”加劇輿論失焦。網絡輿論被“帶怒黨”引領,被“愛國爽文”收割,被水軍漫灌,都不是罕見現象。當網民在平臺發布熱點事件的相關信息后,平臺根據算法模型,將帖文迅速分發到有同樣標簽的“興趣氣泡”內,形成“回音室效應”,相似觀點、同質化信息的疊加重復,造成話題的高熱不退。

2021年,有網民稱,浙江杭州一女子遭遇“敲門殺人”,并且繪聲繪色地講述“案件”發生過程,在網絡上引發輿論高度關注。盡管后被證實為虛假信息,但在“信息繭房”的助力下,網民不斷參與到類似標簽的話題討論中,無疑加劇了公眾的緊張情緒。

圖源:視覺中國

三防“吃瓜”亂象背后的黑產。“吃瓜群眾”熱衷于“吃瓜”,作為一種群體行為本也無可厚非,可問題在于這種“吃瓜”行為很多時候是被動的。一些內容聚合平臺把算法當作“搖錢樹”,為了激發用戶參與討論,那些劣質低俗,甚至是虛假、極端、刺激、煽動性的內容仿佛成了流量密碼,久而久之,對國家安全和社會穩定造成嚴重挑戰。

很多社交平臺采用信息流漏斗算法,內容創作者上傳內容后,平臺會先投放到一個小的流量池,再根據完播、點贊、評論、轉發、停留時長等指標評分,決定是否投放到更大的流量池。在這種算法機制的作用下,無形中助長了雇傭水軍、刷虛假流量、集中炒作負面輿論等亂象。不法分子將“假瓜”“爛瓜”包裝成“實錘”,不遺余力地調動負面因素,“靶向”推送爭議性話題,加劇了輿論嘯聚和群體對立。

尤其一些刑事案件的網絡輿情,在網民“求安慰”“同吃瓜”等多種社交心理的作用下,經歷群圈交叉傳播后,產生各種“腦補”出來的“恐怖故事”,如“遼寧省中醫院醫生被槍殺,更多細節透露”“南寧萬達茂男子捅死女友后逃跑,背后是令人警醒的真相”等。類似論調將懸疑感拉滿,公眾出于“獵奇”心理,迅速轉向公開平臺討論,對案件細節“抽絲剝繭”,導致熱點輿情難以“退燒”。

四防青少年的觀念被算法帶偏。如今,未成年人刷短視頻上癮成為一種社會現象。有調查報告顯示,20%的青少年“幾乎總是”在看短視頻。短視頻平臺為了搶占有限的注意力,通過精準捕捉青少年的“爽點”和“癢點”,不斷“投喂”無需思考的“爆米花信息”。以“極端女權”“飯圈”兩個圈層為例,這類賬號轉載、發布的內容基本上是男女對立、追星類信息。

試想,青少年一代如果長期沉浸在消遣化、娛樂化內容的“繭房”之中,他們還會潛心思考和琢磨科學、哲學、文學、歷史這些深刻問題嗎?青少年的思考力一旦鈍化,勢必會削弱整個社會、整個民族的創造力,這不得不引起警惕。

五防美西方利用算法加劇對華認知戰。算法看似一個“中立性”的工具,但它可以被政治、商業等非技術力量操縱和改變。美西方在利用社交平臺算法妖魔化中國方面一直有著“不俗表現”,那些美化西方、抹黑中國的言論在推特、臉書等社交平臺上往往擁有更大“被推薦”可能,從而加劇國際輿論偏見。一個比較典型的例子是,新冠疫情暴發后,國際社交平臺利用算法推薦技術,將大量“無腦黑”中國的信息內容,“精準”推送給用戶。

除此之外,美西方也常常“扣準”時間對我國進行隱蔽的輿論操縱,將一些普通的民生問題政治化、國際化,通過機器算法的擴大傳播,將小事炒大、大事炒炸,故意將網民情緒引導到對人權保障、社會治理、體制改革等問題的抨擊上來。2021年,在“成都49中學生墜樓事件”中,美西方利用機器人(11.150, 0.16, 1.46%)賬號大規模轉發,使之迅速形成輿情熱點。

圖源:視覺中國

值得深思的是,面對算法技術的種種侵蝕和“暴擊”,我們應該隨波逐流還是積極應對?《互聯網信息服務算法推薦管理規定》的正式施行,標志著監管的靴子已然落地。人們寄希望于新規能夠一展雄風,管住一度脫韁的算法,但要實現對算法的有效監管,還有一段路要走。

先說分級分類監管思路的確立。正如有學者所說,“算法決策雖然是新事物,卻并非洪水猛獸,監管也要像大禹治水一樣,宜疏不宜堵。如果掄起大棒亂打一氣,把數字產業全都閹割了,用戶也沒嘗到啥甜頭。”所以,算法無處不在的今天,我們所需要的不是簡單粗暴的“一刀切”,在“強監管”基礎上還得有“細監管”。比如,不妨根據算法可能給經濟社會以及個人所帶來的風險程度,探索實行差異化監管,特別是將那些具有輿論屬性或者社會動員能力的算法推薦服務提供者納入嚴格監管,在保障用戶權益的同時,也要考慮對算法發展空間的呵護。

再說網絡空間“人行道”的構建。芝加哥大學法學教授凱斯·桑斯坦認為,公共領域就應該像“人行道”一樣,會遇到種種非計劃和不想要的情景,不同的人群會體認到新鮮體驗。平臺可以探索改進以機器為核心的信息分發模式,建構網絡空間的“人行道”,以增加用戶接觸不同觀點的可能性,營造理性寬容的輿論氛圍,避免一言不合就陷入非理性的“罵戰”。

事實上,2011年帕里澤提出“過濾氣泡”的概念后,就掀起過一場聲勢浩大的“戳泡運動”,主要參與者為媒體、科技公司、非營利性組織,意在幫助人們開放包容地傾聽全方位的聲音。比如,瑞士報紙NZZ開發了一款APP,每次給讀者推薦的信息中都會包含一個“驚喜”,也就是超出讀者原本偏好范圍之外的內容,幫助擺脫“信息繭房”的束縛。

最后說算法與人的“和諧相處”之道。說到底,把算法裝進籠子里的最終目的,還是要回歸到人的主體價值上來,讓算法更好地為用戶服務。終結算法“霸權”,要把算法的選擇權利交還給用戶。平臺可以向用戶提供便捷的關閉算法推薦服務的選項,變“平臺主導”為“用戶選擇”。

總而言之,算法推薦就如硬幣兩面。我們既要清醒認識到算法的正面意義,利用算法技術和規則為社會服務,又要通過良法善治減少或避免其負面影響,這樣才能更好營造風清氣正的網絡輿論環境。