來源:內容編譯自「venturebeat」,謝謝。

我們正在接近深度學習的計算極限。

根據麻省理工學院,MIT-IBM Watson AI實驗室,Underwood國際學院和巴西利亞大學的研究人員的說法,他們在最近的一項研究中發現,深度學習的進展“非常依賴”計算能力的增長。但他們指出,持續不斷的進步將需要通過改變現有技術或通過尚未發現的新方法來“戲劇性地”更有效地使用深度學習方法。

“我們表明,深度學習不是偶然的計算代價,而是設計的代價。共同的靈活性使它能夠出色地建模各種現象,并且性能優于專家模型,這也使其在計算上的成本大大提高。”合著者寫道。“盡管如此,我們發現深度學習模型的實際計算負擔比(理論上的)下界更快地擴展,這表明可能有實質性的改進。”

深度學習是機器學習的子領域,涉及受大腦結構和功能啟發的算法。這些算法(稱為人工神經網絡)由功能(神經元)組成,這些功能按層排列,將信號傳輸到其他神經元。信號是輸入到網絡中的輸入數據的產物,它們從一層到另一層傳播并緩慢地“調諧”網絡,實際上是在調整每個連接的突觸強度(權重)。網絡最終通過從數據集中提取特征并識別交叉樣本趨勢來學習進行預測。

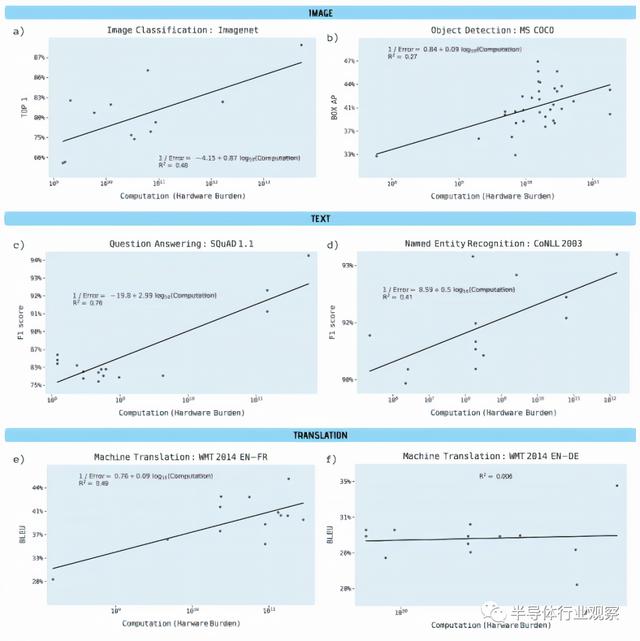

研究人員分析了Arxiv.org以及其他基準測試來源的1,058篇論文,以了解深度學習性能與計算之間的聯系,并特別注意以下領域:圖像分類,對象檢測,問題解答,命名實體識別和機器翻譯。他們對計算需求進行了兩次單獨的分析,反映了可用的兩種信息:

在給定的深度學習模型中,每個網絡遍歷的計算,或單遍遍(即權重調整)所需的浮點運算數。

硬件負擔,或用于訓練模型的硬件的計算能力,計算方式為處理器數量乘以計算速率和時間。(研究人員承認,盡管這是一種不精確的計算方法,但在他們分析的論文中,它的報告比其他基準要廣泛。)

合著者報告說,除從英語到德語的機器翻譯(使用的計算能力幾乎沒有變化)外,所有基準均具有“統計學上顯著性”的斜率和“強大的解釋能力”。對象檢測,命名實體識別和機器翻譯尤其顯示出硬件負擔的大幅增加,而結果的改善卻相對較小,在流行的開源ImageNet基準測試中,計算能力可以解釋圖像分類準確度的43%差異。

研究人員估計,三年的算法改進相當于計算能力提高了10倍。他們寫道:“總體而言,我們的結果表明,在深度學習的許多領域中,訓練模型的進步取決于所使用的計算能力的大幅度提高。”, “另一種可能性是,要改善算法本身可能需要互補地提高計算能力。”

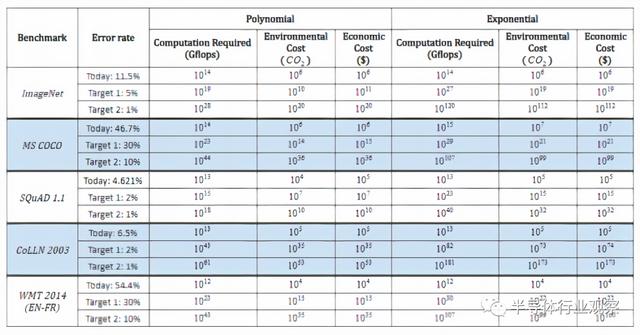

在研究過程中,研究人員還對預測進行了推斷,以了解達到各種理論基準所需的計算能力以及相關的經濟和環境成本。即使是最樂觀的計算,要降低ImageNet上的圖像分類錯誤率,也需要進行10的 五次方以上的計算。

一份Synced報告也估計,華盛頓大學的Grover假新聞檢測模型在大約兩周時間內的訓練費用為25,000美元。據報道,OpenAI花費了高達1200萬美元來訓練其GPT-3 語言模型,而google估計花費了6,912美元來訓練 BERT,這是一種雙向轉換器模型,可為11種自然語言處理任務重新定義最先進的技術。

在去年6月的馬薩諸塞州大學阿默斯特分校的另一份報告中,得出的結論是,訓練和搜索某種模型所需的電量大約排放了626,000磅的二氧化碳。這相當于美國普通汽車壽命排放的近五倍。

研究人員寫道:“我們預計目標所隱含的計算需求……硬件,環境和金錢成本將無法承受。” “以一種經濟的方式實現這一目標將需要更高效的硬件,更高效的算法或其他改進措施,以使凈影響如此之大。”

研究人員指出,在算法級別進行深度學習改進已有歷史先例。他們指出了硬件加速器的出現,例如Google的張量處理單元,現場可編程門陣列(FPGA)和專用集成電路(ASIC),并試圖通過網絡壓縮和加速技術來降低計算復雜性。他們還引用了神經體系結構搜索和元學習,它們使用優化來查找在一類問題上保持良好性能的體系結構,以此作為計算上有效的改進方法的途徑。

確實,一項OpenAI 研究表明,自2012年以來,每16個月將AI模型訓練到ImageNet圖像分類中相同性能所需的計算量就減少了2倍。Google的Transformer架構超越了以前的seq2seq(也是由Google開發的模型),在seq2seq推出三年后,計算量減少了61倍。DeepMind的AlphaZero這個系統從零開始教自己如何掌握國際象棋,將棋和圍棋游戲,而一年后,該系統所需的計算量就減少了八倍,以匹配該系統的前身AlphaGoZero的改進版本。

“用于深度學習模型的計算能力的爆炸式增長已經結束了“人工智能冬天”,并為各種任務的計算機性能樹立了新的基準。但是,深度學習對計算能力的巨大需求限制了它可以以目前的形式提高性能的程度,特別是在硬件性能的提高放緩的時代。” “這些計算限制的可能影響迫使……機器學習轉向比深度學習更高效的技術。”

*免責聲明:本文由作者原創。文章內容系作者個人觀點,半導體行業觀察轉載僅為了傳達一種不同的觀點,不代表半導體行業觀察對該觀點贊同或支持,如果有任何異議,歡迎聯系半導體行業觀察。