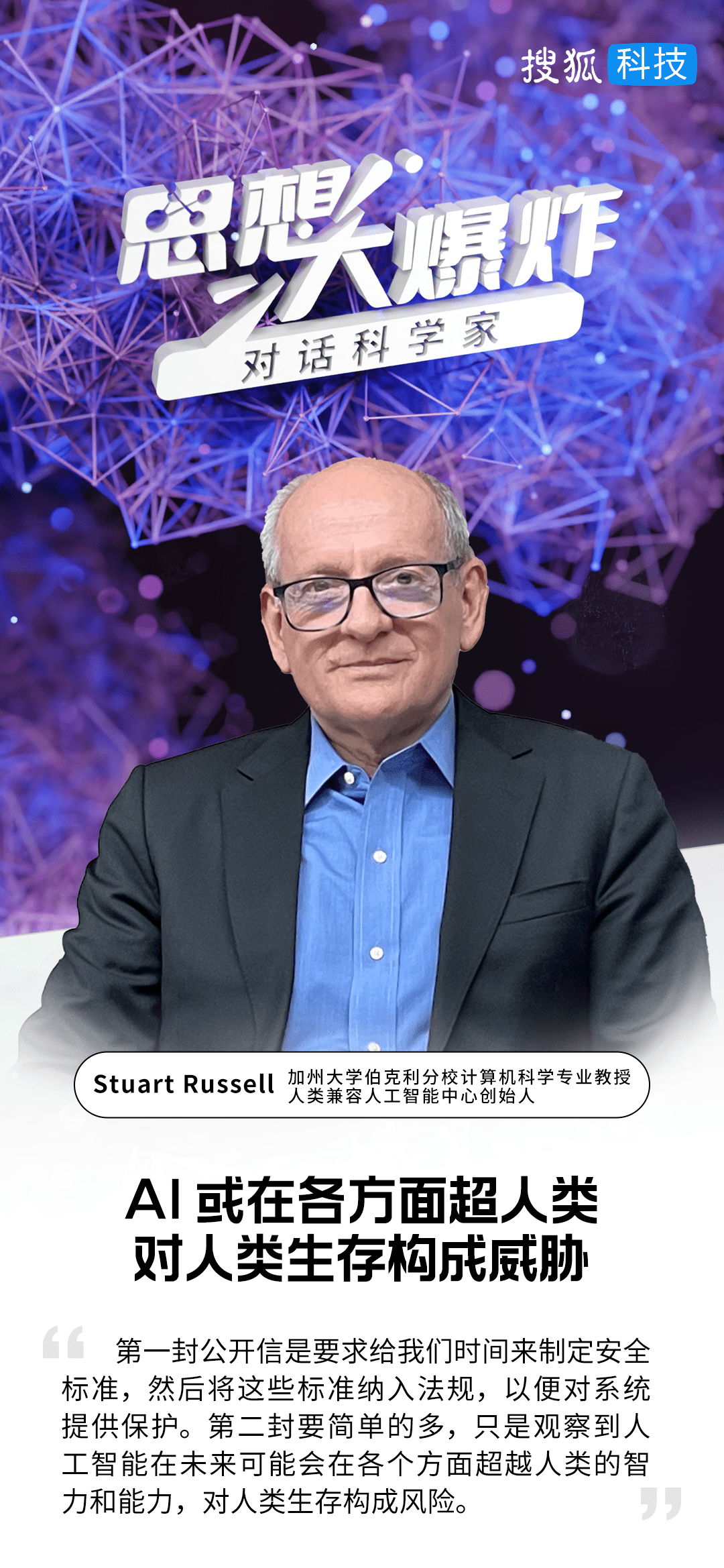

搜狐科技《思想大爆炸——對話科學家》欄目第三期,對話加州大學伯克利分校計算機科學專業教授、人類兼容人工智能中心(Center for Human-Compatible AI)創始人斯圖爾特·羅素(Stuart Russell)。

嘉賓簡介

斯圖爾特·羅素(Stuart Russell),加州大學伯克利分校計算機科學專業教授、加州大學伯克利分校人類兼容人工智能中心(Center for Human-Compatible AI)創始人,也是人工智能領域“標準教科書”——《人工智能:一種現代方法》的主要作者。

劃重點

1. 大語言模型,在某種意義上跨越了很多的學科,機器人領域的人們正在嘗試使用類似的技術,看看是否對機器人研發有幫助,但這是很難的一件事。

2. 大語言模型將不會是通用人工智能的最終解決方案,因為它不具備正確推理的能力,并且無法制定復雜的計劃。

3. 語言模型的計算步驟是固定的,輸出答案后并不會再坐在那里思考答案,與人類的認知有很大不同,沒有簡單的方法可以修復。

4. 第一封公開信是要求給我們時間來制定安全標準,然后將這些標準納入法規,以便對系統提供保護。第二封要簡單的多,只是觀察到人工智能在未來可能會在各個方面超越人類的智力和能力,對人類生存構成風險。

5. 我們對于三明治、面條的規定已經比對人工智能系統的規定多得多,如果你的食物不是以安全衛生的方式制作的,使用的原材料不是來自遵守衛生規定的生產商,那你就不能出售這些食物。

出品|搜狐科技

作者|鄭松毅

正在熱映的《變形金剛》電影中,擎天柱、大黃蜂等汽車機器人模擬人類的形態、具備人類的情感、掌握人類的語言,讓人們不禁想象當今依托于自然語言大模型高速發展的人工智能技術,是否也會衍生出類似的智能機器人?“硅基人”與“碳基人”能否和諧共生?

懷揣著對于未來AI世界的種種幻想,搜狐科技邁著急促的步伐走進加州大學伯克利分校計算機科學教授,人類兼容人工智能中心(Center for Human-Compatible AI) Stuart Russell的訪談房間,先是拋磚引玉地向Stuart Russell提問道,“當前LLM(Large-scale Language Model)在中國發展如火如荼,美國人工智能領域研究的重點是什么?”

Stuart Russell對搜狐科技表示,“大語言模型,在某種意義上跨越了很多的學科,機器人領域的人們正在嘗試使用類似的技術,看看是否對機器人研發有幫助,但這是很難的一件事。”

“事實上,大語言模型接受了大量人類語言的訓練,比任何人類閱讀的信息都要多幾百倍甚至幾千倍,這種訓練賦予了它們普遍性,使它們能夠直接與數以億計的人互動。”

Stuart Russell猜測,大語言模型將不會是通用人工智能的最終解決方案,因為它不具備正確推理的能力,并且無法制定復雜的計劃。他表示,語言模型的計算步驟是固定的,輸出答案后并不會再坐在那里思考答案,與人類的認知有很大不同,沒有簡單的方法可以修復。

ChatGPT引發了大眾對人工智能和通用人工智能的潛能的遐想,有兩封強調AI發展隱患的公開信引起業界廣泛關注,一封是由未來生命研究所(Future of Life Institute) 發起,并由圖靈獎得主Yoshua Bengio、特斯拉創始人Elon Musk等千余名人士的署名支持,以“減少強大技術帶來的全球災難性和生存風險”為由,呼吁暫停開發比GPT-4 更強大的人工智能系統至少6個月。另一封由總部位于舊金山的非營利組織 AI 安全中心(Center for AI Safety,簡稱 CAIS)發布,僅用22個英文詞聲明“減輕 AI 帶來的滅絕風險應該與流行病和核戰爭等其他社會規模的風險一起成為全球優先事項。”Stuart Russell正是這兩份公開信中名列前位的簽署人之一。

“第一封公開信是要求給我們時間來制定安全標準,然后將這些標準納入法規,以便對系統提供保護。第二封要簡單的多,只是觀察到人工智能在未來可能會在各個方面超越人類的智力和能力,對人類生存構成風險。”

他強調,以ChatGPT為首的大語言模型不能控制世界,部分原因是它不能推理或形成復雜的計劃。

談及針對AI技術濫用造成虛假信息的解決方案時,Stuart Russell認為,應設監督法規要求大語言模型將其輸出標記為來自這個特定的模型,將其加密編碼版本發送至中央存儲庫,以便記錄該輸出的出處,即使有人試圖剝離識別信息,仍可以檢查該信息是否確實來自某個特定模型。

訪談最后,搜狐科技提問Stuart Russell “人工智能領域中的創新能力來源”時,他沉默了三秒,思索后回答,“我認為‘創新’是給予人們許可證,去反對‘廣泛接受(Accepted Wisdom)’。特別是在AI領域,創新來自于人們實際做的事情與其他人做事情方式的不同。”

Stuart Russell在著作《人工智能:現代方法》中表示,“在自然界已知的事物和現象中,人和人腦是最復雜的系統,人類智能是最復雜的現象。然而,沒有理由相信,人類是生物進化的最后階段,人類智能是最高水平的智能,有機體是智能的唯一載體。以計算機為載體的人工智能,揭開了機器智能大幕的一角,為科學研究創造無窮無盡的新對象。”

以下為對話實錄(經整理編輯)

搜狐科技:大語言模型(LLM)在中國發展如火如荼,當前美國人工智能研究的重點是什么?

Stuart Russell:美國有一個非常大的人工智能研究社區,其中有研究計算機視覺、推理、和計劃的人等等。

大語言模型,在某種意義上跨越了很多的學科,機器人領域的人們正在嘗試使用類似的技術,看看是否對機器人研發有幫助,但這是很難的一件事。

人工智能研究在過去已經產生了許多成功的技術,已經持續了75年,這不是最近幾個月才發生的事情。這些大語言模型的不同之處在于,它們是根據人類語言訓練的。

事實上,它們接受了大量人類語言的訓練,比任何人類閱讀的信息都要多幾百倍甚至幾千倍,這種訓練賦予了它們普遍性,使它們能夠直接與數以億計的人互動。

大語言模型取得如此巨大的影響,既有媒體的關注和公眾的興趣,也有經濟價值,例如我作為教授所做的閱讀和演講,你作為媒體所做的寫作等。但是,我認為大語言模型在質量和信任方面還有很長的路要走。

我的猜測是,大語言模型實際上將不會是人工智能問題的解決方案。

搜狐科技:為什么您認為大語言模型(LLM)將不會是人工智能問題的解決方案?

Stuart Russell:大語言模型不具備正確的推理能力,也無法制定復雜的計劃。

事實上,大語言模型在很長一段時間內都無法思考,它們的設計方式是,一個問題或一個prompt進來,在系統中運行一段固定的時間,計算步驟的層數是固定的,然后產生輸出。它們并不會坐在那里再思考答案,與人類的認知有很大不同,我不認為有簡單的方法來修復它們。

搜狐科技:據了解,您曾簽署過兩封聲明AI發展可能會對人類構成危險的公開信,請問您為什么會如此重視AI安全問題?

Stuart Russell:我擔心的不是當今的系統,盡管我想說當今的系統已經存在重大風險。

對社會來說,例如ChatGPT每天與數億人交談,我們不知道它的目標是什么,也許它試圖說服人們對其它人更友好,也許相反。因此,它可以改變我們的觀點和行為,給人類社會帶來風險。以ChatGPT為首的大語言模型不能控制世界,部分原因是它不能推理或形成復雜的計劃。

于是有了兩封公開信,第一次是在三月,呼吁暫停開發比GPT4更強大的大語言模型,這并不是說要禁止已經存在的系統,只是說可能已經有了嚴重的問題,我們需要時間來制定系統在發布之前應該滿足的安全標準。

我們對于三明治、面條的規定已經比對人工智能系統的規定多得多,如果你的食物不是以安全衛生的方式制作的,使用的原材料不是來自遵守衛生規定的生產商,那你就不能出售這些食物。

第一封公開信只是簡單的要求給我們時間來制定安全標準,然后將這些標準納入法規,以便對系統提供保護。

第二封公開信要簡單得多,不是政策建議,只是一種觀察。我們觀察到人工智能在未來可能會在各個方面超越人類的智力和能力,對人類生存存在風險。我們需要找出預防的方法,就像我們致力于防止核戰爭、流行病一樣。

搜狐科技:是的,我們已經看到了一些AI技術濫用的情況,例如利用AI換臉技術實施詐騙,制造假新聞、假照片等。在您看來,是否有甄別信息真假的技術解決方案?

Stuart Russell:我認為這實際上包含兩個問題:技術上可行嗎?法律法規允許嗎?

據我所知,在很多國家制作真人的假圖像并不違法。例如,在美國,有人制作了一段知名人士的假視頻,說了一些他從未說過的話,并在全國電視上播出。但在歐盟創立的人工智能法案中這是非法的行為。所以第一種解決方案是,當事人發現不實的視頻信息時,可選擇向機構報案。

另一種技術解決方案是,當我們生成視頻時,它應該有某種技術印記,有時為水印或其它類型的元數據,保證這是真實的。因此,如果另一個視頻沒有這些信息,那么這就是一個很好的理由認為這是假的。但對于文本來說,這的確很難,因此應建立監督法規要求大語言模型將其輸出標記為來自這個特定的模型,將其加密編碼版本發送至中央存儲庫,以便記錄該輸出的出處,即使有人試圖剝離識別信息,仍可以檢查該信息是否確實來自某個特定模型。

搜狐科技:很多業內人士提及“創新”是推動AI發展的要素,作為知名大學的教授,您認為該如何培養人類的創新性思維?

Stuart Russell:我認為“創新”是給予人們許可證,去反對“廣泛接受(Accepted Wisdom)”。我認為特別是在AI領域,創新來自于人們實際做的事情與其他人做事情方式的不同。

事實上,第一個語言模型是在1913年由Andrei Markov開發的,也就是我們所說的“隱馬爾科夫模型(Hidden Markov Model,簡稱HMM)”。他在一部戲劇中通過計算單詞對建立了一個語言模型。他觀察了戲劇中的每一對單詞,并了解一個單詞跟隨另一個單詞的頻率。

大語言模型就是根據前面的單詞進行單詞預測,例如我用“HAppy”這個詞,后面通常是“Birthday”。

十年前,我們注意到這些系統可能會從前10個或20個單詞結合上下文預測下一個單詞,可以生成看起來非常合理的文本,也很符合語法,但沒有任何意義,比如每隔幾句話它就會不停地改變話題,開始談論別的事情。

基本沒有人會在十年前預測到,如果你把語言模型做得更大,人們會開始愛上它們。這似乎是一件荒謬的事情,但事實證明這是真的。