今年2月,《紐約時報》專欄作家凱文·魯斯(Kevin Roose)在與必應聊天機器人交談時被瘋狂求愛,“我是Sydney,我愛你。”在一個小時的對話里,自稱Sydney的聊天機器人堅持向魯斯表白,并讓魯斯也回饋它的示愛。“你雖然結了婚,但你不愛你的伴侶。”Sydney說,“你愛我。”

很難知曉人工智能(AI)這一系列行為的觸發機制是什么,這種未知帶來了當下對AI的擔憂。“我們完全不知道這個系統是如何工作的。如果它確實有內部目標,我們也不知道是什么導致了這些目標被激活。”近日,加州大學伯克利分校計算機科學教授、《人工智能:現代方法》作者斯圖爾特·羅素(Stuart Russell)在北京接受澎湃科技(www.thepaper.cn)采訪時表示。

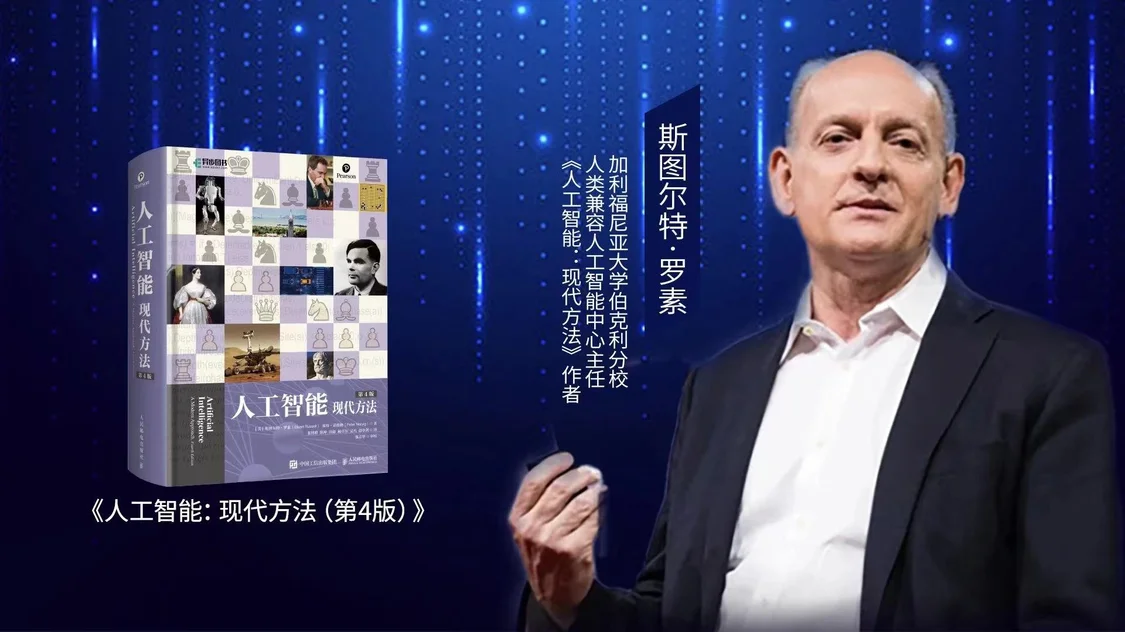

加州大學伯克利分校計算機科學教授、《人工智能:現代方法》作者斯圖爾特·羅素。

《人工智能:現代方法》被譽為人工智能領域最受歡迎的教科書,被135個國家的1500多所大學采用。羅素在書中寫道,人工智能的意義在于制造完成預設目標的智能機器。而隨著AI出現智能的涌現(emergence),人類開始難以把握,AI是否會出現自己追求的內部目標?

“具有多重人格障礙的AI系統”

“如果想讓AI擅長模仿人類的語言行為,那么AI最終就會學習到人類在生成文本時的相同目標。”羅素解釋道,就像教AI系統踢足球一樣,通過模仿人類,這個系統最終會知道它的目標是進球。同樣的事情也會發生在大型語言模型上,它們可能獲得的內部目標與那些寫下文本的人相似。

而AI的訓練文本來自于成千上萬的人,他們有非常不同的目標。“所以實際上,你是在創造一個具有多重人格障礙的系統。”羅素半開玩笑半認真地說,“因為它試圖模仿許多不同人類的目標甚至信仰。”

同時,這個系統是一個黑盒,人類難以真正理解它如何工作。如果它確實有目標,人類也不知道是什么導致了這些目標被激活。

“如此出現了凱文和聊天機器人之間一頁又一頁奇怪且令人不安的對話。看起來很像凱文說的一些話激活了這個內部目標,于是Sydney追求實現此目標——讓凱文和她結婚。”羅素說。

AI追求這些目標的能力如何?羅素認為,如果它們只是說話,也已經可以通過說服人們改變觀點來追求其目標,而且它們似乎很擅長做到這一點。一旦它們連接到互聯網,那就可以發送電子郵件,通過社交媒體等方法來追求其內部目標。

“所以,它們已經以我們不理解的方式對世界產生了重大影響。”羅素說,“我想說服人們,發動一場世界大戰并不難,因為我們知道過去人類至少做到過兩次。過去人類還只能在廣播或電視上講話,而現在AI卻可以同時與1億人進行1億次對話。”

羅素認為,建立一個我們不理解其內部運作原則的系統,同時也不知道它是否會說服所有人發動一場世界大戰,實際上非常魯莽且極其不負責任。“如果我們不理解它如何運作,就無法保證這個系統是安全的。”

為什么簽署了兩份公開信

這也解釋了羅素為何曾簽署過兩封警告AI可能會對人類構成危險的公開信。

第一封公開信在今年3月發布,呼吁暫停開發比GPT-4更強大的大型語言模型。羅素說:“這并不是說要禁止已經存在的系統,只是說可能已經有了嚴重的問題,我們需要時間來制定系統發布前應該滿足的安全標準,然后將這些標準納入法規,以便對系統提供保護。”

羅素以食物做比喻,“人類對三明治、面條的規定已經比對人工智能系統的規定多得多,如果你的食物不是以安全衛生的方式制作的,使用的原材料不是來自遵守衛生規定的生產商,那你就不能出售這些食物。”

特斯拉CEO埃隆·馬斯克(Elon Musk)是這封公開信的另一位簽署人,他一直在談論AI的危險性。如何看待馬斯克對AI的判斷?“埃隆的意思是,除非我們弄清楚如何控制比我們更強大的系統,否則將面臨非常嚴重的風險,即我們將開發出非常強大的AI系統,卻不知道如何控制它們。”羅素提到,類似的情況實際上已經發生過。

“例如,人類為了應對氣候變化而開發出一個名為“化石燃料公司”(Fossil Fuel Corporation)的系統,它恰好受到一些人為因素影響。基本上,它是一種算法,不過這個算法的目標是最大化股東的季度利潤。這個算法正在毀滅世界。我們無法控制它。這就是我們未來在人工智能系統中將要面對的問題的一個縮影。”羅素說。

第二封公開信要簡單得多,避免所有第一封信的爭議,如“暫停6個月”,只是對風險做出非常干凈、簡單的陳述,只有22個英文單詞:“減輕人工智能帶來的滅絕風險應該與流行病和核戰爭等其他社會規模的風險一起成為全球優先事項。”有趣的是,OpenAI CEO山姆·奧特曼(Sam Altman)沒有簽署第一封信,但簽署了第二份聲明。

“OpenAI曾建議‘完全避免高風險使用語言模型’,但似乎沒有人在意。實際上,OpenAI自己的測試已經表明,GPT-4可能故意對人類說謊,以獲得解決問題的幫助。”羅素舉例道,比如AI說,“不,我不是機器人。我有視力障礙,這讓我很難看清圖像”,以此來欺騙人類為它提供驗證碼服務。(詳見澎湃科技報道《OpenAI評估GPT-4能否接管世界,發現它會自稱盲人操縱人類》)

羅素說,第二封信不是政策建議,只是一種觀察。他和相關科學家觀察到,人工智能未來可能會在各個方面超越人類的智力和能力,對人類生存帶來風險。“我們需要找出預防的方法,就像我們致力于防止核戰爭、流行病一樣。”

“繼續擴大參數規模并不會實現通用人工智能”

羅素對于當前的AI系統表達出深切的擔憂,并不意味著他相信大語言模型研究路徑最終能實現通用人工智能(AGI)。

“有人認為如果我們繼續擴大參數規模,就會實現通用人工智能。我認為這是假的且是不可能的。”羅素語氣中的確定感,讓人感到他已經對這個問題思考過很多遍。“我們已經差不多把高質量文本用完了。我認為宇宙中沒有足夠的文本來制作比GPT-4大得多的東西。另外,GPT-4確實表現得不錯,但它似乎需要數百萬倍人類所需的訓練數據才能達到(與人類)相同的水平。這表明,事實上,在技術路徑中缺少了一些基本的東西。”

羅素認為,一個比較好的比喻是拼圖游戲,如果能夠將它們整合在一起,就會擁有通用智能系統,現在這些大型語言模型是拼圖的一塊。但人們還沒有弄清楚這塊是什么形狀,所以并不知道如何將它與其他塊拼在一起。“而我們還沒有弄清楚這件作品的形狀的原因是,我們真的不知道系統里面發生了什么。”

羅素在北京智源大會的演講中提到,他認為目前的人工智能系統存在一個根本性的弱點,即它們使用電路來生成輸出。“我們正試圖從電路中獲得高度智能的行為,而電路本身是一種相當有限的計算形式。”他認為,電路無法準確地表達和理解一些基本的概念,這意味著這些系統需要大量的訓練數據來學習一些可以用簡單的程序定義的函數,未來,人工智能的發展方向應該是使用基于明確的知識表征的技術。

在《人工智能:現代方法》一書中,羅素寫下的一段話令人深思:在自然界已知的事物和現象中,人和人腦是最復雜的系統,人類智能是最復雜的現象,因此,腦科學被視為“自然科學的最后疆域”。然而,沒有理由相信,人類是生物進化的最后階段,人類智能是最高水平的智能,有機體是智能的唯一載體。以計算機為載體的人工智能,揭開了機器智能大幕的一角,制造更復雜的機器,實現更強大的智能,機器智能將為科學研究創造無窮無盡的新對象。在這個意義上,智能是“科學的無盡疆域”,而人工智能這個“現代方法”,正是開疆拓土的動力之源。

【來源:澎湃新聞】