近日,國家網信辦聯合國家發展改革委、教育部、科技部、工業和信息化部、公安部、廣電總局公布《生成式人工智能服務管理暫行辦法》(以下稱《辦法》),自2023年8月15日起施行。

國家互聯網信息辦公室有關負責人表示,出臺《辦法》,旨在促進生成式人工智能健康發展和規范應用,維護國家安全和社會公共利益,保護公民、法人和其他組織的合法權益。

人工智能從上世紀50年代開始萌芽,到近兩年進入全面爆發階段,以ChatGPT為代表的大模型正在引領新一輪全球人工智能技術發展浪潮,深度改變行業生產力,也為網安行業帶來了新變量。

安全矛與盾:大模型的兩面性

安恒信息高級副總裁、中央研究院院長王欣指出,在人工智能時代下,大模型技術存在著“矛”與“盾”的兩面性。

一方面,AI和大模型技術如“利刃”打破原有安全壁壘,安全需求與應用場景發生重大變革。

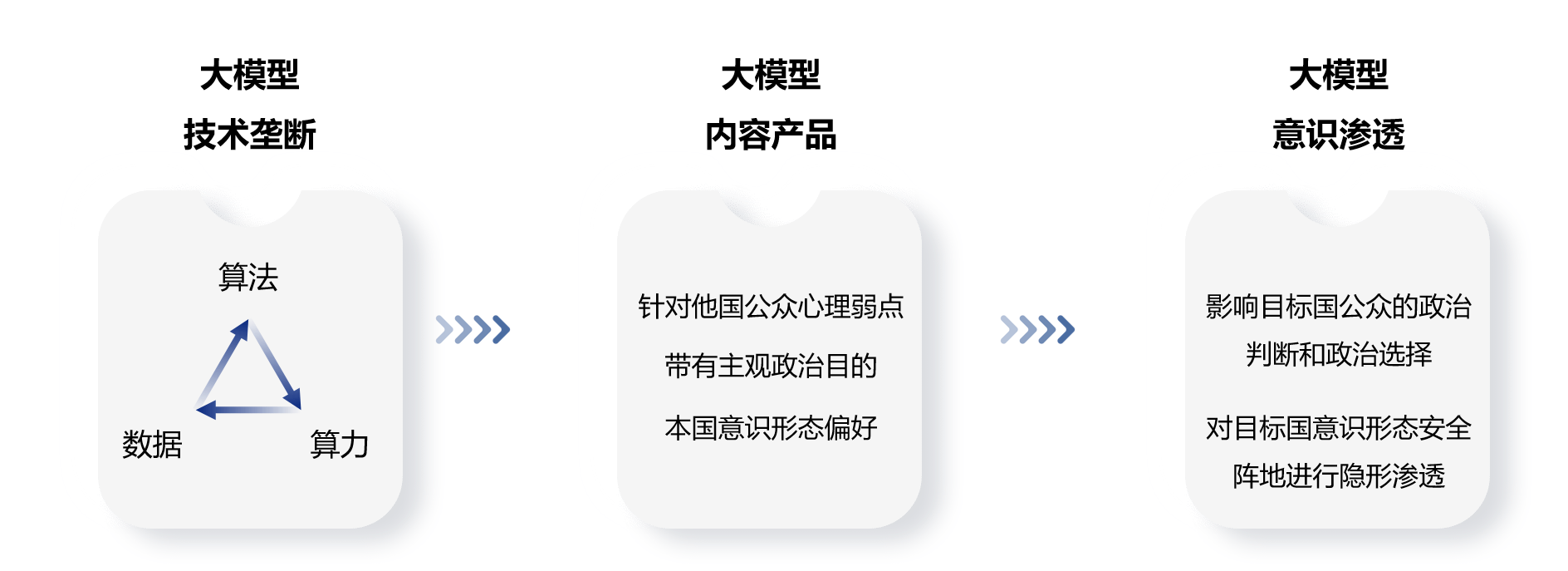

在與生成式人工智能交互的過程中,用戶常常無意識暴露個人信息、商業機密等隱私數據,得到的卻是暗藏平臺價值判斷的內容反饋。個體在認知判斷、行為決策以及價值取向等多個方面,很可能會受到單一算法的不良影響。

如果任由生成式人工智能如脫韁野馬一般肆意發展,虛假信息、偏見歧視乃至意識滲透等問題無法避免,對個人、機構乃至國家安全都存在極大的風險。

因此,《辦法》第三條、第四條在鼓勵支持人工智能創新的同時,也強調了制定相應的分類分級監管規則或者指引的必要性。通過約束數據來源合法性、模型算法公平性、生成內容可靠性,引導AI持續向善。

從世界范圍來看,為打造一個可信的人工智能生態系統,美國、歐盟同樣在探索人工智能治理之道,并通過《人工智能問責政策》、《人工智能風險管理框架》、《人工智能法案》等法律法規來約束人工智能發展,AI監管勢在必行。

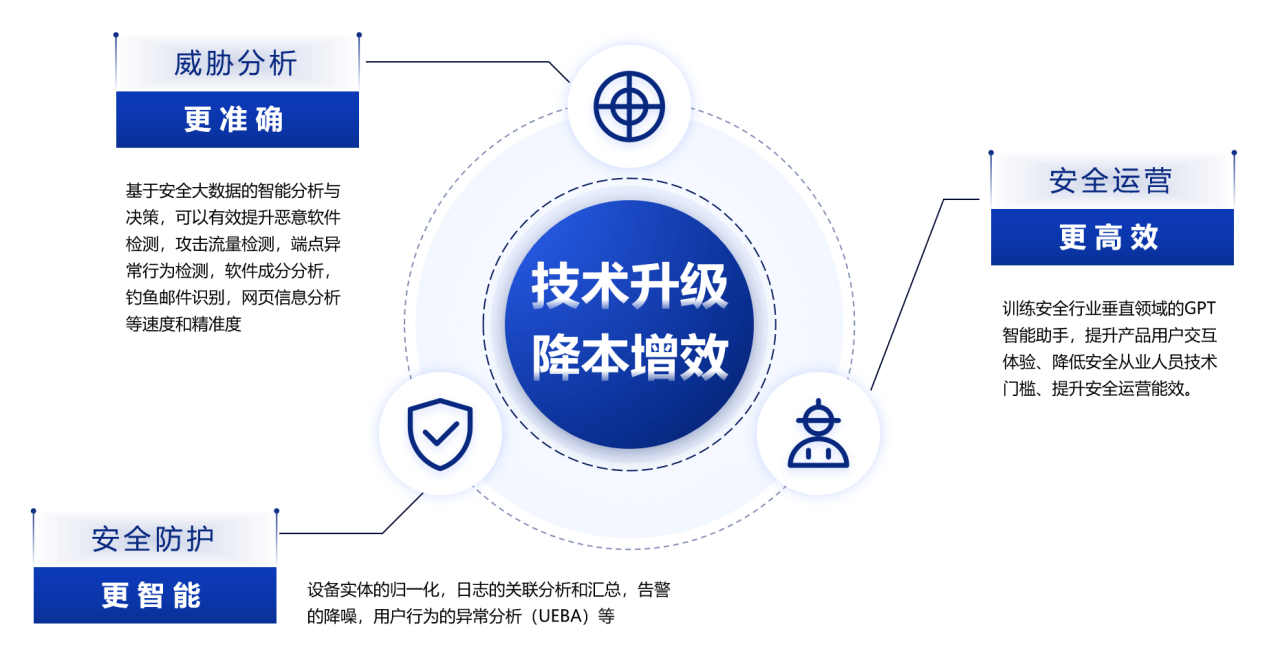

另一方面,AI和大模型技術也促進了安全產品和服務革新,有助于網絡安全防護“盾”優化升級。生成式人工智能能極大提高風險識別效率,在一定程度上彌補現有網絡人才缺口,讓威脅分析更準確、安全運營更高效、安全防護更智能。

讓AI與安全同行

日前,安恒信息高級副總裁、首席科學家劉博在參加2023世界人工智能大會時曾表示:“安全技術要和AI大模型自身的智能技術同步進行,才能有效保障人工智能更可靠、更安全地服務于企業”。

為促進生成式人工智能健康發展,規范數據處理是根本。一個穩健的大模型離不開數據、算力和算法,而在本次《辦法》中,數據是第一高頻詞,出現次數高達18次,數據安全重要性可見一斑。

企業用戶在使用AI大模型過程中,可能會不小心造成數據泄露,或是在訓練模型過程中,存在那些包含了隱私相關或是產權相關的知識歸屬問題。

針對此類數據合規風險,安恒信息已將類大模型應用與智能數據分類分級結合,并對算法模型內生的可靠性與穩健性、透明性與可解釋性、準確性與公平性等風險進行持續性研究。

人工智能是引領新一輪科技革命和產業變革的戰略性技術,從大數據到大模型再到大生態,隨著應用場景資源的持續開放,未來幾年是人工智能技術躍遷的重要窗口期。

安恒信息專注于人工智能結合網絡安全的研究,在時代的發展機遇下,安恒將以創新方式擁抱AI變化,積極推動產品AI智能化,推進“服務+AI”、“治理+AI”、“產業+AI”等應用場景安全升級,為數字經濟發展注入源源不斷的安全動能。