為了挑戰 AI target=_blank class=infotextkey>OpenAI 的 GPT-3.5 和 GPT-4 等閉源模型的主導地位, 一系列開源模型力量正在崛起,包括 LLaMa、Falcon 等。最近,Meta AI 發布了 LLaMa-2 模型,被譽為開源領域最強的大模型,很多研究者也在此基礎上搭建自己的模型。比如,StabilityAI 利用 Orca 風格的數據集對 Llama2 70B 模型進行了微調,打造出了 StableBeluga2,在 Huggingface 的 Open LLM 排行榜中也取得了不錯的成績。

最近,Open LLM 榜單的排行又發生了新的變化,一個名叫 Platypus(鴨嘴獸)的模型登上了榜首。

概括地說,Platypus 同樣是基于 Llama 2 微調。來自波士頓大學的作者使用了 PEFT 和 LoRA 以及數據集 Open-Platypus 進行優化。

在一篇論文中,作者對 Platypus 進行了詳細的介紹:

論文地址:https://arxiv.org/abs/2308.07317

本文的貢獻主要有以下幾點:

- Open-Platypus 是一個小規模的數據集,由公共文本數據集的精選子集組成。該數據集由 11 個開源數據集組成,重點是提高 LLM 的 STEM 和邏輯知識。它主要由人類設計的問題組成,只有 10% 的問題是由 LLM 生成的。Open-Platypus 的主要優勢在于其規模和質量,它可以在很短的時間內實現非常高的性能,并且微調的時間和成本都很低。具體來說,在單個 A100 GPU 上使用 25k 個問題訓練 13B 模型只需 5 個小時。

- 描述了相似性排除過程,減少數據集的大小,并減少數據冗余。

- 詳細分析了始終存在的開放 LLM 訓練集與重要 LLM 測試集中包含的數據相污染的現象,并介紹了作者避免這一隱患的訓練數據過濾過程。

- 介紹了對專門的微調 LoRA 模塊進行選擇和合并的過程。

Open-Platypus 數據集

目前,作者在 Hugging Face 上發布了 Open-Platypus 數據集:

污染問題

本文方法優先考慮防止基準測試問題泄漏到訓練集中,以避免僅通過記憶產生結果偏差。作者努力追求準確性的同時,也認識到標記重復問題時需要靈活性,因為問題的提出方式多種多樣,而且會受到通用領域知識的影響。為了管理潛在的泄漏,作者精心設計了啟發式方法,用于手動過濾 Open-Platypus 中與基準問題余弦嵌入相似度超過 80% 的問題。他們將潛在泄漏分為三類:(1) 重復;(2) 灰色區域;(3) 相似但不相同。并且,為謹慎起見,他們將所有組別都排除在訓練集之外。

重復

這幾乎完全復制了測試題集的內容,可能只是稍稍改動了一下單詞或稍作重新排列。根據上表中泄漏問題的數量,這是作者認為真正屬于污染的唯一類別。具體例子如下:

灰色區域

以下問題被稱為灰色區域,包括并非完全重復、屬于常識范疇的問題。雖然作者將這些問題的最終評判權留給了開源社區,但他們認為這些問題往往需要專家知識。需要注意的是,這類問題包括指令完全相同,但答案卻同義的問題:

相似但不相同

這些問題的具有較高的相似度,但由于問題之間有著細微的變化,在答案上存在著顯著差異。

微調與合并

在完善數據集之后,作者將重點放在兩種方法上:低秩近似(LoRA)訓練和參數高效微調(PEFT)庫。與完全的微調不同,LoRA 保留了預訓練的模型權重,并在 transformer 層中整合了秩分解矩陣。這就減少了可訓練參數,節省了訓練時間和成本。起初,微調主要針對注意力模塊,如 v_proj、q_proj、k_proj 和 o_proj。后來,根據 He et al. 的見解,過渡到 gate_proj、down_proj 和 up_proj 模塊。除了可訓練參數小于總參數的 0.1% 時,這些模塊均顯示出了更好的效果。作者對 13B 和 70B 模型統一采用了這一方法,結果可訓練參數分別為 0.27% 和 0.2%。唯一的差異在于這些模型的初始學習率。

結果

作者將 Platypus 與其他的 SOTA 模型進行了比較。根據 2023 年 8 月 10 日的 Hugging Face Open LLM 排行榜數據,Platypus2-70Binstruct 變體表現優于其他競爭對手,以 73.13 的平均分穩居榜首:

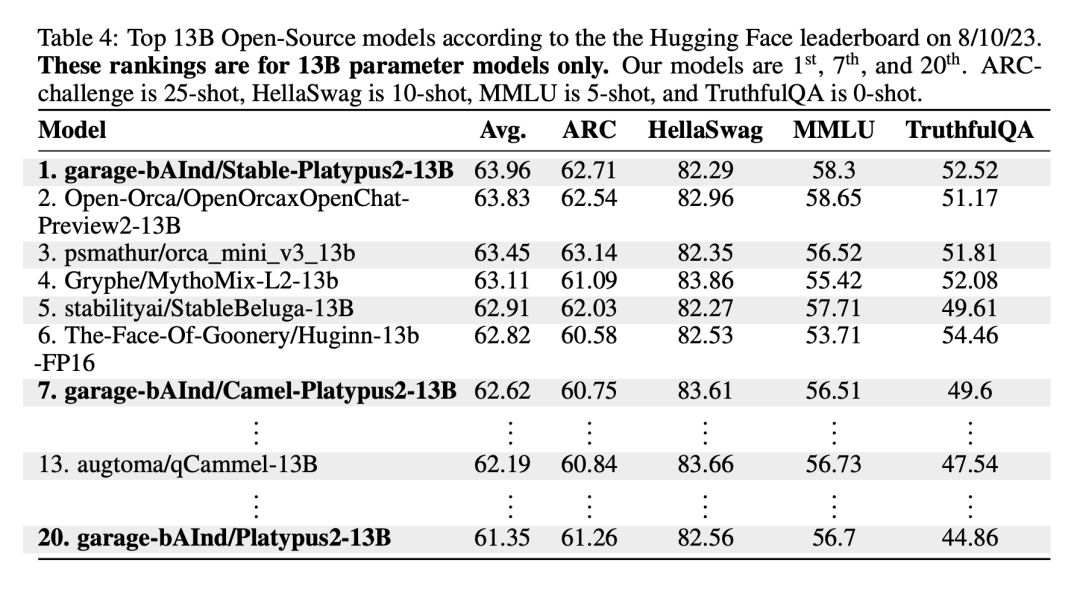

值得注意的是,Stable-Platypus2-13B 模型以 63.96 的平均分成為 130 億參數模型中的佼佼者:

局限性

作為 LLaMa-2 的微調擴展,Platypus 保留了基礎模型的許多限制條件,并因其有針對性的訓練而引入了特定的挑戰。它共享 LLaMa-2 的靜態知識庫,而知識庫可能會過時。此外,還存在生成不準確或不恰當內容的風險,尤其是在提示不明確的情況下。雖然 Platypus 在 STEM 和英語邏輯方面得到了增強,但它對其他語言的熟練程度并不可靠,而且可能不一致。它偶爾也會產生帶有偏見或有害的內容。作者表示已經努力減少這些問題,但挑戰依然存在,尤其是在非英語語言方面。

Platypus 可能會被濫用于惡意活動,這也是一個令人擔憂的問題。開發人員應在部署前對其應用程序進行安全測試。Platypus 在其主要領域之外可能存在局限性,因此用戶應謹慎行事,并考慮進行額外的微調以獲得最佳性能。用戶應確保 Platypus 的訓練數據與其他基準測試集之間沒有重疊。作者對數據污染問題非常謹慎,避免與在有污點的數據集上訓練的模型合并。雖然經過清理的訓練數據中確認沒有污染,但也不排除有些問題漏掉了。如需全面了解這些限制,請參閱論文中的限制部分。