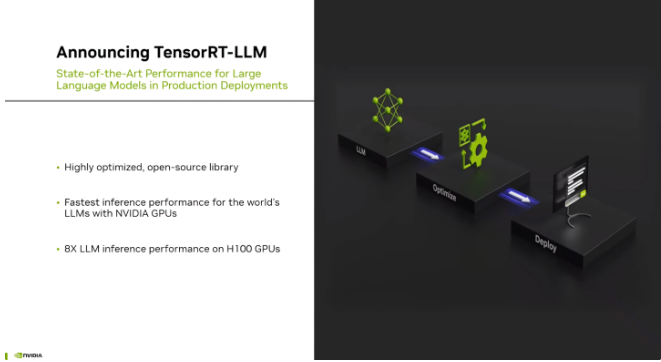

【ITBEAR科技資訊】9月9日消息,英偉達公司今日宣布推出了一項名為TensorRT-LLM的創新項目,旨在大幅提升其Hopper系列AI GPU上的語言模型推理性能。根據英偉達的介紹,TensorRT-LLM是一款深度優化的開源庫,利用了一系列尖端技術,包括SmoothQuant、FlashAttention和fMHA等,以加速處理大型語言模型,如GPT-3(175 B)、Llama Falcom(180 B)和Bloom等模型。

據悉,TensorRT-LLM的一個顯著特點是引入了一種名為In-Flight Batching的調度方案,這使得GPU能夠在處理大型計算密集型請求時,同時動態處理多個較小的查詢。這一創新性的方案不僅提高了GPU的性能,還使得H100型號的吞吐量提高了2倍。

在性能測試方面,英偉達以A100作為基準,對比了H100和啟用了TensorRT-LLM的H100。在GPT-J 6B模型的推理性能測試中,H100相比A100提升了4倍,而啟用了TensorRT-LLM的H100性能更是達到了A100的8倍。而在Llama 2模型上,H100相比A100提升了2.6倍,而啟用了TensorRT-LLM的H100性能則高達A100的4.6倍。

這一重大突破意味著英偉達將繼續領導AI硬件領域的發展,通過優化其GPU性能,為大型語言模型等計算密集型任務提供更快速和高效的計算支持。據ITBEAR科技資訊了解,這將對人工智能應用在各個領域的發展產生積極影響,為未來的科技創新打開更廣闊的可能性。