K-最近鄰算法(K-Nearest Neighbor,KNN)是一種經典的有監(jiān)督學習方法,也可以被歸為懶惰學習(Lazy Learning)方法。它基于“物以類聚”的原理,假設樣本之間的類別距離越近則它們越有可能是同一類別。

KNN算法的工作原理簡單且直觀,當需要將一個測試樣本分類時,它首先會計算測試樣本與所有訓練樣本之間的距離,然后根據距離的遞增關系進行排序。接著,它會選擇距離最小的前K個樣本,并統(tǒng)計這K個最近鄰樣本中每個樣本出現(xiàn)的次數。最后,它會選擇出現(xiàn)頻率最高的類標號作為未知樣本的類標號。

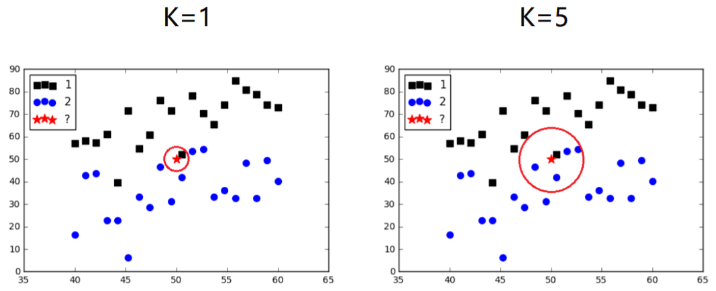

在KNN算法中,K值的選擇是關鍵。如果K值較小,只有當需要進行預測的樣本和訓練的樣本較接近時,才能有較好的效果。如果K值較大,則算法分類的近似誤差增大,與輸入樣本距離較遠的樣本也會對結果產生作用。

KNN算法的工作過程如下:

1. 計算待分類樣本與訓練集中所有樣本之間的距離,常用的距離度量方法包括歐氏距離、曼哈頓距離等。

2. 選擇K個距離最近的樣本,即K個最近鄰。

3. 對于分類問題,統(tǒng)計K個最近鄰中不同類別的樣本數量,并將待分類樣本歸為數量最多的那個類別。

4. 對于回歸問題,計算K個最近鄰的平均值或加權平均值,并將其作為待分類樣本的預測值。

KNN算法的優(yōu)點是簡單易理解、實現(xiàn)容易,并且對于非線性問題具有較好的表現(xiàn)。此外,KNN算法可以適應新的訓練數據,不需要重新訓練模型。KNN算法既能夠用來解決分類問題,也能夠用來解決回歸問題。在處理分類問題時,KNN通過掃描訓練樣本集找到與測試樣本最相似的訓練樣本,并依據該樣本的類別進行投票確定測試樣本的類別。在處理回歸問題時,KNN則通過計算訓練樣本與測試樣本的相似程度進行加權投票。

然而,KNN算法的缺點包括計算復雜度高,需要存儲全部訓練樣本,對于大規(guī)模數據集會消耗較多的內存和時間。此外,KNN算法對于樣本分布不平衡的情況可能產生偏見,并且對于高維數據和噪聲數據的處理能力相對較弱。

需要注意的是,由于KNN算法需要計算所有訓練樣本與測試樣本之間的距離,因此當訓練樣本集較大時,其計算成本會較高。為了解決這個問題,可以考慮使用一些優(yōu)化的距離計算方法,如樹結構算法等。同時,KNN算法的方差(Variance)往往較高,容易受到訓練集大小和噪聲的影響,因此在使用時需要注意過擬合和欠擬合的問題。

在應用方面,KNN算法常用于推薦系統(tǒng)、圖像識別、醫(yī)學診斷等領域。