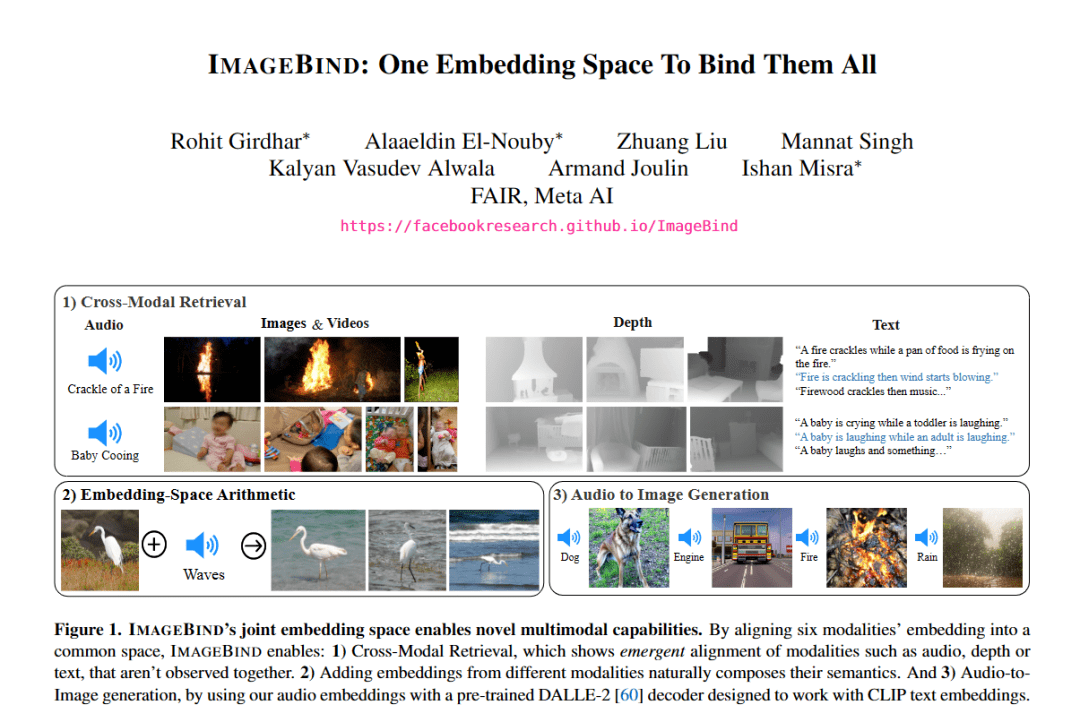

最近,MetAImage在技術圈引起了極大的好評。在《IMAGEBIND:One Embedding Space To Bind Them All》的論文中,通過一個嵌入空間,Meta 的 ImageBind 將五種不同的模態與圖像進行連接配對,非常精彩。

1、“跨五感”的模型問世

比如,給你看一張海灘的圖片,你就會聯想到海浪的聲音、咸味的空氣和你周圍的熱浪,反過來,如果你聽到打鼾,你可以想象一個人躺著進入深度睡眠中的畫面。

這的確也很符合常識:人類可以根據圖像想象出氣味、聲音以及空間的感覺,反之亦然。

那么 AI 能像人類一樣將許多不同且不相關的模式綁定在一起嗎?Meta AI發表的ImageBind論文就是解決了這個問題。

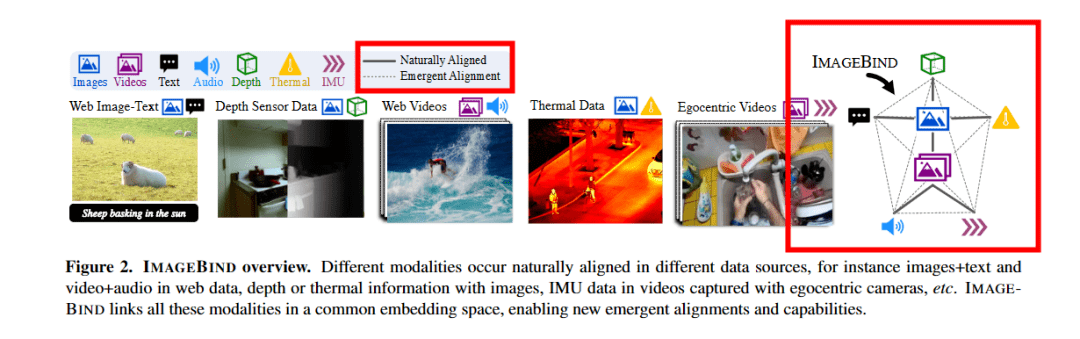

為了“綁定”多種模式,而不僅僅是文本和圖像,該論文的研究人員將圖像作為主要數據,并測試了音頻、熱圖(熱像儀)、文本和 IMU(慣性測量,一系列加速度計、陀螺儀等)和深度。

為了將深度和文本等兩種不相關的模式聯系起來,研究人員使用了對比學習(Contrastive Learning)。將圖像數據作為主要要求,論文中顯示了代表任何給定數據中可用的圖像實際鏈接的粗實線。

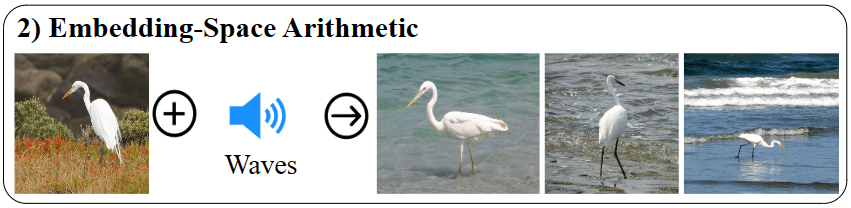

接下來,研究人員展示了緊急鏈接是如何發生的,現在您可以獲取音頻和文本數據點并獲得正確的圖像或視頻。這種能力以前并不存在;這是新興(emergent Link)的。使用成對的對齊觀察值(例如吠叫聲和文本“狗”),它可以正確地將輸出提供一張狗的圖像。論文中給出的另一個例子是鸛的圖像和海浪的聲音結合了模態,并顯示了鸛在水中的圖像。

這篇論文的基礎在于,人們實際上并不需要數據對與圖像連接在一起。例如,只需將深度或熱圖信息與文本(具有與圖像的實際聯結)配對,用戶就可以創建包含所有這三個信息的圖像。該論文將這種現象稱為“快速對齊(emergent alignment)”。

2、為什么不采用 Meta 的數據集

Meta 的 Facebook 擁有最大的圖像和文本配對數據集之一。奇怪的是,研究人員沒有使用他們自己的數據集,而是使用了 OpenAI 的CLIP數據集,然而,可能使用Meta自己在過去十年中收集的數據集來訓練這個模型本應該是有意義的。另一方面,沒有任何 GPT-4多模式架構的跡象。

但機器人研究員 Hugo Ponte 卻不覺得這樣,并認為 Meta 使用 CLIP 是一個明智之舉。

首先,CLIP 是一個為圖像和語言創建共享嵌入空間的模型,非常強大。在 CLIP 數據集上添加 ImageBind 使得該模型不僅適用于文本,而且幾乎適用于論文中提到的所有其他模式。如果用戶有音頻、IMU、熱圖、深度和文本數據,開發者可以創建最接近該數據的圖像。

Ponte 進一步分析了這篇論文和作者選擇 CLIP 的原因——“我認為這是一個明智之舉,這樣,他們沒有改變 CLIP 嵌入空間,這意味著你實際上可以返回到過去三年里發布的每一篇使用 CLIP 的論文,并可以直接插入 ImageBind 來替代使用。”

通過使用 ImageBind,我們可以將任何內容投射到 CLIP 中。“他們沒有取代CLIP,而是擴展了 CLIP,這讓它變得更好,因為 CLIP 也適用于對比學習,需要圖像和圖像顯示的文本的配對示例。”Ponte 補充道。

此外,ImageBind 作者還采用了 Vision Transformer (ViT),這是一種當今常見的架構,可以為不同模式的相關概念創建類似的嵌入,例如將“狗”與狗的圖像相關聯。

3、下一步是什么

不出所料,Meta 也開源了代碼,但有趣的是也給商業目的戴上了緊箍咒,不允許商用。然而,開發人員已經使用 ImageBind 構建了一個巧妙的搜索引擎演示。搜索引擎使用文本、音頻甚至視覺輸入檢索人工智能生成的圖像。

Meta AI 負責人 Yann LeCun 表示,該模型沒有公開發布可能是出于法律原因,也可能是因為它只是第一篇具有如此廣泛模式的論文。這減緩了該論文的采用速度,僅在其上開發了幾個演示。

然而,廣泛的模式看起來像是向 Yann Lecun 的AGI 方法邁出的一步。到目前為止,該模型可以從不同的“感官”中學習,以生成模仿人類如何感知世界的正確圖像。