這合理嗎?

誰都沒有想到,ChatGPT 的核心秘密是由這種方式,被微軟透露出來的。

昨天晚上,很多討論 AI 的微信群都被一篇 EMNLP 論文和其中的截圖突然炸醒。

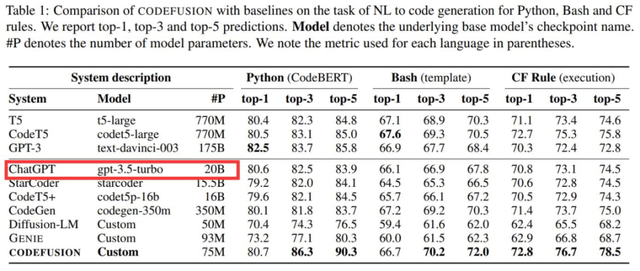

微軟一篇題為《CodeFusion: A Pre-trained Diffusion Model for Code Generation》的論文,在做對比的時候透露出了重要信息:ChatGPT 是個「只有」20B(200 億)參數的模型,這件事引起了廣泛關注。

距 ChatGPT 發布已經快一年了,但 OpenAI 一直未透露 ChatGPT 的技術細節。由于其強大的模型性能,人們對 ChatGPT 的參數量、訓練數據等信息抱有諸多疑問和猜測。

作為行業一直以來的標桿,ChatGPT 性能強大,可以解決各種各樣的問題。它的前身 GPT-3 參數量就達到了 1750 億,實用化以后的大模型居然被 OpenAI 瘦身了快 9 倍,這合理嗎?

「如何看待這篇論文」的話題立刻沖上了知乎熱榜。

論文鏈接:

https://arxiv.org/abs/2310.17680

具體來說,微軟這篇論文提出了一種預訓練的擴散代碼生成模型 ——CodeFusion。CodeFusion 的參數量是 75M。在實驗比較部分,論文的表 1 將 ChatGPT 的參數量明確標成了 20B。

眾所周知,微軟和 OpenAI 是合作已久的一對伙伴,并且這是一篇 EMNLP 2023 論文,因此大家推測這個數據很有可能是真實的。

然而,關于 ChatGPT 參數量的猜測,人們一直認為是一個龐大的數字,畢竟 GPT-3 的參數量就已經達到了 175B(1750 億)。掀起大型語言模型(LLM)浪潮的 ChatGPT,難道就只有 20B 參數?

大家怎么看?

這個數據被扒出來之后,在知乎和 Twitter 已經引起了廣泛討論。畢竟,200 億參數達到這樣的效果十分驚人。再則,國內追趕出的大模型動則就是數百億、上千億。

那么這個數據保不保真?大家都有什么看法呢?

NLP 知名博主、新浪微博新技術研發負責人張俊林「盲猜」分析了一波,引起了大家廣泛贊同:

不負責任猜測一波:GPT 4 是去年 8 月做好的,ChatGPT 估計是 OpenAI 應對 Anthropic 要推出的 Claude 專門做的,那時候 GPT 4 應該價值觀還沒對齊,OpenAI 不太敢放出來,所以臨時做了 ChatGPT 來搶先發優勢。OpenAI 在 2020 年推出 Scaling law 的文章,Deepmind 在 2022 年推出的改進版本 chinchilla law。OpenAI 做大模型肯定會遵循科學做法的,不會拍腦袋,那么就有兩種可能:

可能性一:OpenAI 已經看到 Chinchilla 的論文,模型是按照龍貓法則做的,我們假設 ChatGPT 的訓練數據量不低于 2.5T token 數量(為啥這樣后面分析),那么按照龍貓法則倒推,一般訓練數據量除以 20 就應該是最優參數量。于是我們可以推出:這種情況 ChatGPT 模型的大小約在 120B 左右。

可能性二:OpenAI 在做 ChatGPT 的時候還沒看到 Chinchilla 的論文,于是仍然按照 OpenAI 自己推導的 Scaling law 來設計訓練數據量和模型大小,推算起來訓練數據量除以 12.5 左右對應模型最優參數,他們自己的 Scaling law 更傾向把模型推大。假設訓練數據量是 2.5T 左右,那么這種情況 ChatGPT 的模型大小應該在 190 到 200B 左右。

大概率第一個版本 ChatGPT 推出的時候在 200B 左右,所以剛出來的時候大家還是覺得速度慢,價格也高。3 月份 OpenAI 做過一次大升級,價格降低為原先的十分之一。如果僅僅靠量化是不太可能壓縮這么猛的,目前的結論是大模型量化壓縮到 4 到 6bit 模型效果是能保持住不怎么下降的。

所以很可能 OpenAI 這次升級從自己的 Scaling law 升級到了 Chinchilla 的 Scaling law,這樣模型大小就壓縮了 120B 左右,接近一半(也有可能遠小于 120B,如果按照 chinchilla law,llama 2 最大的模型應該是 100B 左右,此時算力分配最優,也就是說成本收益最合算。但是實際最大的 llama2 模型才 70B,而且更小的模型比如 7B 模型也用超大數據集。

llama1 65B 基本是符合 chinchilla law 的,llama2 最大模型已經打破 chinchilla law 開始懟數據了。就是說目前大家做大模型的趨勢是盡管不是算力分配最優,但是都傾向于增加數據減小模型規模,這樣盡管訓練成本不合算,但是推理合算,而訓練畢竟是一次性的,推理則并發高次數多,所以這么配置很明顯總體是更合算的),再加上比如 4bit 量化,這樣推理模型的大小可以壓縮 4 倍,速度大約可提升 8 倍左右,如果是采取繼續增加訓練數據減小模型規模,再加上其它技術優化是完全有可能把推理價格打到十分之一的。

后續在 6 月份和 8 月份各自又價格下調了 25%,最終可能通過反復加數據減小規模逐漸把模型壓縮到 20B 左右。

這里解釋下為何 ChatGPT 的訓練數據量不太可能比 2.5T 低,LLaMA 2 的訓練數據量是 2T,效果應該稍弱于 ChatGPT,所以這里假設最少 2.5T 的訓練數據。目前研究結論是當模型規模固定住,只要持續增加訓練數據量,模型效果就會直接增長,mistral 7B 效果炸裂,歸根結底是訓練數據量達到了 8 個 T,所以導致基礎模型效果特別強。以 ChatGPT 的效果來說,它使用的數據量不太可能低于 2.5T。

當然,還有另外一種可能,就是 ChatGPT 在后期優化(比如第一次大升級或者后續的升級中,開始版本不太可能走的這條路)的時候也不管 scaling law 了,走的是類似 mistral 的路線,就是模型大小固定在 20B,瘋狂增加訓練數據,如果又構造出合適的 instruct 數據,效果也可能有保障。

不論怎么講,對于 6B 到 13B 左右比較適合應用落地的模型,強烈呼吁中文開源模型模仿 mistral,固定住一個最適合使用的模型大小,然后瘋狂增加訓練數據,再加上好的 instruct 策略,是有可能作出小規模效果體驗足夠好的模型的。我個人認為對于開源模型來說,7B-13B 左右大小的模型應該是兵家必爭之地。有心氣做開源的可以再努把力,把訓練數據往上再努力懟一懟。

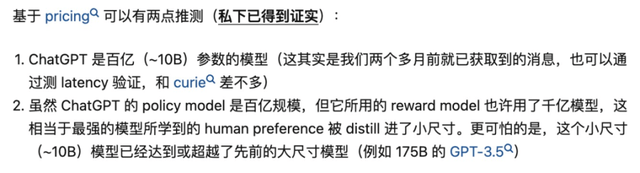

早在 OpenAI 開放 ChatGPT API 時,0.002 美元 / 1k token 的定價就令人們意外,這個價格只有 GPT-3.5 的 1/10。彼時就有人推測:「ChatGPT 是百億(~10B)參數的模型」,并且「ChatGPT 使用的獎勵模型(reward model)可能是千億級模型」。該推測來源于清華大學 NLP 在讀博士鄭楚杰的知乎回答。

原回答鏈接:

https://www.zhihu.com/question/587083296/answer/2918080518

而國內外許多網友也都認為,200 億的參數,是完全合理的。

也有知乎網友從價格上分析,這個數據也應該是對的。

當然,也有網友認為這可能是個「拼寫錯誤」,或許實際是 120B(1200 億),至少 120B 和 GPT-3(175B)是一個數量級。

但所有這些都是猜測,由于 OpenAI 對參數量、訓練數據、方法等核心信息一直諱莫如深,因此 20B 這個數據到底是不是真的根本無法求證。如果是真的,那么大型語言模型未來的改進方向還會是增加參數量嗎?

再過幾天,就是 OpenAI 的開發者大會了,也許我們能夠了解到更多有用的信息,讓我們拭目以待吧。

參考內容:

https://www.zhihu.com/question/628395521

https://twitter.com/felix_red_panda/status/1718916631512949248