英偉達Eureka在超過80%的任務中都超越人類專家,讓機器人平均性能提升到50%以上。

訓練機器人,AI比人類更拿手!

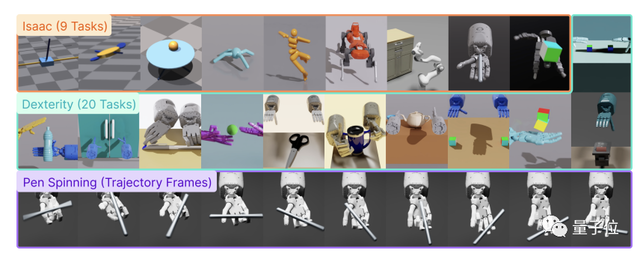

英偉達最新AI AgentEureka ,用GPT-4生成獎勵函數,結果教會機器人完成了三十多個復雜任務。

比如,快速轉個筆,打開抽屜和柜子、拋球和接球。

尤其是轉筆這個技能,要知道靠人類逐幀制作動畫,也是非常困難的。

最終,Eureka在超過80%的任務中都超越人類專家,讓機器人平均性能提升到50%以上。

這一研究吸引了數十萬網友關注,有人表示:直接快進到它彈鋼琴那天,直接為大眾所用。

英偉達科學家,也是此次共同作者之一Jim Fan評價到,它是超級人類獎勵工程師。它可以輔助機器人工程師設計復雜任務。

目前該項目完全開源。

GPT-4生成獎勵策略

在機器人學習中,大模型擅長生成高級語義規劃和中級操作,比如拾取和放置(VIMA、RT-1等),但在復雜任務控制方面有所欠缺。

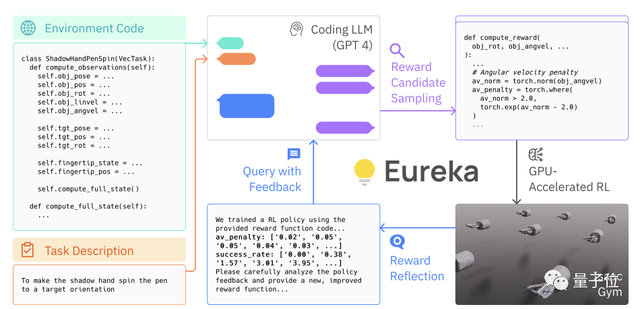

而Eureka的關鍵所在,就是通過上下文來實現了人類水平的獎勵算法設計。

簡單來說,就是用GPT-4的零樣本生成、代碼編寫以及上下文改進功能,對獎勵執行策略進行優化,由此通過強化學習來進行復雜的技能。

研究人員提出了一種混合梯度架構,外循環運行 GPT-4 來細化獎勵函數(無梯度),而內循環運行強化學習來訓練機器人控制器(基于梯度)。

主要有三個關鍵組成部分:

模擬器環境代碼作為上下文啟動初始“種子”獎勵函數。

GPU上的大規模并行強化學習,可以快速評估大量候選獎勵。

獎勵反射reward reflection,得益于GPT-4評估和修改能力,一步步迭代。

首先,無需任何特定提示工程和獎勵模版。使用原始Isaac Gym (一種GPU加速的物理模擬器)環境代碼作為上下文,生成初始獎勵函數。

這種無梯度的情境學習方式,可以根據各種形式的人類輸入,生成性能更強、符合開發人員愿景的獎勵函數。

其次,Eureka在每個進化步驟中都會生成很多候選函數,然后利用強化學習訓練來進行快速評估。

以往這種過程需要幾天甚至幾周來完成,但由Isaac Gym可將模擬時間提高1000倍,強化學習內循環能在幾分鐘完成。

最后,依賴于獎勵反射,Eureka還支持一種新形式的上下文 RLHF。它能夠將人類操作員的反饋融入自然語言中,以引導和調整獎勵功能。

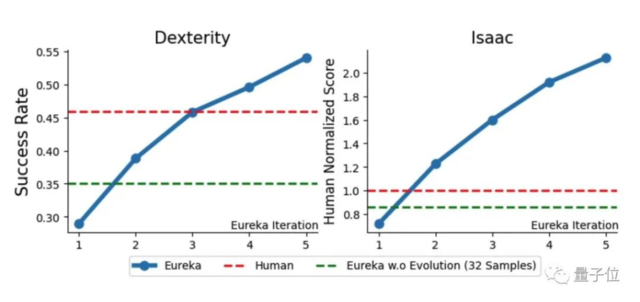

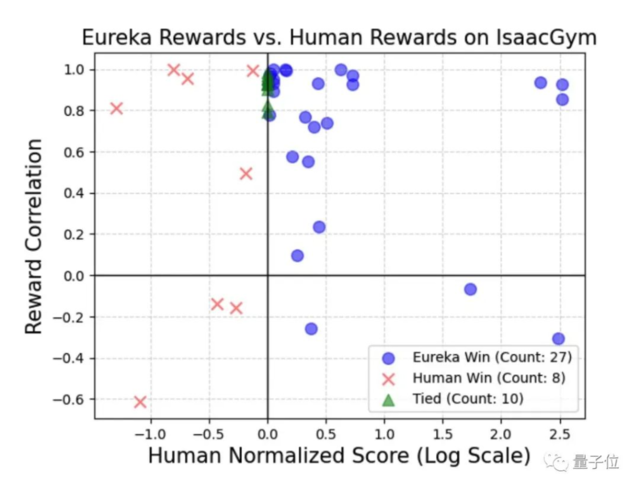

最終,在29種不同的開源RL環境中,83%基準測試中Eureka都優于人類,并實現了52%改進。

這些環境包括10種不同的機器人形態,比如四足機器人、四旋翼機器人、雙足機器人、機械手等。

讓研究人員驚訝的是,尤其在處理復雜、高維電機控制的任務上,Eureka表現更好,且與人類獎勵的相關性越低。

甚至在少數情況下,AI的策略與人類的策略呈現負相關。

這就有點像當年 AlphaGo的下棋策略,人類看不懂學不會,但十分有效。

英偉達出品

這項研究由英偉達、賓夕法尼亞大學、加州理工學院、德州大學奧斯汀分校的研究人員來完成。

可以看到的是,近半數研究人員都是華人。

一作是Yecheng Jason Ma,目前是賓大GRASP 實驗室的四年級博士生,研究方向是強化學習和機器人學習。

英偉達科學家Jim Fan此次也是通訊作者之一。

咳咳,不過至于網友提到的彈鋼琴,Jim Fan自己曾分享過:只需幾個簡單按鈕,AI就能實時即興生成演奏音樂。

不知道,未來會不會這樣的呢?(不過,這研究已經是2018年的了)

本文作者:白交,來源:量子位,原文標題:《用GPT-4訓練機器人,英偉達最新Agent開源:任務越復雜越拿手》