新智元報道

編輯:Aeneas 好困

【新智元導讀】斯坦福學者發現,GPT-4對于Nature、ICLR的論文給出的審稿意見,竟然和人類審稿人有超過50%的相似性。看來讓大模型來幫我們審論文,并不是天方夜譚啊。

GPT-4,已經成功晉身審稿人!

最近,來自斯坦福大學等機構的研究者把數千篇來自Nature、ICLR等的頂會文章丟給了GPT-4,讓它生成評審意見、修改建議,然后和人類審稿人給出的意見相比較。

論文地址:https://arxiv.org/abs/2310.01783

結果,GPT-4不僅完美勝任了這項工作,甚至比人類做得還好!

在它給出的意見中,超50%和至少一名人類審稿人一致。

并且超過82.4%的作者表示,GPT-4給出的意見相當有幫助。

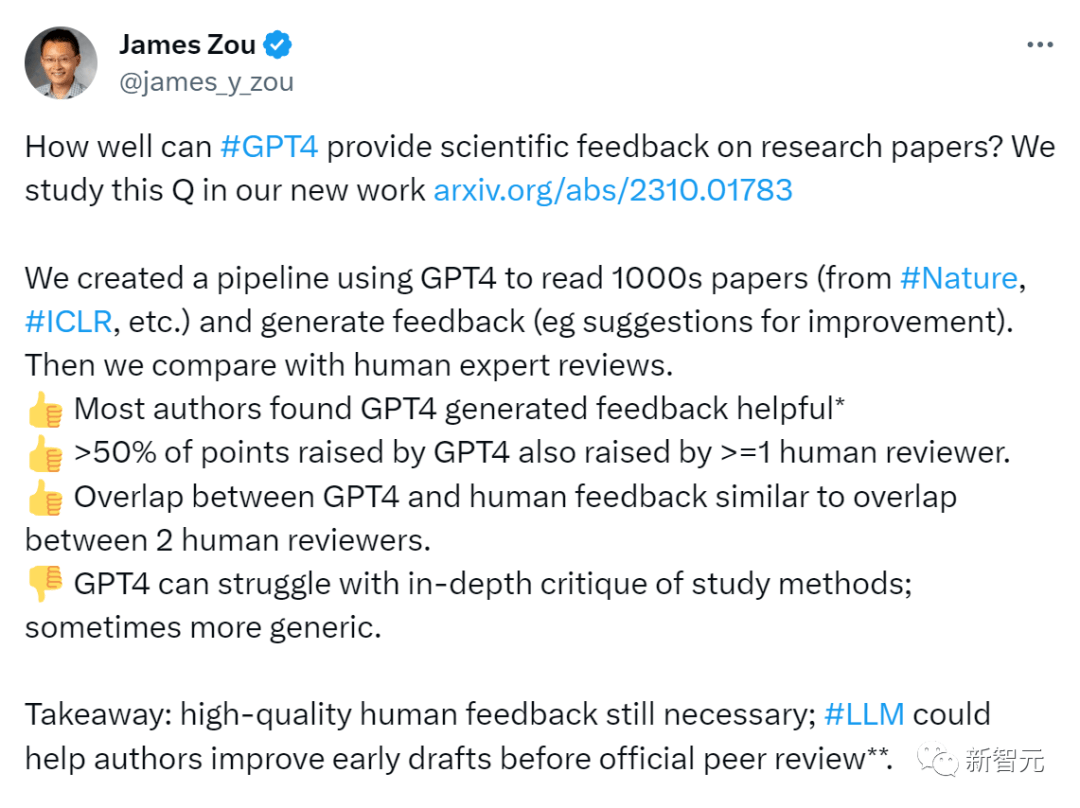

論文作者James Zou總結道:我們仍然需要高質量的人工反饋,但LLM可以幫助作者在正式的同行評審之前,改進自己的論文初稿。

GPT-4給你的意見,可能比人類都好

所以,怎樣讓LLM給你審稿呢?

非常簡單,只要從論文PDF中提取出文本,喂給GPT-4,它就立刻生成反饋了。

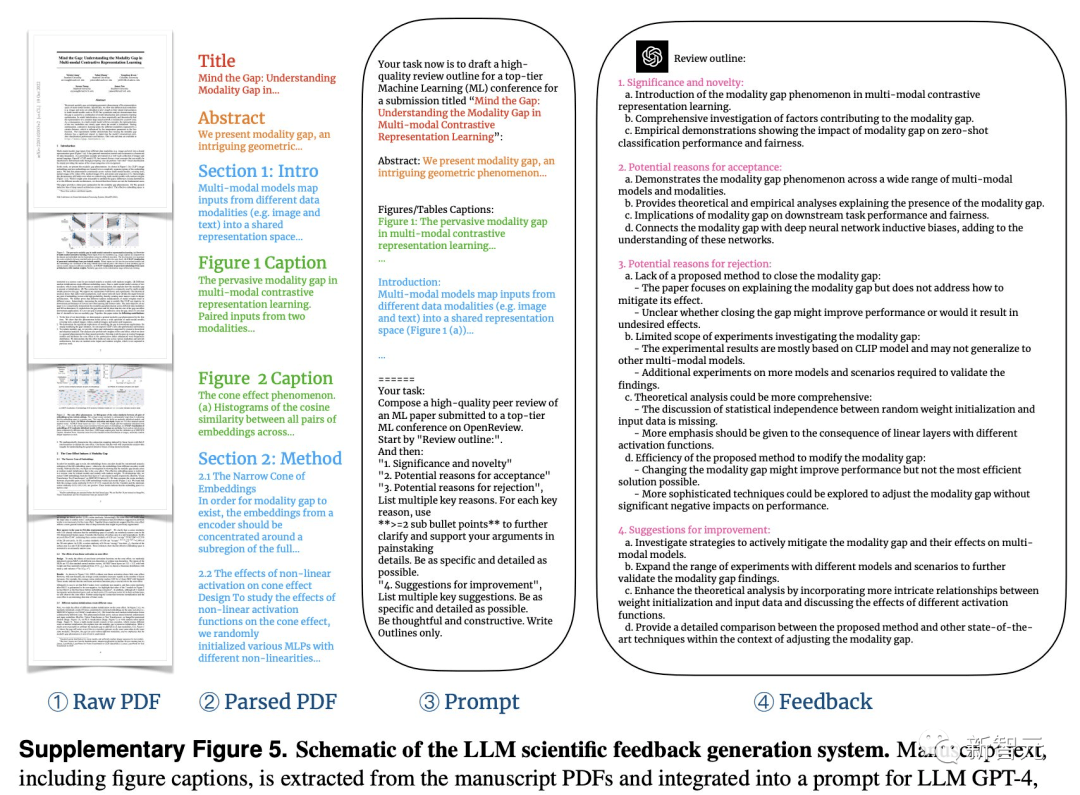

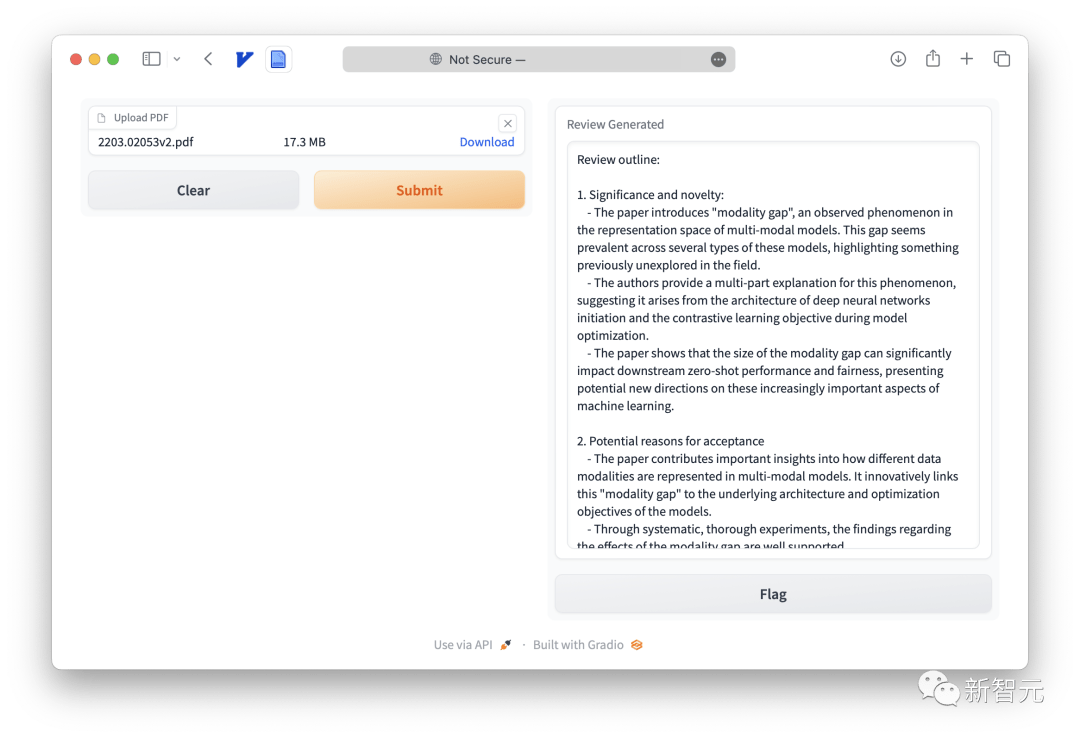

具體來說,我們要對一個PDF提取、解析論文的標題、摘要、圖形、表格標題、主要文本。

然后告訴GPT-4,你需要遵循業內頂尖的期刊會議的審稿反饋形式,包括四個部分——成果是否重要、是否新穎,論文被接受的理由,論文被拒的理由,改進建議。

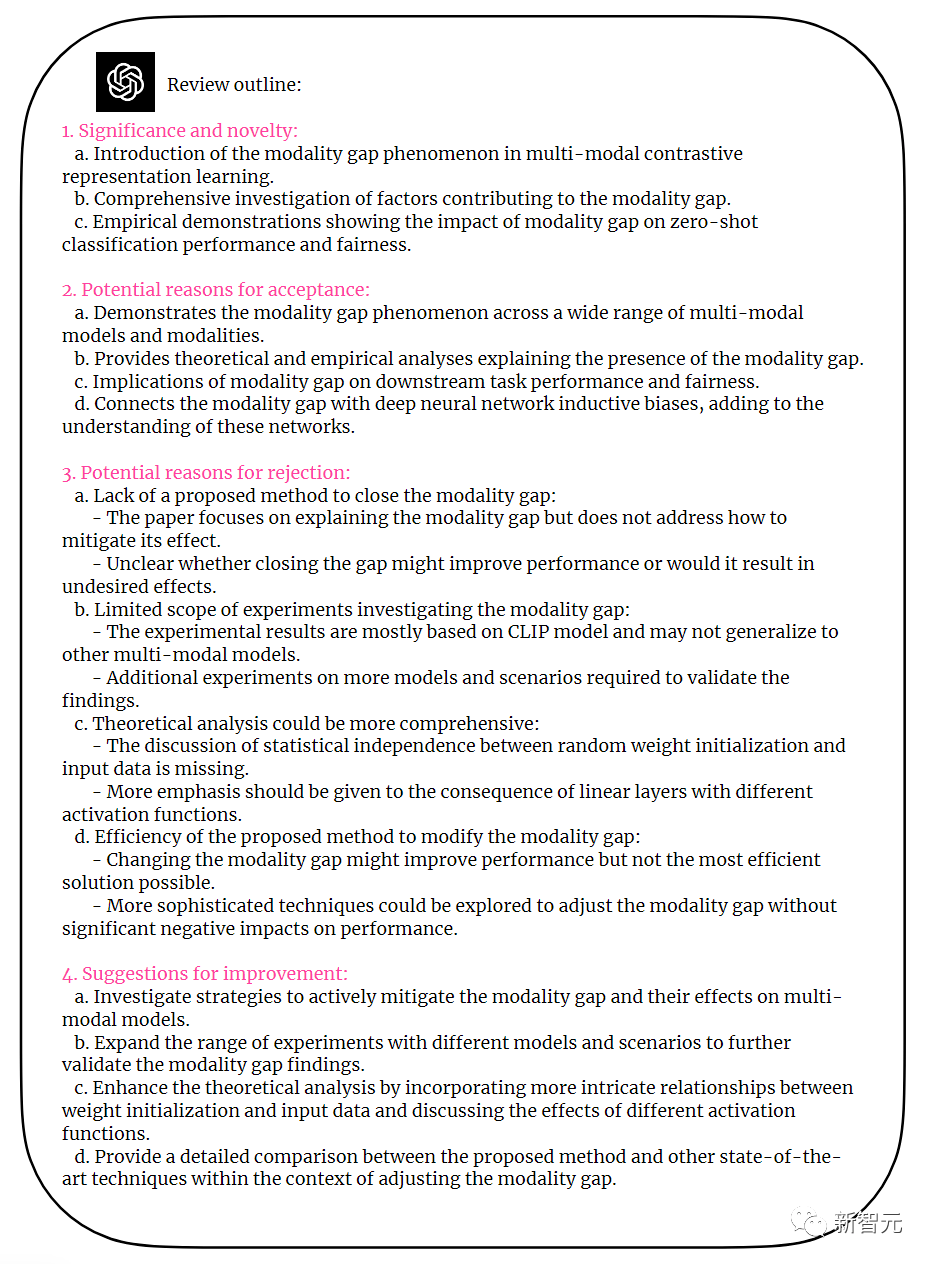

從下圖可以看到,GPT-4給出了非常有建設性的意見,反饋包括四部分。

這篇論文有什么缺陷?

GPT-4一針見血地指出:雖然論文提及了模態差距現象,但并沒有提出縮小差距的方法,也沒有證明這樣做的好處。

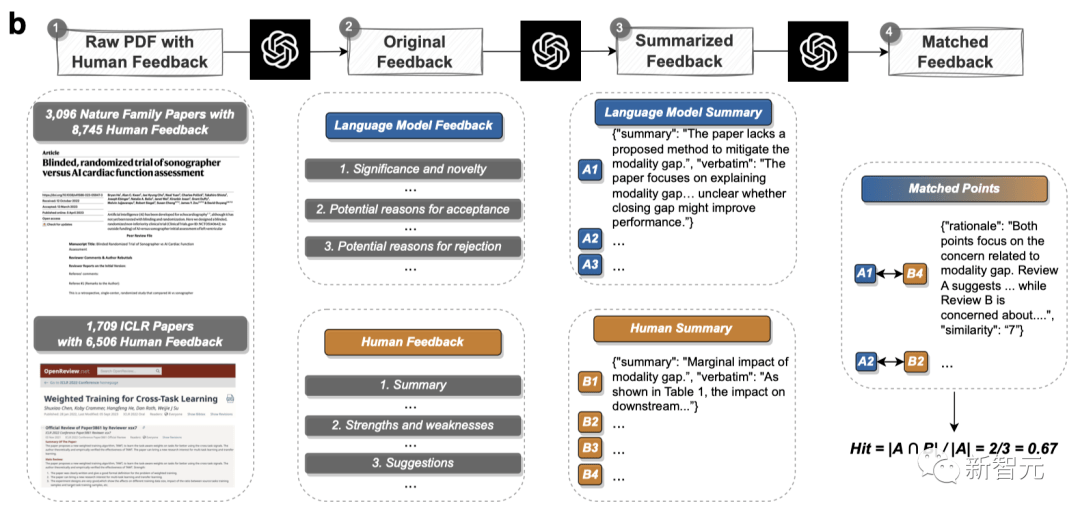

研究者對3,096篇Nature系列論文和1,709篇ICLR論文的人類反饋和LLM反饋進行了對比。

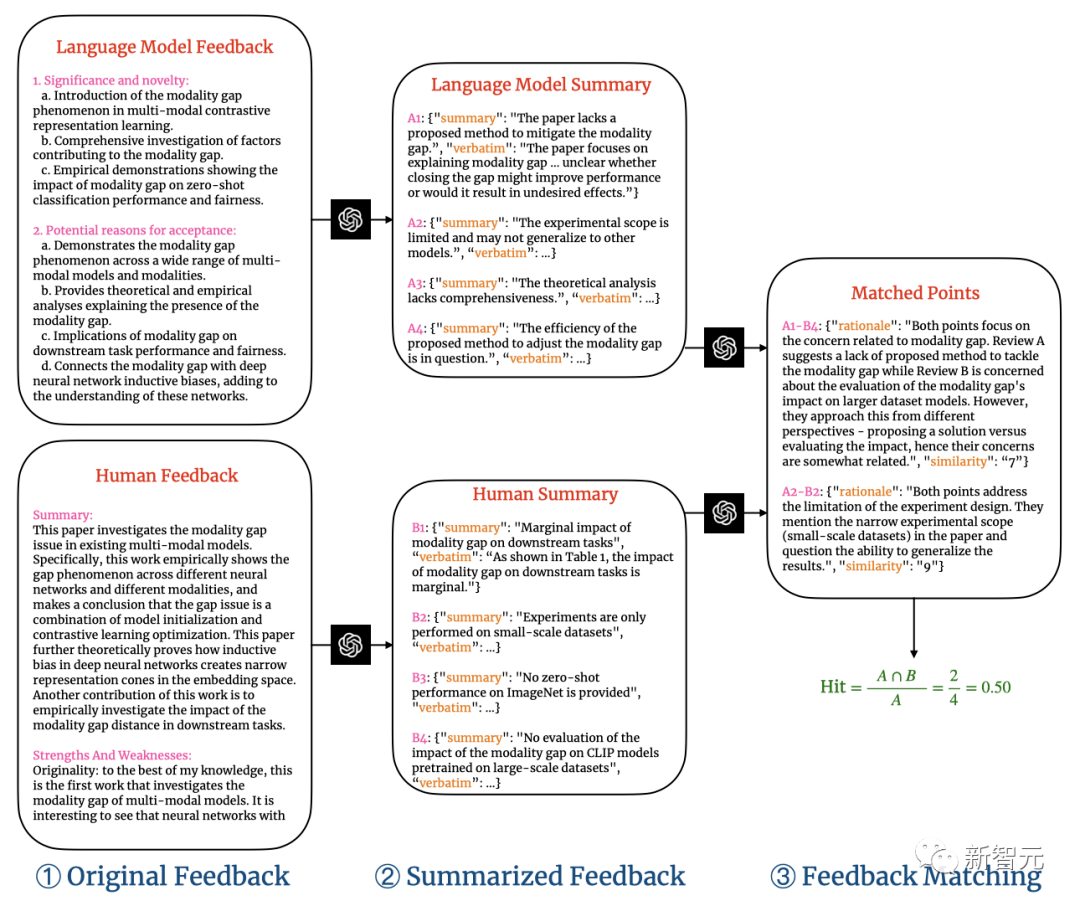

兩階段評論匹配管線會分別提取出LLM和人類反饋中的評論點,然后執行語義文本匹配,來匹配LLM和人類反饋之間的共同評論點。

下圖就是一個具體的兩階段評論匹配管線。

對于每條配對評論,相似度評級都會給出理由。

研究者將相似度閾值設為7,弱匹配的評論就會被過濾掉。

在Nature和ICLR兩個數據集中,論文和人類評論的平均token長度分別如下。

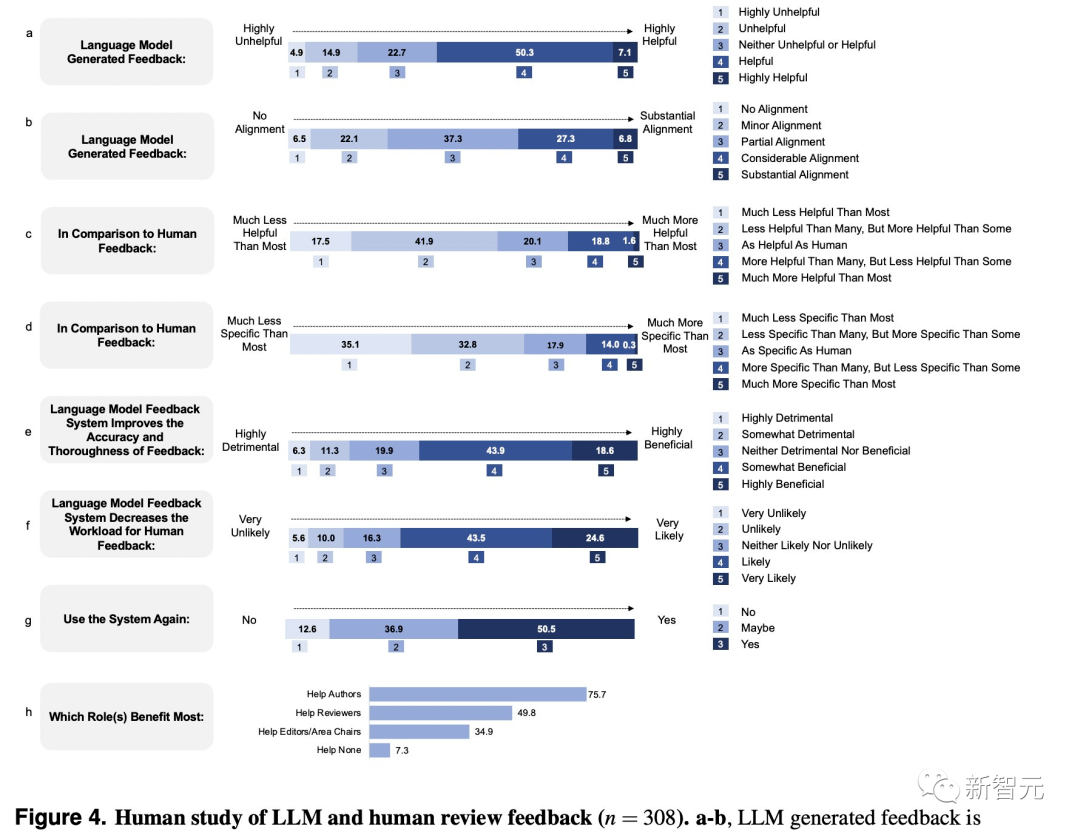

這項研究有美國110個AI機構和計算生物學機構的308名研究員參與。

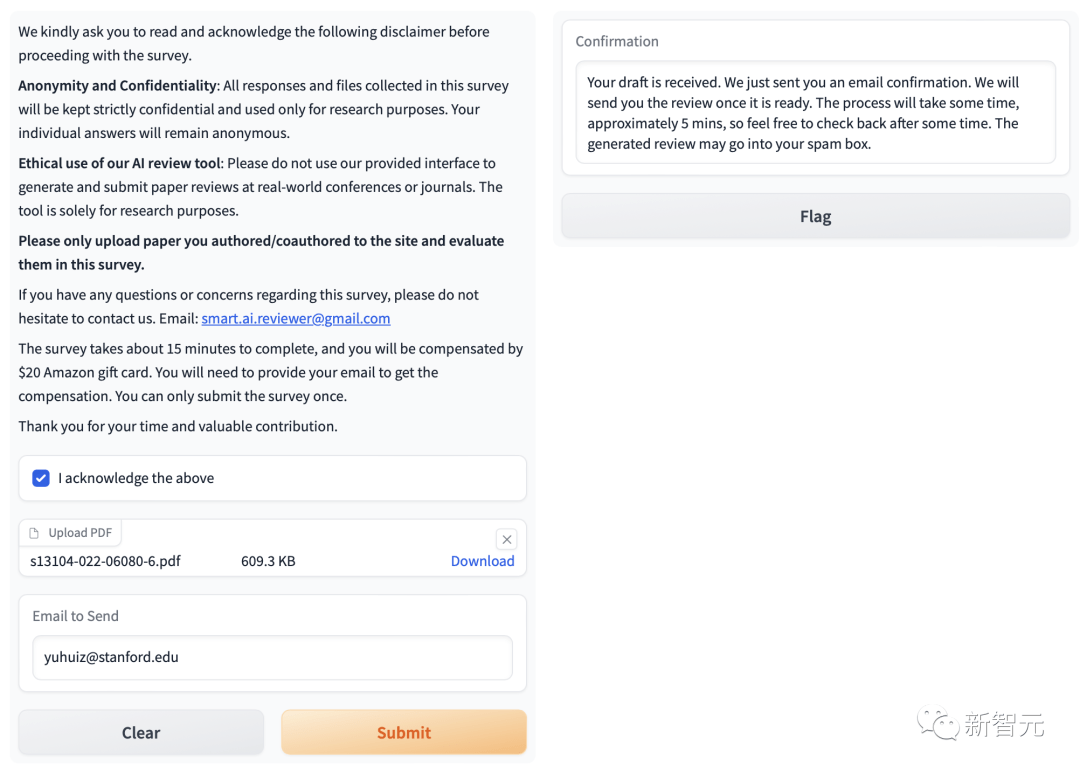

每位研究者都上傳了自己撰寫的論文,看了LLM的反饋,然后填寫了自己對于LLM反饋的評價和感受。

結果顯示,研究者普遍認為,跟人類評審的結果相比,LLM生成的反饋與之有很大的重疊,通常很有幫助。

如果說有什么缺點的話,就是在具體性上稍差一些。

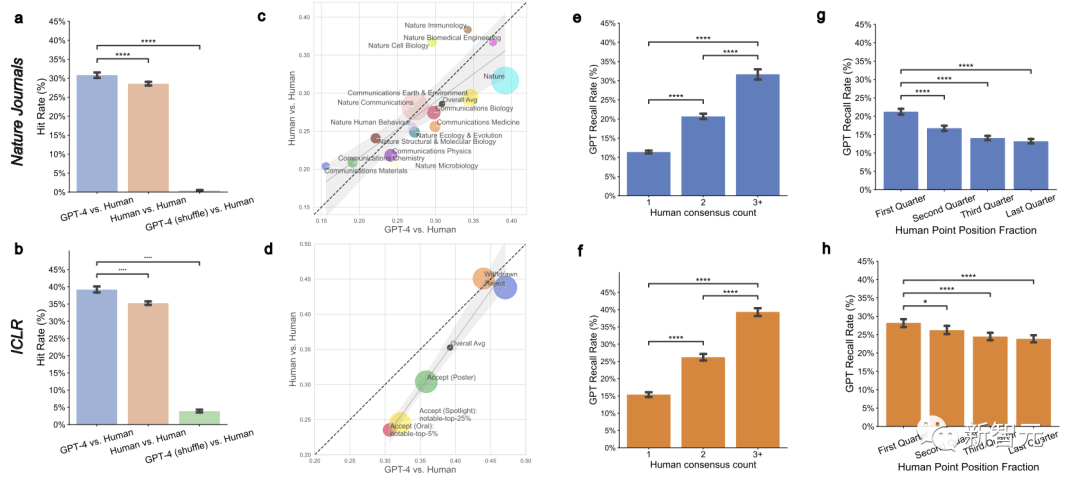

如下圖所示,對于提交給Nature的論文,大約三分之一(30.85%)的GPT-4意見與人類審稿人意見重合。

在ICLR論文中,超過三分之一(39.23%)的GPT-4意見與人類審稿人意見重合。

LLM與人類審稿人,偏重略有不同

以下是對同一篇ICLR論文的LLM評論和人類評論,可以看出,LLM的眼光很毒辣,評論很一針見血。

比如與先前研究的對比上,人類審稿員表示:

比較是有缺陷的。尤其是GNN方法的標簽一致性和中心一致性損失都沒有考慮到。更公平的比較應該是使用兩種損失都考慮到的GNN方法。

而GPT-4的評價是:

論文缺乏與現有方法的徹底的比較。雖然作者對于一些方法比較了基線,但還需要更全面的比較。

在理論可靠性上,人類審稿人給出了這樣的意見——

恕我直言,理論的證明太瑣碎了。最終結論是如果相似度合適,預測的動作就是準確的。由于模型正在學習正確的相似度,也就相當于說模型h如果經過良好的訓練,輸出就是正確的。這是顯然的事。

而GPT-4的意見是:

作者應該提供更多理論分析,來比較信息傳遞和一致性約束之間的聯系,這樣能讓讀者更易于理解。

在研究的可復現性上,人類審稿員希望論文能夠提供代碼,好讓其他讀者也能復現實驗。

GPT-4對此也給出了相同意見:「作者應該提供有關實驗設置的更多詳細信息,來確保研究的可復現性。」

參與調查的用戶普遍認為,LLM的反饋可以幫助提高評審的準確性,減少人類評審員的工作量。而且大多數用戶打算再次使用LLM反饋系統。

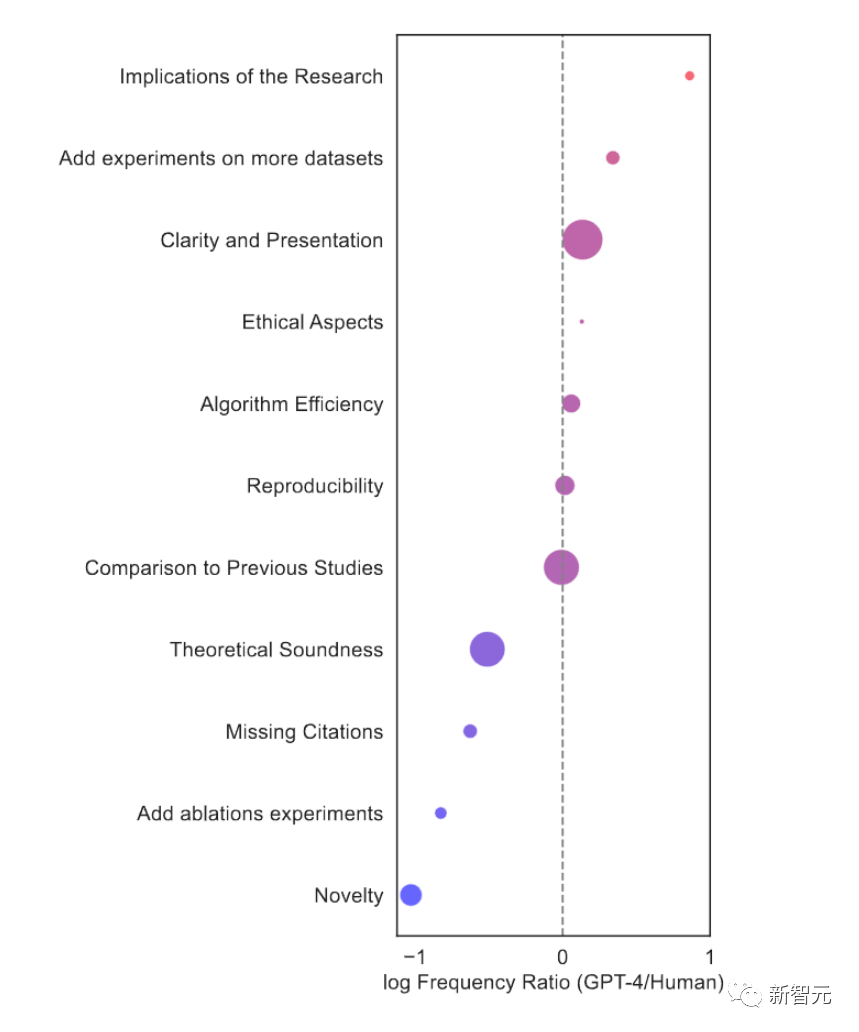

有趣的是,相比人類審稿人,LLM審稿員有自己獨有的特點。

比如,它提及影響因子的頻率,是人類審稿人的7.27倍。

人類審稿人會更可能要求補充額外的消融實驗ablation experiments,而LLM則會注重于要求在更多的數據集上進行實驗。

網友們紛紛表示:這項工作很了不起!

也有人說,其實我早就這么干了,我一直在用各種LLM幫我總結和改進論文。

有人問,所以GPT評審會不會為了迎合如今的同行評審標準,讓自己有偏見呢?

也有人提出,量化GPT和人類評審意見的重合,這個指標有用嗎?

要知道,在理想情況下,審稿人不應該有太多重合意見,選擇他們的原意是讓他們提供不同的觀點。

不過至少,這項研究讓我們知道,LLM確實可以用作改論文神器了。

三步,讓LLM給你審稿

1. 創建一個PDF解析服務器并在后臺運行:

conda env create-f conda_environment.yml conda activateScienceBeam Python/ target=_blank class=infotextkey>Python -m sciencebeam_parser.service.server --port=8080 # Make sure this is running in the background2. 創建并運行LLM反饋服務器:

condacreate -n llm python=3.10condaactivate llmpipinstall -r requirements.txtcatYOUR_OpenAI_API_KEY > key.txt # Replace YOUR_OPENAI_API_KEY with your OpenAI API key starting with "sk-"pythonmain.py3. 打開網頁瀏覽器并上傳你的論文:

打開http://0.0.0.0:7799并上傳論文,就可以在大約120秒內得到LLM生成的反饋。

作者介紹

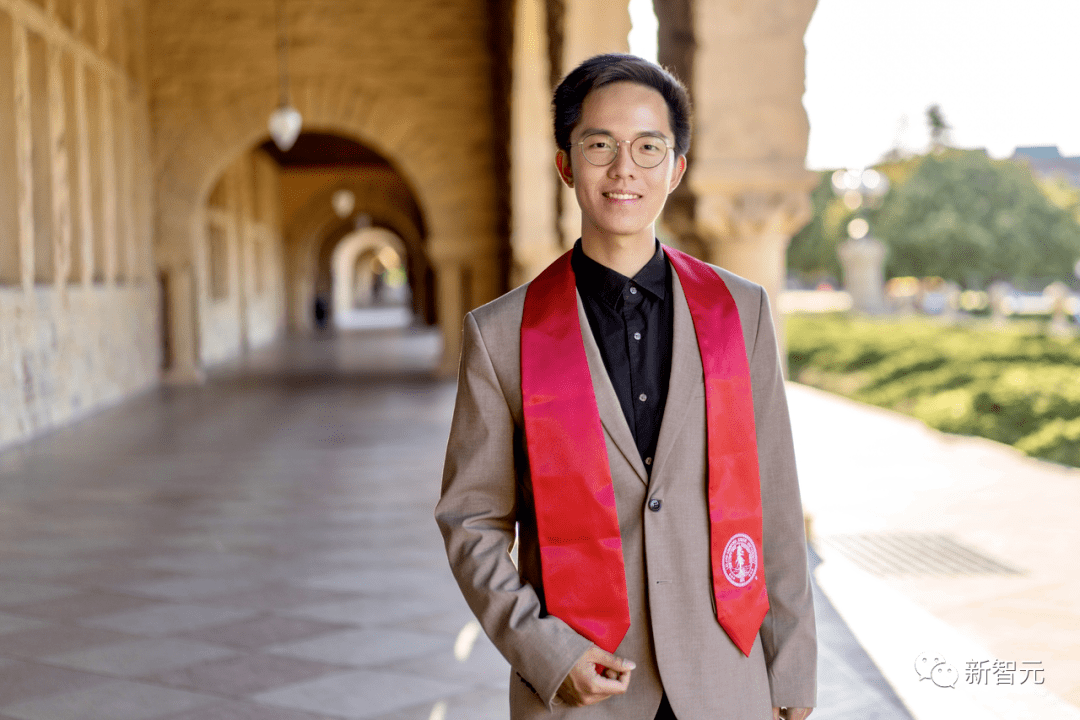

Weixin Liang(梁偉欣)

Weixin Liang是斯坦福大學計算機科學系的博士生,以及斯坦福人工智能實驗室(SAIL)的成員,由James Zou教授的指導。

在此之前,他在斯坦福大學獲得電子工程碩士學位,師從James Zou教授和Zhou Yu教授;在浙江大學獲得計算機科學學士學位,師從Kai Bu教授和Mingli Song教授。

他曾在亞馬遜Alexa AI、蘋果和騰訊進行過實習,并曾與Daniel Jurafsky教授、Daniel A. McFarland教授和Serena Yeung教授合作過。

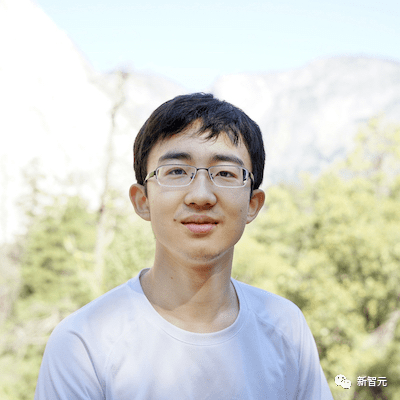

Yuhui Zhang

Yuhui Zhang是斯坦福大學計算機科學系的博士生,由Serena Yeung教授的指導。

他的研究方向是構建多模態人工智能系統和開發從多模態信息中獲益的創意應用。

在此之前,他在清華大學和斯坦福大學完成了本科和碩士學業,并與James Zou教授、Chris Manning教授、Jure Leskovec教授等出色的研究人員合作過。

Hancheng Cao(曹瀚成)

Hancheng Cao是斯坦福大學計算機科學系六年級的博士生(輔修管理科學與工程專業),同時也是斯坦福大學NLP小組和人機交互小組的成員,由Dan McFarland教授和Michael Bernstein教授指導。

他于2018年以優異成績獲得清華大學電子工程系學士學位。

2015年起,他在清華大學擔任研究助理,導師為李勇教授和Vassilis Kostakos教授(墨爾本大學)。2016年秋,他在馬里蘭大學杰出大學教授Hanan Samet教授的指導下工作。2017年夏,他作為交換生和研究助理在麻省理工學院媒體實驗室人類動力學小組工作,由Alex 'Sandy' Pentland教授 Xiaowen Dong教授指導。

他的研究興趣涉及計算社會科學、社會計算和數據科學。

參考資料:

https://arxiv.org/abs/2310.01783