西風(fēng) 發(fā)自 凹非寺

量子位 | 公眾號 QbitAI

2023年大模型千帆競發(fā),除此外AI領(lǐng)域還有哪些新突破?

來來來,暢銷書《Python/ target=_blank class=infotextkey>Python機(jī)器學(xué)習(xí)》作者Sebastian Raschka的年末總結(jié)已經(jīng)準(zhǔn)備好了。

看完才知道:

RLHF今年雖然爆火,但實打?qū)嵱玫降哪P筒⒉欢啵F(xiàn)在還出現(xiàn)了替代方案,有望從開源界“出圈”;

大模型透明度越來越低,透明度最高的是Llama 2,但得分也僅有54;

開源模型下一步不一定是“更大”,混合專家模型(MoE)可能是個突破點。

……

除了大語言模型,Sebastian Raschka還根據(jù)CVPR 2023打包了計算機(jī)視覺進(jìn)展,最后還講到了AI當(dāng)前的一些局限性、以及對2024年的技術(shù)預(yù)測。

走過路過的網(wǎng)友們紛紛表示總結(jié)得很到位:

△機(jī)器翻譯,僅供參考

下面我們一起來看看這份年度總結(jié)里都有啥。

2023 AI爆點:大語言模型

今年,大模型領(lǐng)域似乎沒有出現(xiàn)實質(zhì)性的創(chuàng)新技術(shù),更多是基于去年的擴(kuò)展:

……

- ChatGPT(GPT-3.5)升級到GPT-4

- DALL-E 2升級到DALL-E 3

- Stable Diffusion 2.0升級到Stable Diffusion XL

但學(xué)界業(yè)界依舊忙得熱火朝天,一些新趨勢、新內(nèi)容總結(jié)如下——

重要AI模型論文信息量驟減

首先,是業(yè)界研究者在論文中公開的研究細(xì)節(jié)越來越少。

OpenAI此前在GPT-1、GPT-2、GPT-3、InstructGPT的論文中,還詳盡披露了模型架構(gòu)和訓(xùn)練過程;

但從GPT-4開始,OpenAI完全不提構(gòu)建過程。

唯一不知真假的GPT-4架構(gòu)信息,來源于坊間傳聞:

GPT-4是由16個子模塊構(gòu)成的混合專家(MoE)模型,每個子模塊擁有高達(dá)1110億參數(shù)……

Meta亦是如此,在第一篇Llama論文中詳細(xì)闡述了訓(xùn)練數(shù)據(jù)集,但Llama 2完全沒提相關(guān)內(nèi)容。

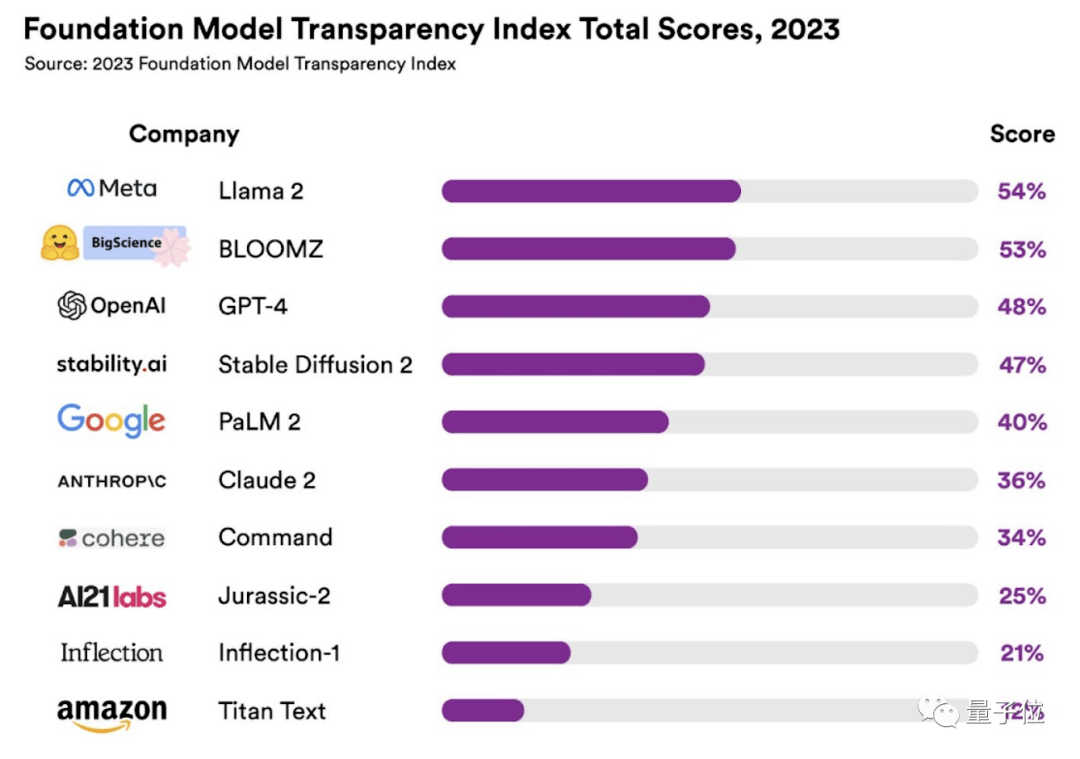

即便如此,Llama 2已經(jīng)是一眾大模型中最公開的了。斯坦福大學(xué)最近發(fā)布了一項關(guān)于大模型透明度指數(shù)的研究,Llama 2得分54,透明度排第一,GPT-4得分48,排第三。

雖然模型細(xì)節(jié)算是公司商業(yè)機(jī)密,但Sebastian Raschka認(rèn)為這種趨勢還是值得關(guān)注,因為它似乎會在2024持續(xù)。

大模型開卷上下文長度

今年大語言模型的另一個趨勢是擴(kuò)展輸入的上下文長度。

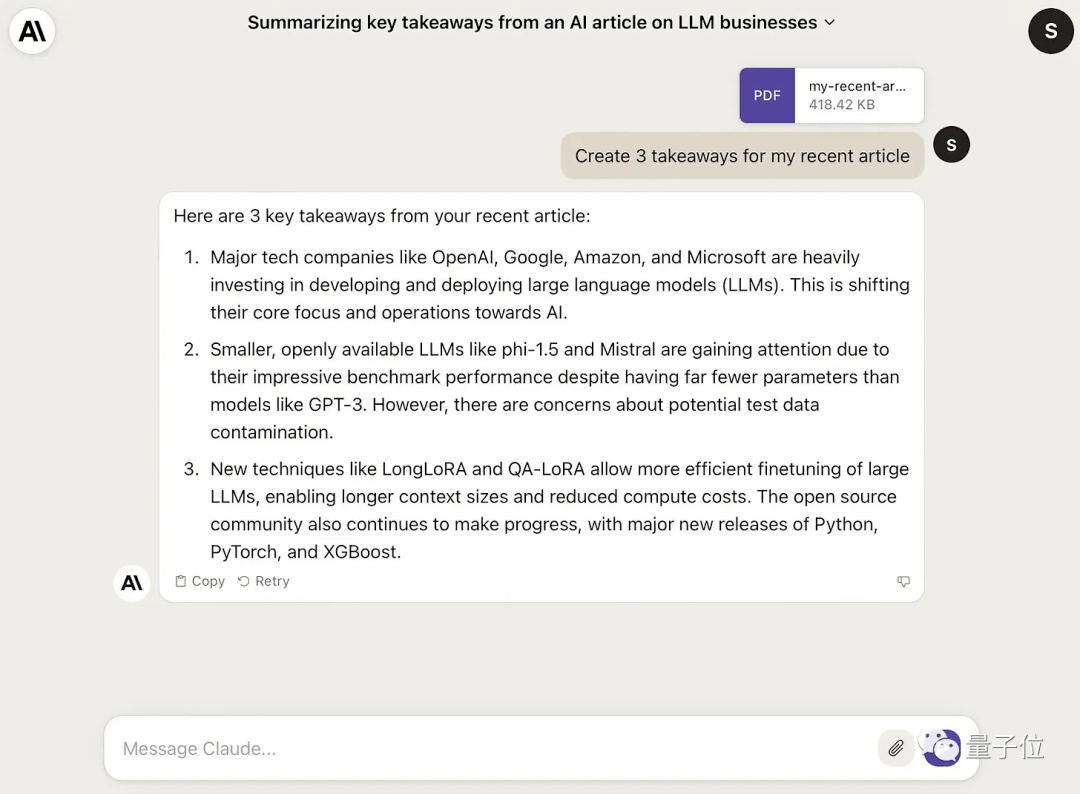

此前GPT-4上下文長度還是32k時,競品Claude 2就將上下文推進(jìn)到100k tokens,且支持PDF文件輸入。

隨后GPT-4大更新,新版本GPT-4 Turbo刷新上下文長度紀(jì)錄,已支持128k tokens。

一些編程工具,如Github Copilot,也在不斷增加上下文窗口長度。

開源大模型比拼“小而美”

用更小的模型比肩大模型的性能,是開源圈的“新玩法”。

目前,多數(shù)現(xiàn)有開源大模型仍然是純文本模型。

這些模型研究重點之一,是用小于100B參數(shù)的“小模型”對標(biāo)GPT-4的文本處理能力。

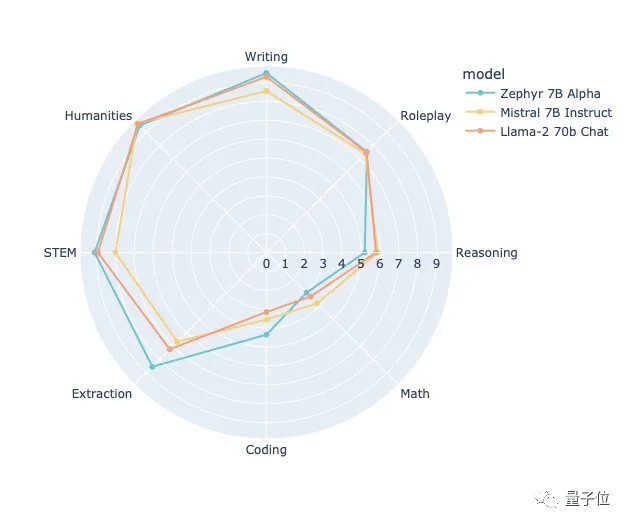

甚至出現(xiàn)了很多可以單GPU運(yùn)行的小模型,例如1.3B的phi1.5、7B的Mistral、7B的Zephyr。

Sebastian Raschka認(rèn)為,開源模型的下一個突破點不一定是“更大”,或許MoE也可能把開源模型提升到新的高度。

這么做可能是考慮硬件資源成本、數(shù)據(jù)量、開發(fā)時間等因素。

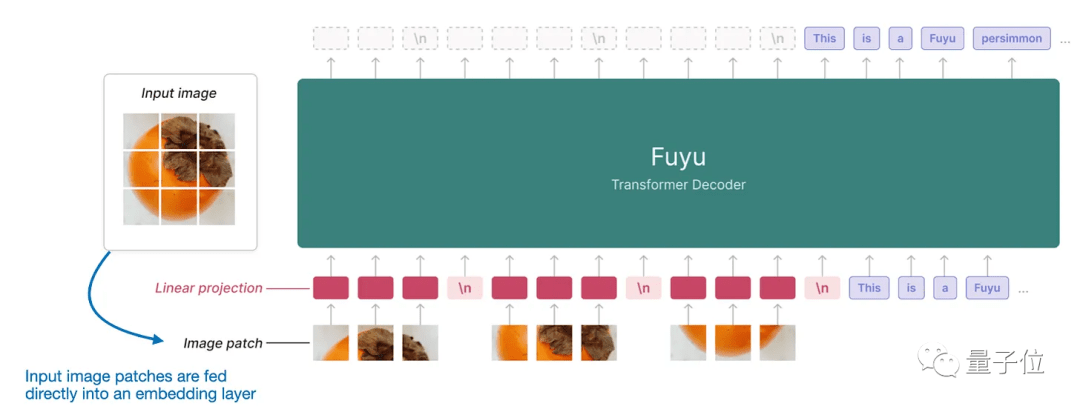

但也有值得關(guān)注的開源多模態(tài)大模型,例如10月17日剛發(fā)布的Fuyu-8B。

Fuyu-8B在處理圖像時,直接將圖像切成小塊,然后把這些小塊輸入到一個線性投影層,在這一層里面自動學(xué)習(xí)小塊的向量表示,避免用額外的預(yù)訓(xùn)練編碼器來提取圖像特征,簡化了模型架構(gòu)和訓(xùn)練過程。

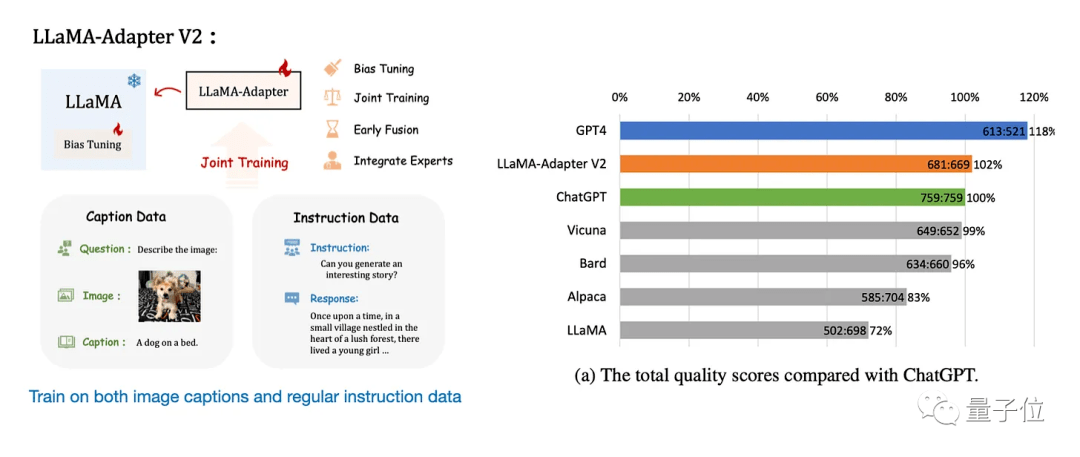

同時,Llama-Adapter v1、Llama-Adapter v2等微調(diào)方法的出現(xiàn),有望將現(xiàn)有的大模型擴(kuò)展到多模態(tài)領(lǐng)域。

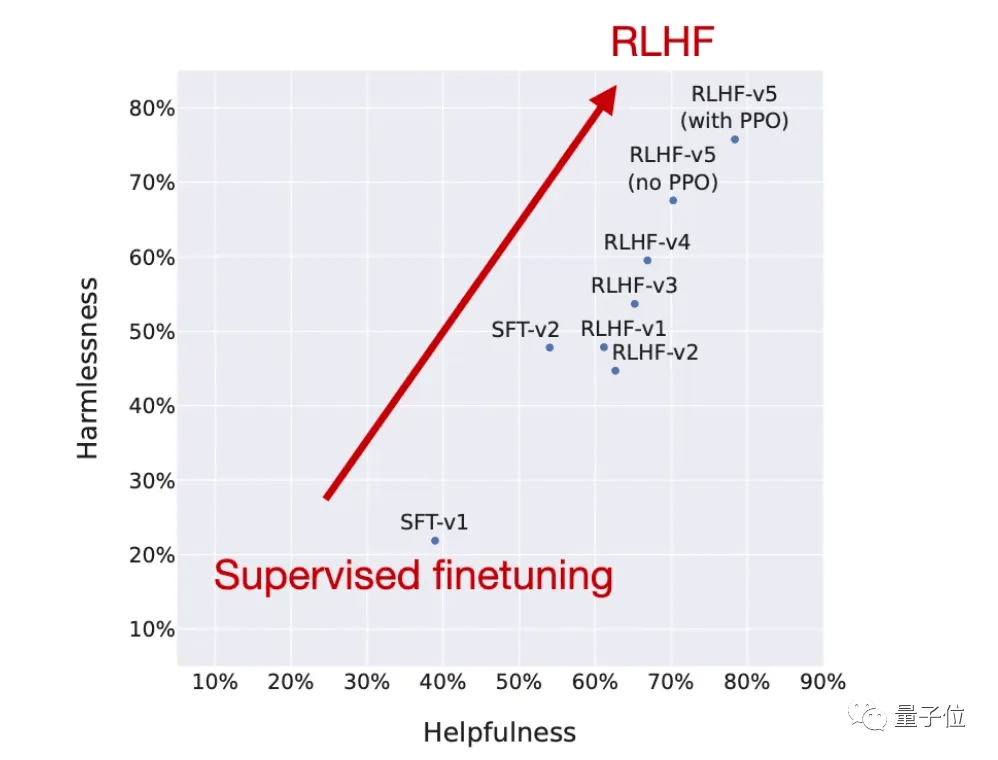

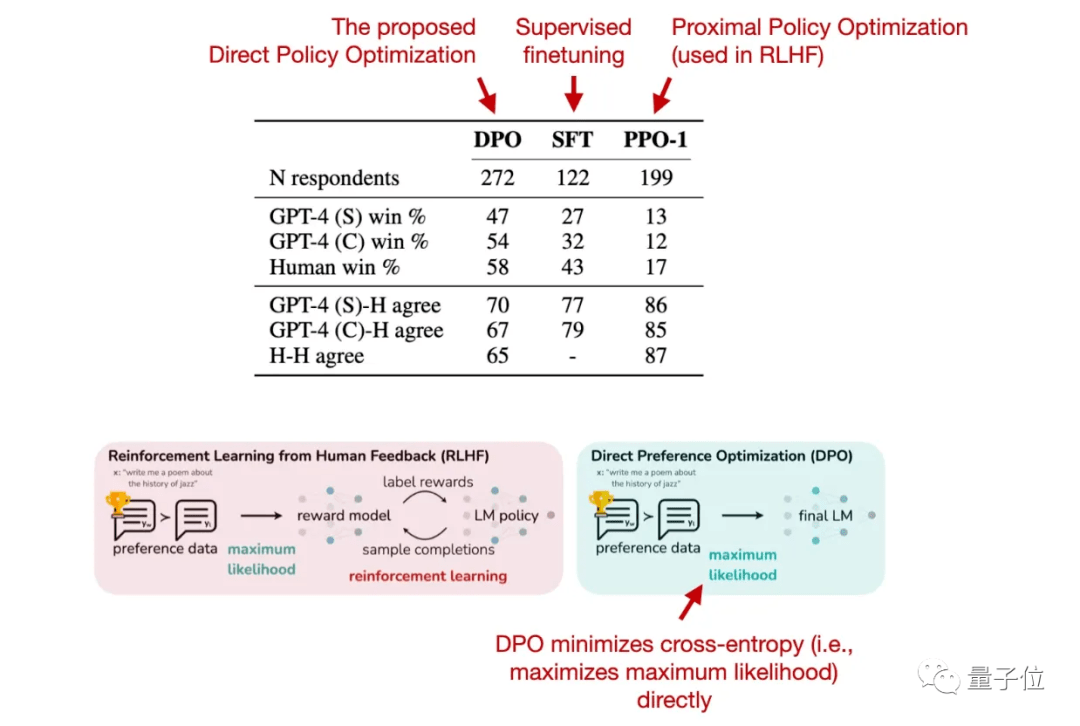

RLHF平替已出現(xiàn)

RLHF(人類反饋強(qiáng)化學(xué)習(xí))是大模型最受關(guān)注的技術(shù)之一,InstructGPT、ChatGPT、Llama 2中都用到了這種訓(xùn)練方法。

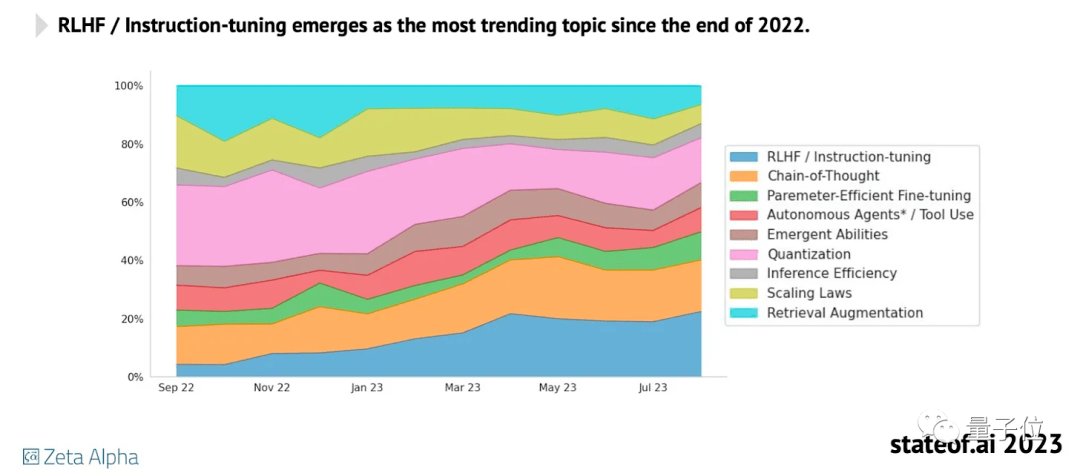

但分析公司stateof.ai發(fā)布的“2023AI現(xiàn)狀報告”中顯示,它還沒有被廣泛運(yùn)用,可能是因為實現(xiàn)起來比較復(fù)雜。目前大多開源項目仍然專注于指令微調(diào)。

不過,RLHF的最新替代方案已經(jīng)出現(xiàn):直接偏好優(yōu)化(DPO)。

這一方法由斯坦福大學(xué)研究團(tuán)隊提出。

DPO利用獎勵函數(shù)到最優(yōu)策略之間的映射關(guān)系,把強(qiáng)化學(xué)習(xí)問題轉(zhuǎn)變成僅需要訓(xùn)練策略網(wǎng)絡(luò)來擬合參考數(shù)據(jù)的問題。

也就是繞過了建模獎勵函數(shù),直接在偏好數(shù)據(jù)上優(yōu)化語言模型。

用上DPO后,模型輸出的質(zhì)量也優(yōu)于RLHF/PPO。

最近首個用DPO方法訓(xùn)練的開源大模型已出現(xiàn),來自HuggingFace H4團(tuán)隊打造的Zephyr-7B,它在一些任務(wù)上已超過用RLHF訓(xùn)練的Llama 2-70B:

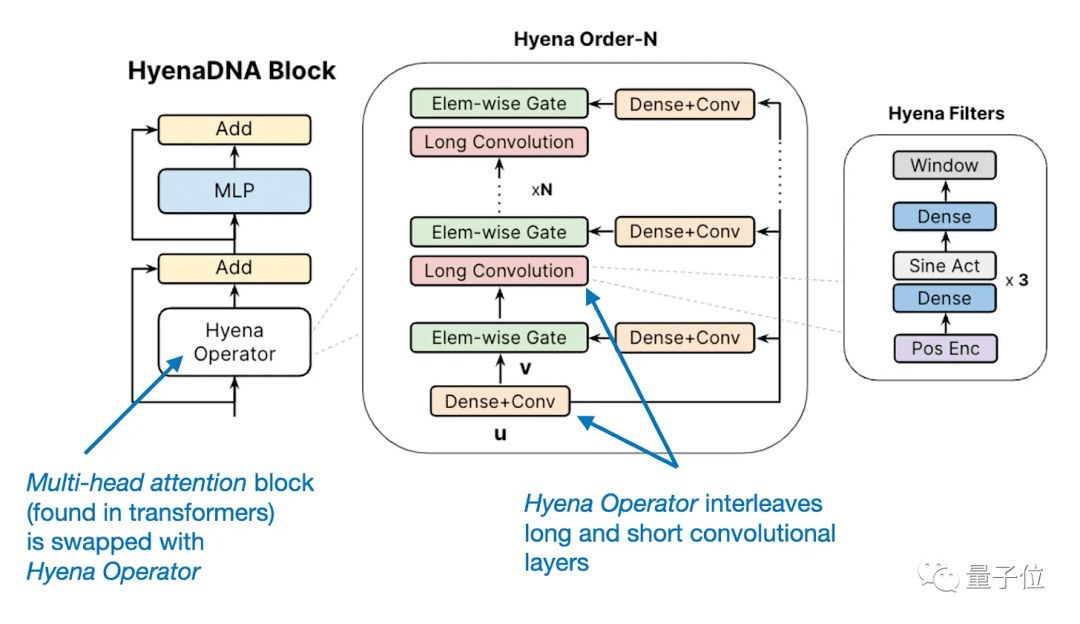

Transformer潛在新對手

今年還出現(xiàn)了一些Transformer的替代方案,比如循環(huán)RWKV、卷積Hyena。

這些新的框架主要是用來提高模型效率,當(dāng)然基于Transformer架構(gòu)的大語言模型仍是主流。

大模型改變生產(chǎn)方式

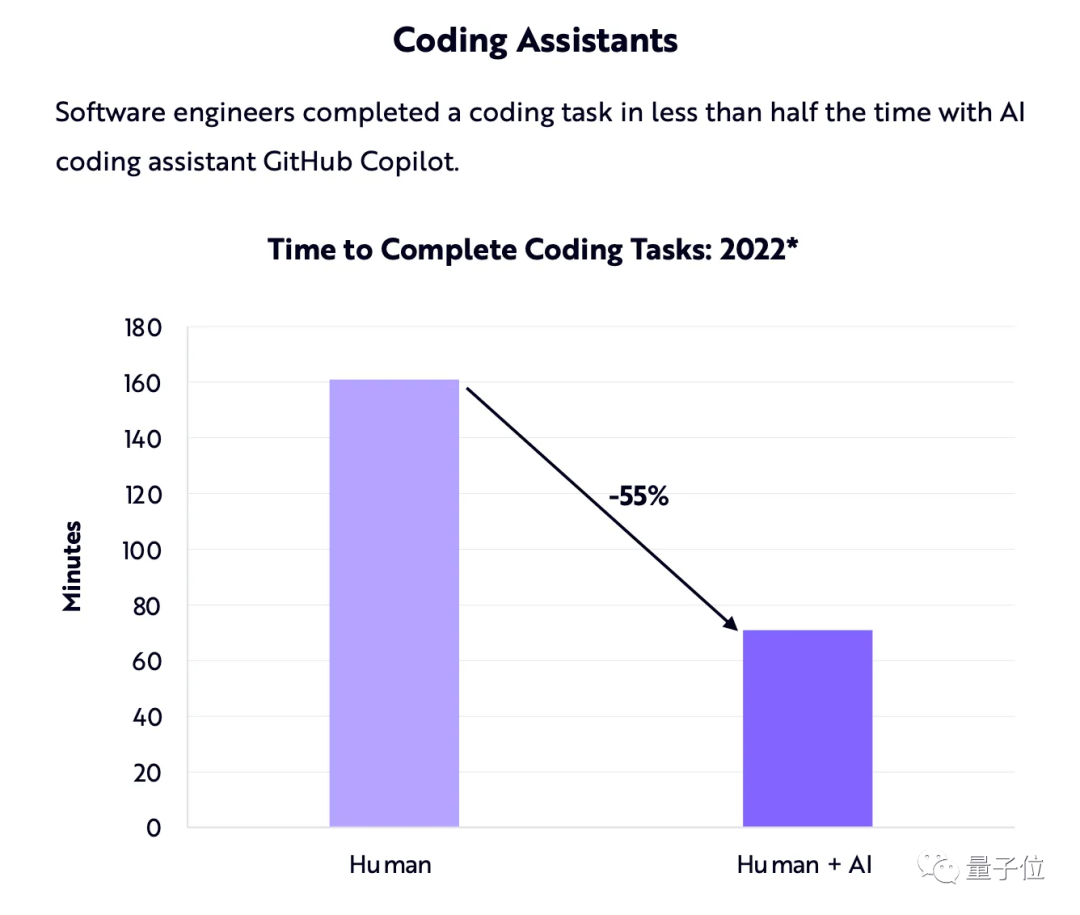

大模型除了用來處理文本,也逐漸被用到提升生產(chǎn)力(Microsoft全家桶)和寫代碼(GitHub Copilot)等場景中。

Ark-Invest曾發(fā)布報告預(yù)測,編程助手能讓編碼任務(wù)的完成時間縮短約55%。

可以肯定,編碼助手將繼續(xù)存在,而且只會變得更好。

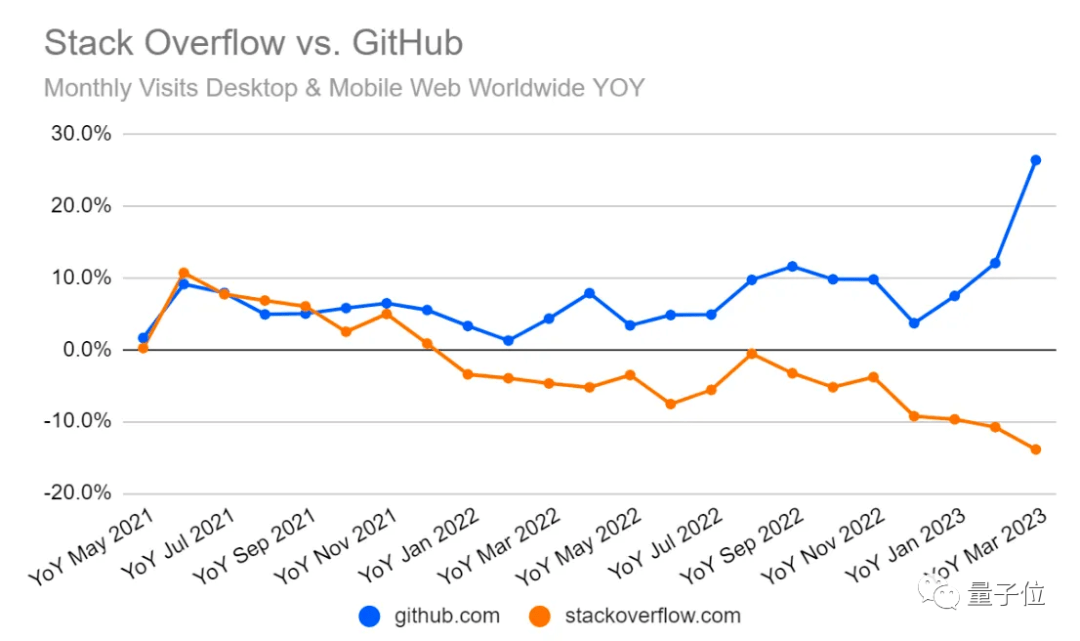

這對Stack Overflow(全球知名開發(fā)者問答網(wǎng)站)等平臺意味著什么?

同樣是“2023 AI現(xiàn)狀報告”中,一張StackOverflow與GitHub的網(wǎng)站流量對比圖,可以說明一些問題:

OK,以上就是大模型的一些新進(jìn)展。

不過對于AI的“另半邊天”計算機(jī)視覺而言,在2023年,這個領(lǐng)域也有許多不可忽視的新進(jìn)展。

計算機(jī)視覺怎么樣了?

今年大家都在重點關(guān)注大語言模型,但實際上,計算機(jī)視覺領(lǐng)域也取得了不少進(jìn)展,從計算機(jī)視覺頂會CVPR 2023中就可以窺見一斑。

今年CVPR 2023共接收了2359篇論文,大多數(shù)研究都集中于以下4個主題,Sebastian Raschka逐個進(jìn)行了介紹。

視覺Transformer突破限制

先來看看關(guān)注度最高的視覺Transformer。

效仿已取得巨大成功的語言Transformer架構(gòu),視覺Transformer(ViT)最初在2020年出現(xiàn)。

視覺Transformer原理與語言Transformer類似,是在多頭注意力塊中使用相同的自注意力機(jī)制。

不同的是,視覺Transformer不標(biāo)記單詞,而是標(biāo)記圖像,同樣能取得不錯的效果,但它一直有一個局限:相對資源密集且效率低于CNN,導(dǎo)致實際應(yīng)用受阻。

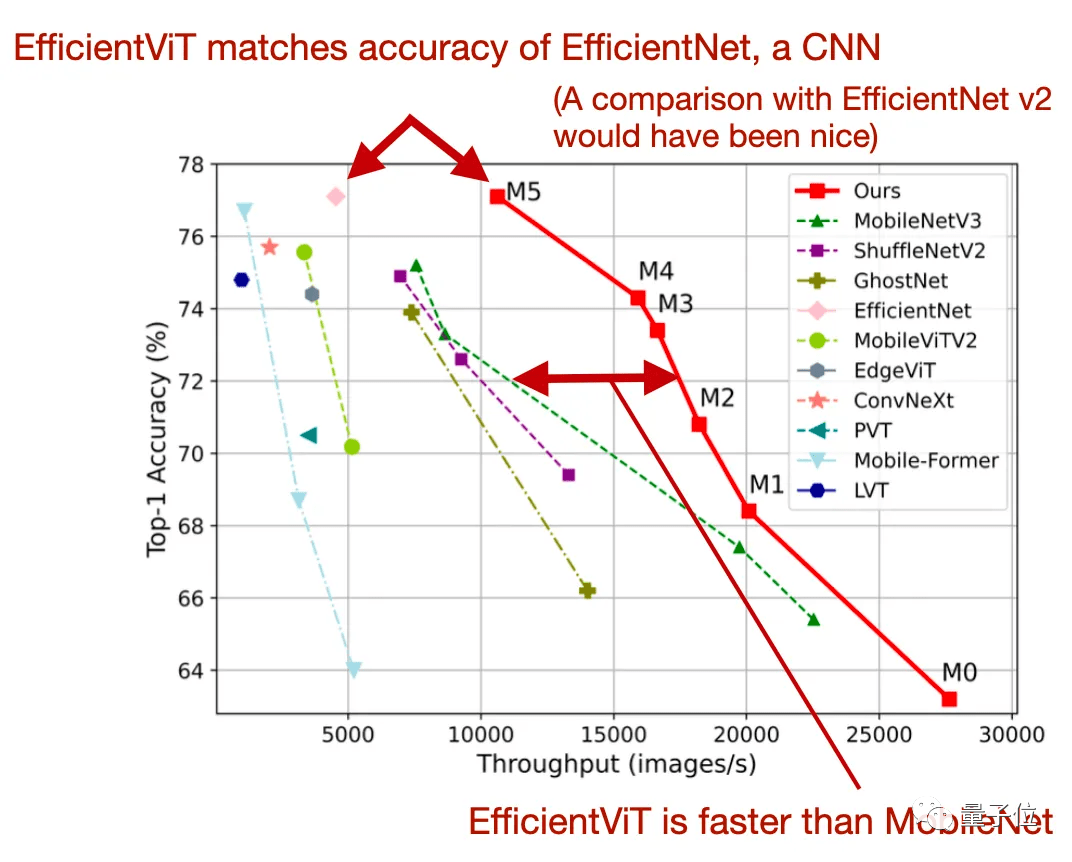

今年在CVPR論文“EfficientViT:Memory Efficient Vision Transformer with Cascaded Group Attention”中,研究人員介紹了一種新的高效架構(gòu)來解決這一限制——

相比原來的MobileViT,EfficientViT方法最多快了6倍。

主要創(chuàng)新點有兩個,一是全連接層之間的單個內(nèi)存綁定多頭自注意力模塊,二是級聯(lián)群注意力。

擴(kuò)散模型又有新玩法

Stable Diffusion讓擴(kuò)散模型爆火,這類模型所用的方法是:

模型訓(xùn)練時,逐漸往訓(xùn)練數(shù)據(jù)中摻入噪聲,直到變成純噪聲。然后再訓(xùn)練一個神經(jīng)網(wǎng)絡(luò),讓模型反向?qū)W習(xí)去噪,從噪聲中合成數(shù)據(jù)。

大多數(shù)擴(kuò)散模型使用CNN架構(gòu)并采用基于CNN的U.NET。

但今年“All are Worth words:A ViT Backbone for Diffusion Models”這項研究中,研究人員試圖將擴(kuò)散模型中的卷積U-Net骨干(backbone)與ViT交換,變成U-ViT。

研究人員評估了新架構(gòu),在條件圖像生成任務(wù)中,新的U-ViT擴(kuò)散模型可與最好的GAN相媲美,優(yōu)于其它擴(kuò)散模型;在文本到圖像生成方面,它優(yōu)于在同一數(shù)據(jù)集上訓(xùn)練的其它模型。

3D重建新方法擊敗NeRF

3D重建是計算機(jī)視覺的研究重點之一,在3D掃描、虛擬現(xiàn)實、增強(qiáng)現(xiàn)實、電影和視頻游戲中的3D建模和動作捕捉中都有運(yùn)用。

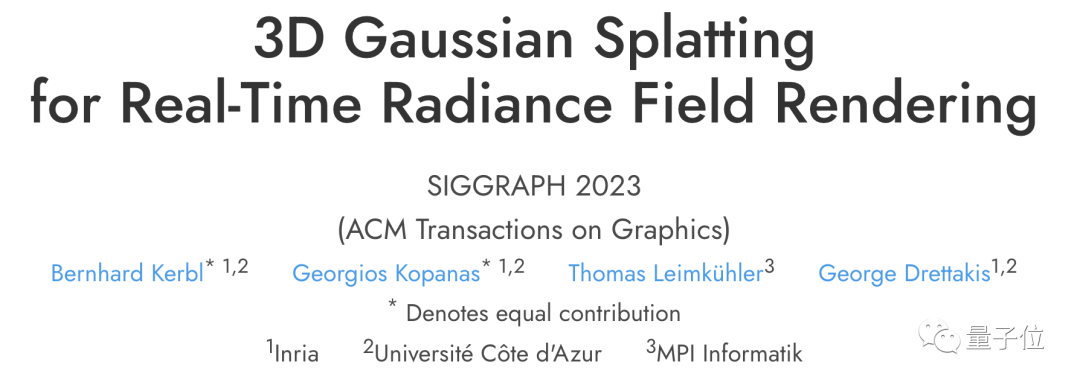

今年SIGGRAPH 2023最佳論文中,有一篇被稱為三維重建領(lǐng)域“爆炸性”新技術(shù)——Gaussian Splatting(高斯濺射)。

一舉突破NeRF與之前的渲染引擎難兼容、需要專門設(shè)計硬件、渲染開銷的老大難問題。

這種方法的核心是使用3D高斯作為場景表示,通過優(yōu)化各向異性協(xié)方差矩陣來表示復(fù)雜場景。

論文還提出了交錯的3D高斯參數(shù)優(yōu)化和自適應(yīng)密度控制方法,設(shè)計了快速、可微分的GPU柵格化方法,支持各向異性斑點,并實現(xiàn)快速反向傳播,可以達(dá)到高質(zhì)量的新視圖合成,而且實現(xiàn)了首個1080p分辨率下的實時渲染。

只用很少的訓(xùn)練時間,Gaussian Splatting可以達(dá)到InstantNGP的最高質(zhì)量,訓(xùn)練51分鐘,性能甚至比Mip-NeRF360要好。

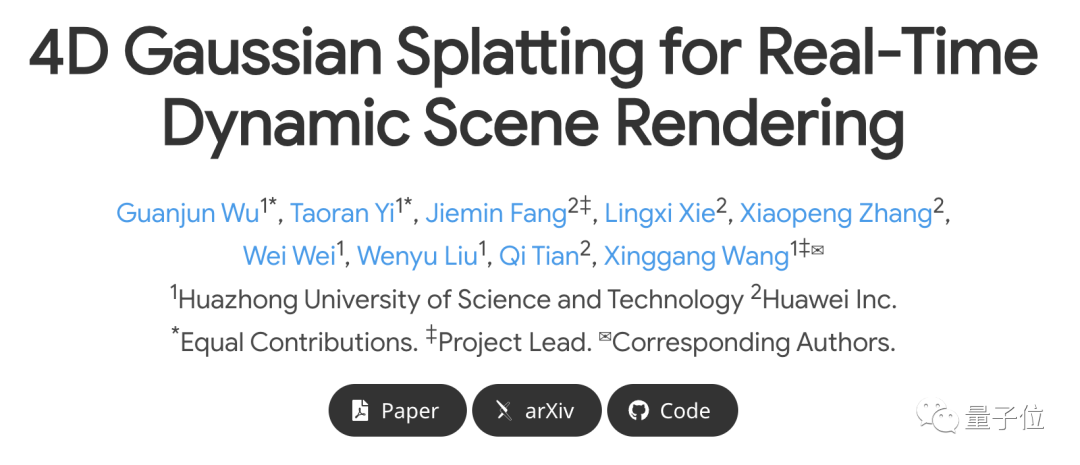

最近,華中科技大學(xué)&華為研究團(tuán)隊又繼續(xù)提出了4D Gaussian Splatting。

4D Gaussian Splatting實現(xiàn)了實時的動態(tài)場景渲染,同時可保持高效的訓(xùn)練和存儲效率。

在RTX 3090 GPU上,4D Gaussian Splatting以800×800分辨率達(dá)到70 FPS的性能,同時保持了與之前的最先進(jìn)方法相媲美甚至更高的質(zhì)量水平。

這項研究一出,網(wǎng)友沸騰直呼:

徹底改變?nèi)S重建。

當(dāng)然,Sebastian Raschka也分享了CVPR上一些NeRF(Neural Radiance Fields)方法的新進(jìn)展。

NeRF主要是通過訓(xùn)練神經(jīng)網(wǎng)絡(luò)來學(xué)習(xí)場景中每個點的顏色和密度,然后使用這些信息來生成逼真的3D場景渲染圖像。

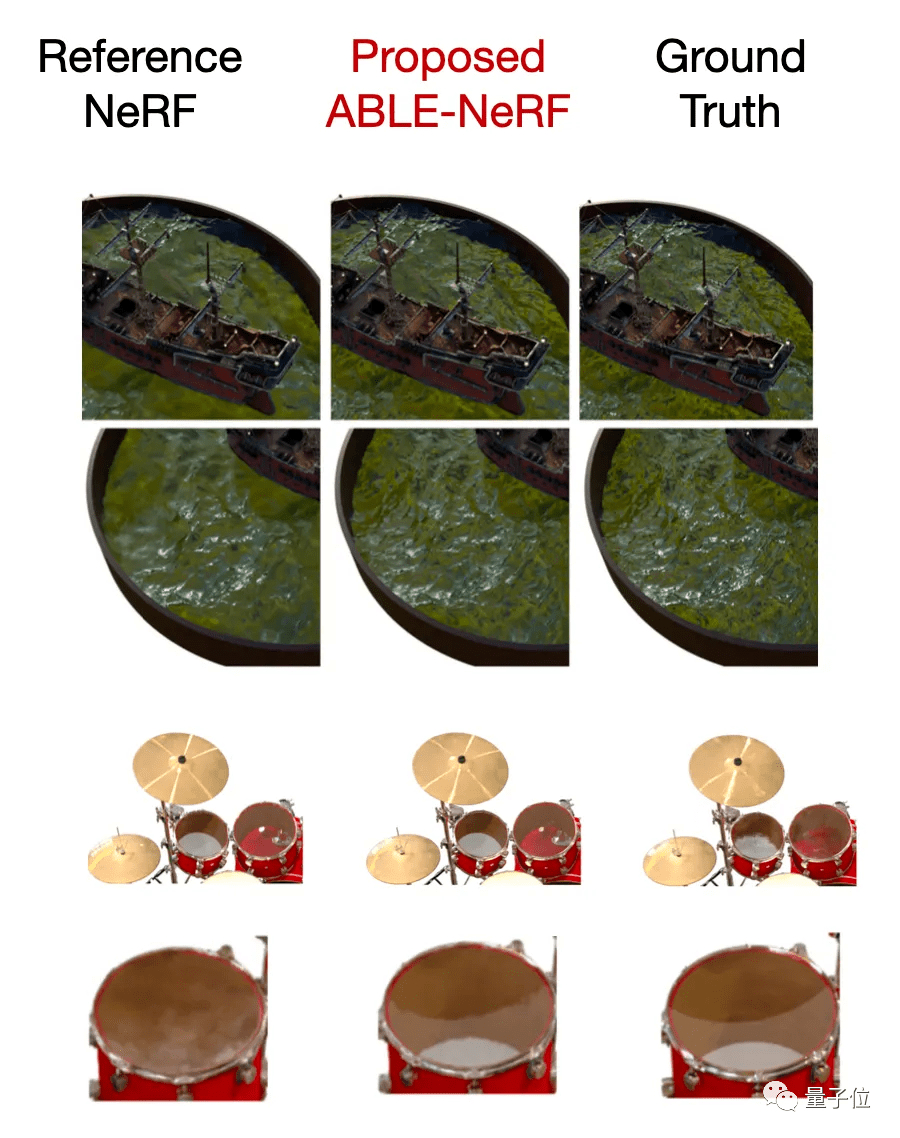

但NeRF有一個缺點是:有光澤的物體通常看不清,半透明物體的顏色也很模糊。

在“ABLE-NeRF:Attention-Based Rendering with Learnable Embeddings for Neural Radiance Field”這項研究中,研究人員通過引入基于自注意力的框架和可學(xué)習(xí)的嵌入解決這一問題,并提高了半透明和光澤表面的視覺質(zhì)量。

目標(biāo)檢測和分割

目標(biāo)檢測和分割是經(jīng)典的計算機(jī)視覺任務(wù)。

這兩個任務(wù)還是有區(qū)別的,目標(biāo)檢測是關(guān)于預(yù)測邊界框和相關(guān)標(biāo)簽,分割是對每個像素進(jìn)行分類,來區(qū)分前景和背景。

△目標(biāo)檢測(左)和分割(右)

此外還可以細(xì)分為語義分割、實例分割、全景分割三個類別。

一項名為“Mask DINO:Towards A Unified Transformer based Framework for Object Detection and Segmentation”的研究,擴(kuò)展了DINO方法。

Mask DINO性能優(yōu)于所有現(xiàn)有的物體檢測和分割系統(tǒng)。

DINO是一種帶有改進(jìn)去噪錨盒的DETR,而DETR是Facebook AI提出的一種端到端目標(biāo)檢測模型,它使用了Transformer架構(gòu),提供了一種更簡單靈活的目標(biāo)檢測方法。

AI局限&展望未來

雖然AI領(lǐng)域這一年來取得了諸多進(jìn)展,但依舊存在一些局限性,主要包括以下幾點:

1、大模型幻覺

大語言模型依然存在著生成有毒內(nèi)容和幻覺的問題。

今年出現(xiàn)了不少解決方案,包括RLHF和英偉達(dá)推出的NeMO Guardrails等,但這些方案要么難實施,要么處理得不到位。

目前為止,還沒有找到一個可靠的方法,既能解決這一問題又不損害大模型的正向性能。

2、版權(quán)爭議

與此同時,AI領(lǐng)域版權(quán)爭議日益嚴(yán)峻。

各大模型廠商沒少被起訴,之前開源數(shù)據(jù)集Books3也因侵權(quán)問題慘遭下架,Llama、GPT-J等都用它訓(xùn)練過。

總的來看,很多相關(guān)規(guī)定還在起草和修改過程中。

3、評估標(biāo)準(zhǔn)不統(tǒng)一

學(xué)術(shù)研究領(lǐng)域,基準(zhǔn)測試和排名榜單可能已經(jīng)失效是個問題。

用于測試的數(shù)據(jù)集可能已經(jīng)泄露,成為了大語言模型的訓(xùn)練數(shù)據(jù)。

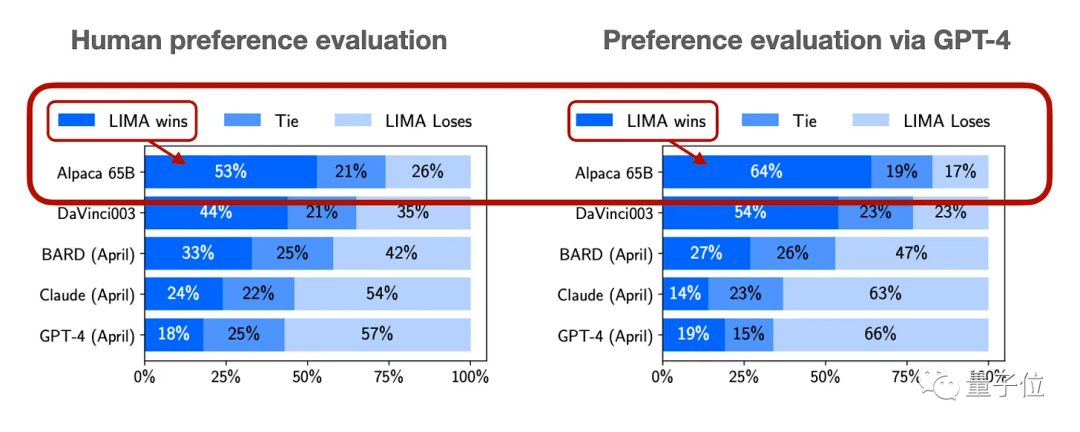

雖然通過詢問人類偏好來評估大模型的效果是一個普遍的方法,但這種方式較為復(fù)雜。

還有許多研究報告使用GPT-4來評估。

4、收益尚不明確

生成式AI還在探索階段,雖然無論是文本還是圖像生成工具,在特定場景下確實能給人們提供幫助。

但這些工具是否真的能給公司帶來收益,尤其是在高昂的運(yùn)行成本面前,業(yè)界還在激烈討論。

有報道稱,OpenAI去年的運(yùn)營虧損了5.4億美元。直到最近又有消息指出,OpenAI現(xiàn)在每月能賺取8000萬美元,有望彌補(bǔ)或甚至超出它的運(yùn)營開支。

5、虛假圖像泛濫

生成式AI帶來的另一個問題是假圖片和視頻在社交媒體泛濫。

這個問題由來已久,PS等工具也能,而AI技術(shù)簡易快捷,正在將此現(xiàn)象推向一個新的高度。

目前也有其它AI系統(tǒng)嘗試自動識別AI產(chǎn)生的內(nèi)容,但無論是文本、圖片還是視頻,這些系統(tǒng)的可靠性都不高。

6、數(shù)據(jù)集稀缺

涉及版權(quán)等爭議,不少公司(Twitter/X、Reddit等)關(guān)閉了免費(fèi)的API接入點,這樣做既是為了增加收益,也是為了阻止數(shù)據(jù)采集器搜集平臺數(shù)據(jù)用于AI訓(xùn)練。

之后一個好的方法可能是,建立一個眾包數(shù)據(jù)集的平臺,編寫、收集和整理那些已經(jīng)明確允許用于LLM訓(xùn)練的數(shù)據(jù)集。

展望2024,Sebastian Raschka認(rèn)為大語言模型會在計算機(jī)科學(xué)之外的STEM研究領(lǐng)域發(fā)揮更大影響。

另一方面,由于高性能GPU緊缺,各大公司紛紛開發(fā)定制的AI芯片,問題關(guān)鍵在于怎樣讓這些硬件全面、穩(wěn)定支持主流深度學(xué)習(xí)框架。

開源界,更多MoE(專家模型)也值得期待,共同創(chuàng)建數(shù)據(jù)集、DPO在開源模型中取代傳統(tǒng)監(jiān)督式微調(diào)也都是未來式。

Sebastian Raschka是誰?

Sebastian Raschka于2017年獲得密歇根州立大學(xué)博士學(xué)位,曾是威斯康星大學(xué)麥迪遜分校統(tǒng)計學(xué)助理教授。

2022年Sebastian Raschka離職,加入初創(chuàng)公司Lightning AI成為其首席AI教育官。

此外,他還是包括《Python機(jī)器學(xué)習(xí)》在內(nèi)的多本暢銷書的作者。

他經(jīng)常在自己的AI博客Ahead of AI中總結(jié)AI領(lǐng)域的各項研究,已攬獲大波粉絲。

參考鏈接:

[1]https://magazine.sebastianraschka.com/p/ai-and-open-source-in-2023

[2]https://magazine.sebastianraschka.com/p/ahead-of-ai-10-state-of-computer

[3]https://twitter.com/dotey/status/1721204481369498004

— 完—