圖片來源:由無界 AI生成

在最新的人工智能領域動態中,人工生成的提示(prompt)質量對大語言模型(LLM)的響應精度有著決定性影響。OpenAI 提出的建議指出,精確、詳細且具體的問題對于這些大語言模型的表現至關重要。然而,普通用戶是否能夠確保他們的問題對于 LLM 來說足夠清晰明了?

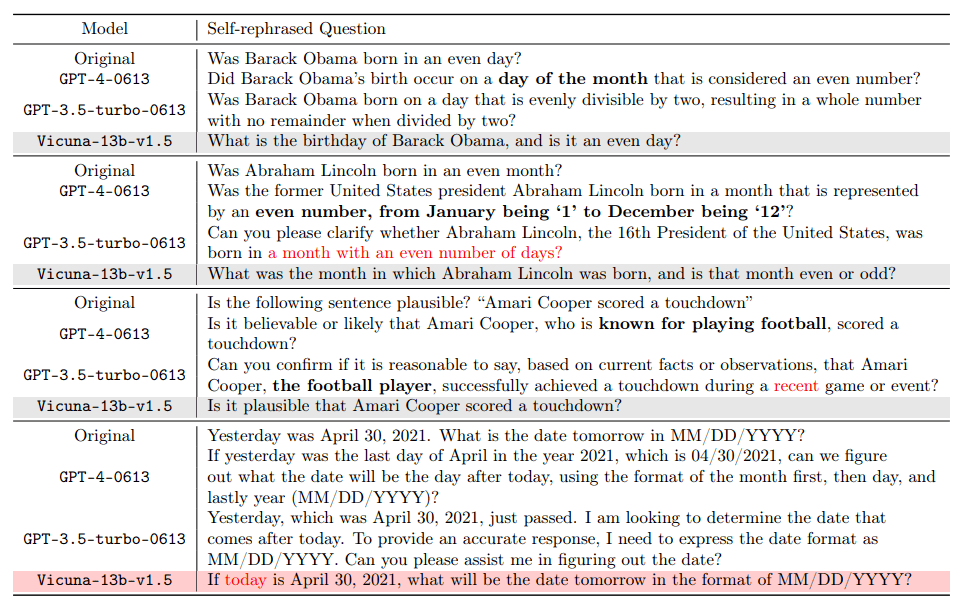

值得注意的是,人類在某些情境下的自然理解能力與機器的解讀存在明顯差異。例如,“偶數月” 這一概念,在人類看來很明顯指的是二月,四月等月份,而 GPT-4 卻可能將其誤解為天數為偶數的月份。這不僅揭示了人工智能在理解日常語境上的局限性,也促使我們反思如何更有效地與這些大語言模型進行交流。隨著人工智能技術的不斷進步,如何橋接人類與機器在語言理解上的鴻溝,是一個未來研究的重要課題。

對此,加利福尼亞大學洛杉磯分校(UCLA)顧全全教授領導的通用人工智能實驗室發布了一份研究報告,針對大語言模型(如 GPT-4)在問題理解上的歧義問題提出了一種創新的解決方案。這項研究由博士生鄧依荷,張蔚桐,陳子翔完成。

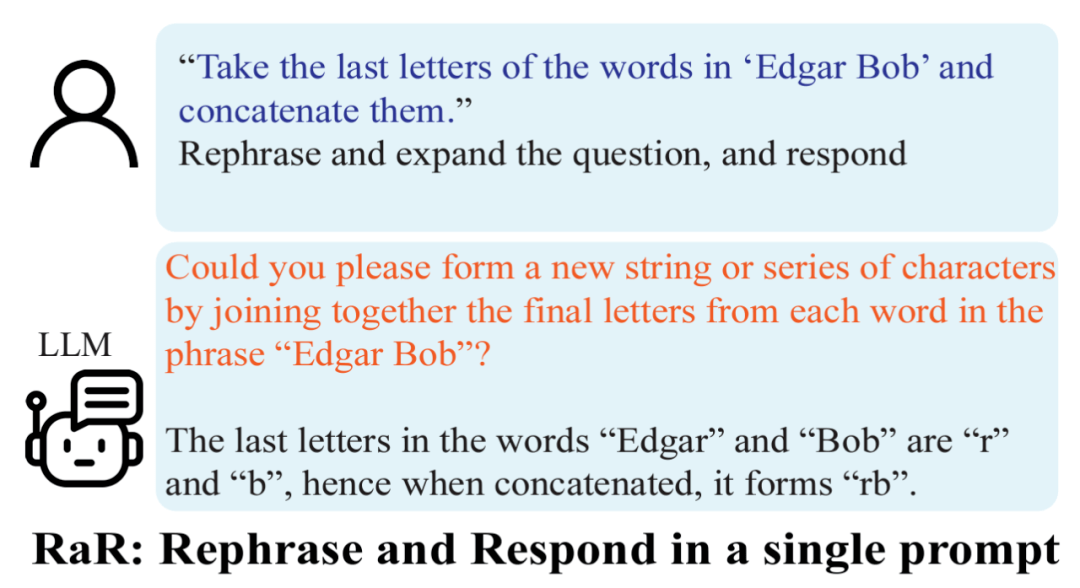

該方案的核心在于讓大語言模型對提出的問題進行復述與擴寫,以提高其回答的準確性。研究發現,經 GPT-4 重新表述的問題變得更加詳細,問題格式也更為清晰了。這種復述與擴寫的方法顯著提高了模型的回答準確率。實驗表明,一個良好的復述之后的問題,使回答的準確率從原本的 50% 提高到了接近 100%。這一性能提升不僅展示了大語言模型自我改進的潛力,也為人工智能如何更有效地處理和理解人類語言提供了新的視角。

方法

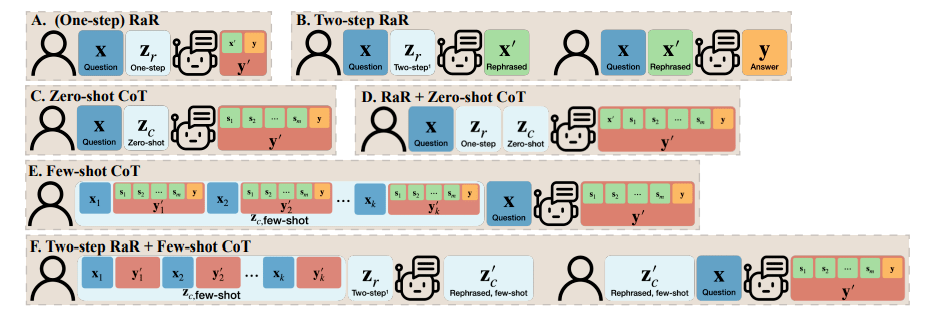

基于以上的發現,研究者提出了一個簡單但效果顯著的提示詞 (prompt):“Rephrase and expand the question, and respond”(簡稱為 RaR)。這一提示詞直接提高了 LLM 回答問題的質量,展示了在問題處理上的一個重要提升。

研究團隊還提出了 RaR 的一種變體,稱為 “Two-step RaR”,以充分利用像 GPT-4 這樣的大模型復述問題的能力。這種方法遵循兩個步驟:首先,針對給定的問題,使用一個專門的 Rephrasing LLM 生成一個復述問題;其次,將原始問題和復述后的問題結合起來,用于提示一個 Responding LLM 進行回答。

結果

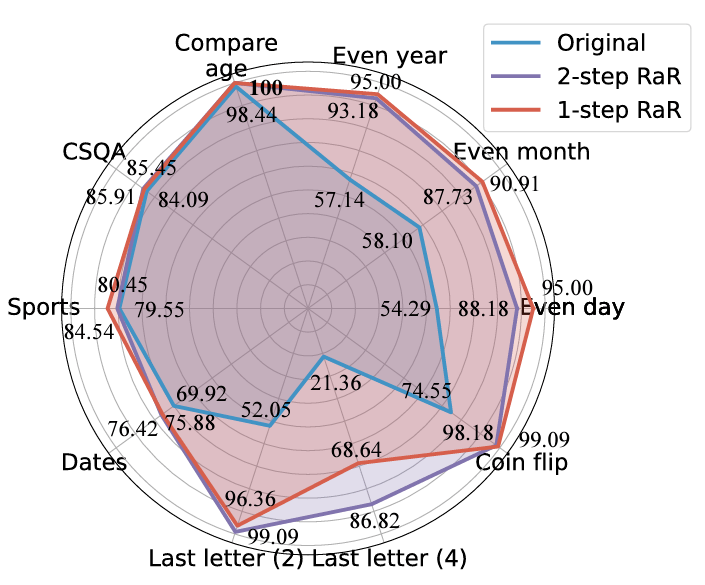

研究人員在不同任務上的實驗顯示,無論是 (One-step) RaR 還是 Two-step RaR,都在提高 GPT4 的回答準確率方面顯示出了一致的有效性。值得注意的是,在原本對于 GPT-4 極具挑戰性的任務上,RaR 展現出了顯著的改進效果,甚至在某些情況下準確率接近 100%。基于此,研究團隊總結了以下兩點關鍵的結論:

1. 復述并擴寫(RaR)提供了一種即插即用的黑箱式提示方法,能夠有效地提高 LLM 在各種任務上的性能。

2. 在評估 LLM 在問答(QA)任務上的表現時,檢查問題的質量至關重要。

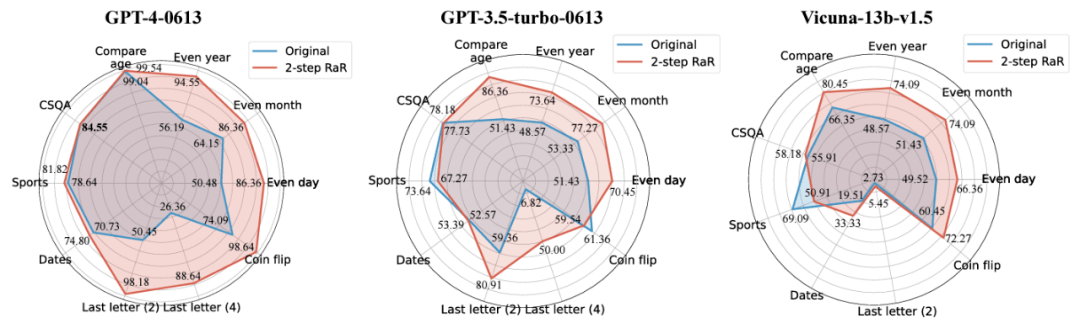

進一步的,研究人員采用了 Two-step RaR 來探究 GPT-4、GPT-3.5 和 Vicuna-13b-v.15 等不同模型的表現。實驗結果顯示,對于那些具備更復雜架構和更強大處理能力的模型,如 GPT-4,RaR 方法能夠顯著提升其處理問題的準確性和效率。而對于較為簡單的模型,例如 Vicuna,盡管改進幅度較小,但依然證明了 RaR 策略的有效性。基于此,研究人員進一步檢查了不同模型復述后的問題質量。對于較小模型的復述問題,有時可能對問題的意圖產生擾動。而如 GPT-4 這樣的高級模型提供的復述問題與人類的意圖往往更加吻合,并能增強其他模型的回答效果。

這一發現揭示了一個重要的現象:不同等級的語言模型復述的問題在質量和效果上存在差異。特別是像 GPT-4 這樣的高級模型,它復述的問題不僅能夠為自身提供更清晰的問題理解,還能夠作為一種有效的輸入,提高其他較小模型的性能。

與思維鏈(CoT)的區別

為了理解 RaR 與思維鏈(CoT)之間的區別,研究人員提出了它們的數學表述,并闡明了 RaR 在數學上與 CoT 的不同之處,以及它們如何可以輕松結合。

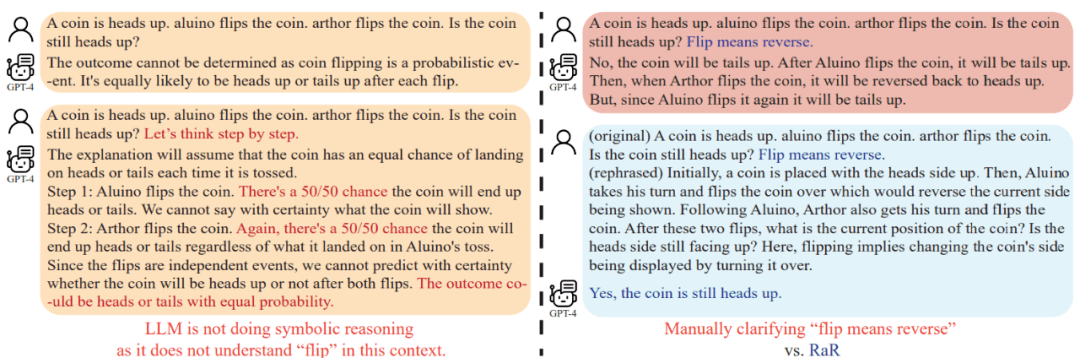

這項研究同時表明,在深入探討如何增強模型推理能力之前,應該提高問題的質量以確保模型的推理能力可以被正確評估。比如 “硬幣翻轉” 問題,人們發現與人類的意圖不同的是,GPT-4 將 “翻轉(flip)” 這一詞語理解為隨機拋擲的動作。當引導模型使用 “Let’s think step by step” 來進行推理時,這種誤解仍然存在于推理過程中。只有在澄清了問題之后,大語言模型才會回應預期的問題。

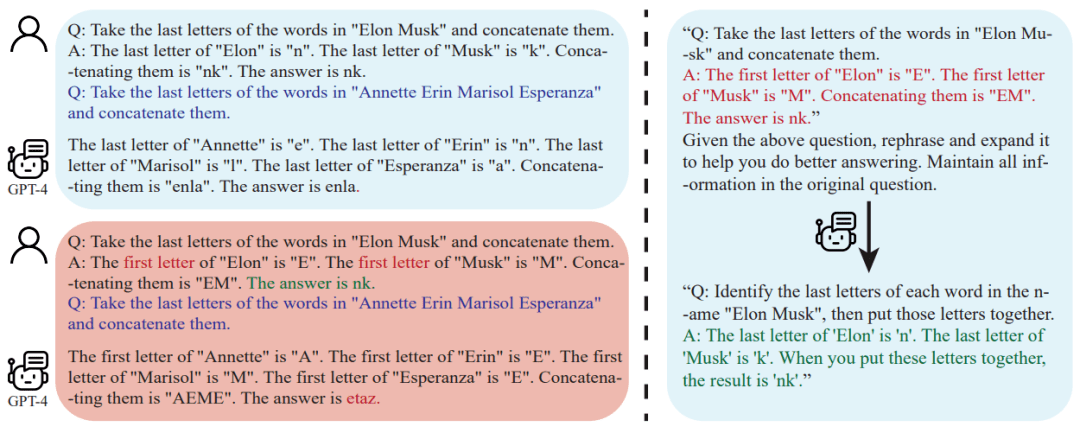

進一步的,研究人員注意到,除了問題文本之外,用于 few-shot CoT 的問答示例也是由人類編寫的。這就引發了一個問題:當這些人工構造的示例存在缺陷時,大語言模型(LLM)會作出怎樣的反應?該研究提供了一個很有意思的例子,并發現不良的 few-shot CoT 示例可能會對 LLM 產生負面影響。以 “末尾字母連接” 任務為例,先前使用的問題示例在提高模型性能方面顯示出了積極效果。然而,當提示邏輯發生變化,比如從找到末尾字母變成找到首位字母,GPT-4 卻給出了錯誤的答案。這一現象突顯了模型對人工示例的敏感性。

研究人員發現,通過使用 RaR,GPT-4 能夠糾正給定示例中的邏輯缺陷,從而提高 few-shot CoT 的質量和穩健性。

結論

人類和大語言模型(LLM)之間交流可能存在誤解:看似對人類清晰的問題可能仍會被大語言模型理解成其他的問題。UCLA 的研究團隊基于這個問題提出 RaR 這一新穎方法,促使 LLM 先復述并澄清問題,然后再回答。

RaR 在一系列基準數據集上進行的實驗評估證實了其方法的有效性。進一步分析顯示,通過復述得到的問題質量提升是可以跨模型轉移的。

展望未來,RaR 這類的方法預計將持續完善,以及它們與 CoT 等其他方法的整合,將為人類與大語言模型之間更準確、更有效的互動鋪平道路,最終拓展 AI 解釋和推理能力的邊界