詳解robots協議文件的相關問題,主要談談robots.txt是什么、配置怎么寫、有什么作用;以及,怎么給自己的網站合理配置robots.txt規則。

什么是robots.txt協議

簡單地說,robots協議就是網站空間目錄里的一個txt文件。通過在這個文件里添加相應的規則內容,我們可以規定搜索引擎蜘蛛如何爬取網站頁面。robots.txt是目前幾乎所有主流搜索引擎共同遵守的一項互聯網準則,讓網站管理者可以掌控自己網站在搜索引擎上的展現。實質上,robots的規則主要就是兩種指令:Allow指令(允許抓取)和 Disallow指令(禁止抓取)。

也就是說,robots.txt協議文件其實是給搜索引擎準備的。搜索引擎比如谷歌的蜘蛛來到網站,首先就會檢查網站的robots規則,然后根據這些規則的指導進行爬取工作。所以,一般網站都是需要配置合適的robots規則,尤其是網站的某些類目或者頁面不想被搜索引擎抓取到。如果網站沒有配置robots文件,那就相當于默認全站可抓取。

robots.txt的指令規則

上文已經提到,robots.txt主要指令就是Allow和Disallow這兩個。但,要組成一個完整的robots配置,還需要有其他指令的加入。接下來,我們逐一看下robots.txt的指令規則。

User-agent指令

任何指令都要有命令對象,robots規則指令也是如此。可能有人會疑惑:命令的對象不就是搜索引擎爬蟲嗎?是的,robots.txt就是指導這些爬蟲的抓取;但是,全球的搜索引擎這么多,如果有些內容你就想給谷歌抓取,而不想給百度抓取,那怎么辦呢?所以,User-agent指令還是必不可少的,通過它我們可以規定robots規則的限定對象。比如,對象限定為谷歌,就可以用:User-agent: googlebot,Googlebot就是谷歌的爬蟲代號,其他主要的搜索引擎爬蟲代號還有:

搜索引擎蜘蛛代號谷歌Googlebot百度BAIduspider360搜索360Spider搜狗Sogou News Spider必應bingbotMSNmsnbot

一個搜索引擎可能不止有一種蜘蛛,比如谷歌,除了常見的Googlebot外,它還有Googlebot-Image之類的爬蟲,專門用于爬取圖片等內容。如果你想了解所有搜索引擎的爬蟲代號,可以查看這里。

Disallow指令

Disallow指令就是規定網站中哪些內容不想被搜索引擎抓取。舉幾個例子:

Disallow: /folder/(folder這個網站目錄,包括里面所有頁面不要抓取)

Disallow: /file.html(不要抓取網站中file.html這個頁面)

Disallow: /image.png(不要抓取image.png這個圖片)

Allow指令

和Disallow指令的作用相反,Allow指令告訴搜索引擎哪些頁面可以被抓取,這個指令一般是配合著Disallow指令發揮作用,畢竟如果沒有Disallow,那就已經默認可以抓取了。同樣,舉個例子:

User-agent: * (指令針對所有搜索引擎,*代表所有)

Disallow: /photos(不允許抓取photos這個目錄內容)

Allow: /photos/car.jpg(只有car.jpg這個圖片可以抓取)

注意:括號里都是講解內容,真正使用這些指令規則時,不能加括號。

Crawl-delay指令

這個指令可以規定搜索引擎抓取頁面前需要等待一段時間。比如:Crawl-delay: 100,意味著需要等待100毫秒。這個指令一般用不到,而且谷歌不會執行這個指令。

Sitemap指令

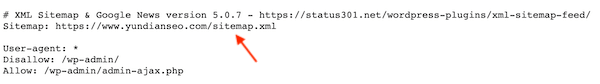

Sitemap指令就是告訴搜索引擎網站的Sitemap站點地圖在什么位置(一般位于網站根目錄中)。比如,我們網站的robots.txt文件就含有sitemap指令,大家可以自行查看:www.yundianseo.com/robots.txt

只有Google,Ask,Bing和Yahoo支持此項指令。

模糊匹配指令

在實際應用中,有時候我們需要制定某類文件或者頁面不被谷歌等搜索引擎抓取。這時,就需要應用到模糊匹配指令。robots規則中的匹配指令是兩個符號:*和$。符號*前面也有說過,是代表全部的意思;符號$則是用于結尾,代表符合結尾格式的地址。例如:Disallow: /*.gif$,表示不抓取網站中結尾格式為gif的所有文件。

常用的robots.txt配置

ROBOTS.TXT規則

功能說明

User-agent: *

Disallow: /

禁止所有搜索引擎抓取網站任何頁面;一般用于網站尚未建設完成時使用,屏蔽搜索引擎抓取。User-agent: *

Disallow: /abc/

禁止所有搜索引擎抓取abc這個目錄內容;比如,wordPress/ target=_blank class=infotextkey>WordPress網站需要禁止抓取wp-admin這個管理登錄的目錄。另外,不要使用robots規則限定你的隱私內容,仍然有可能泄露。隱私頁面最好還是設置為普通用戶不可見最為安全。User-agent: Googlebot

Allow: /

User-agent: *

Disallow: /

只允許谷歌蜘蛛爬取網站,其他搜索引擎禁止爬取。User-agent: Googlebot

Disallow: /

User-agent: *

Allow: /

除了谷歌不可以抓取,其他搜索引擎均可爬取網站。User-agent: *

Disallow: /abc.html

禁止所有搜索引擎抓取abc這個html頁面;此規則可用于禁止抓取網站中某個頁面。User-agent: *

Disallow: /images/abc.jpg

禁止所有搜索引擎抓取網站images目錄下的abc這個jpg圖片。禁止抓取某個頁面或者圖片等文件,需要正確填寫所在位置。User-agent: Googlebot

Disallow: /*xls$

禁止谷歌抓取網站中所有以xls為結尾格式的文件。

使用robots.txt的注意事項

- 如果使用robots.txt協議,首先一點就是確保配置正確,不要影響到正常內容的抓取。網站如果長時間沒被谷歌收錄,有可能就是因為robots.txt配置錯誤導致的。

- 為了方便搜索引擎查找、識別,robots.txt一般放在網站的根目錄中最好,也就是空間最開始的文件目錄里。

- robots文件,必須是txt格式結尾,并且全稱為robots.txt,不要大些首字母變成Robots.txt或者其他任何形式。

- robots.txt規則主流搜索引擎都會遵守,但不排除有些網站或者軟件的爬蟲會忽視這個文件,比如一些內容采集軟件就不會遵守規則,所以不要指望robots規則可以把這類軟件攔截在外。

- 如果有些頁面信息是比較私人的或者含有隱私,不要把它添加到robots文件內容中,雖然搜索引擎不會抓取,但訪客是可以直接打開robots文件,查看到該頁面地址的。

- 如果一個網站有二級域名,那么二級域名的網站也是需要配置robots.txt文件的,如果它含有不想被抓取的內容,主域名配置的robots文件對二級域名不起作用。

- robots.txt最好含有sitemap地址,能夠幫助搜索引擎更快地找到網站的站點地圖。站點地圖利于搜索引擎的抓取和收錄,網站如果還沒有sitemap,可以參照此篇文章進行創建:Sitemap站點地圖生成工具

如何制作robots.txt文件

制作robots.txt文件的方法很簡單:在電腦桌面創建一個txt文本,然后命名為robots即可。書寫規則內容時,注意:

- 每行一個規則指令,如果是兩段規則,中間空一行;

- 使用英文輸入法,不要使用中文輸入法,: 號后面空一格。

示例:

User-agent: *

Disallow: /(第一段)

User-agent: Googlebot

Allow: /(第二段)

如何提交robots.txt給谷歌

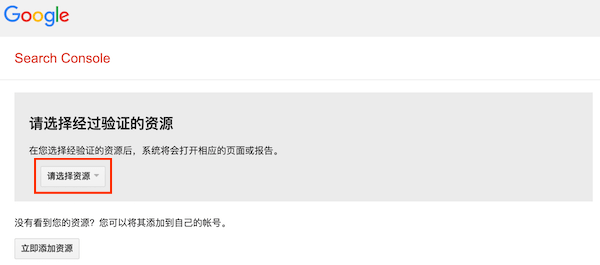

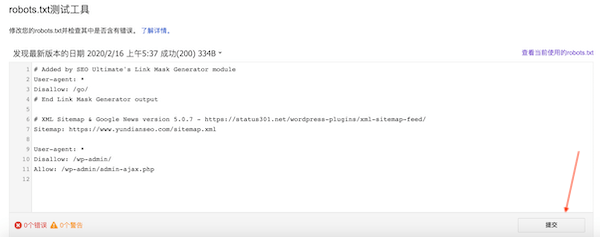

網站中已經有了robots.txt文件,可以通過robots測試工具提交給Google,讓其盡快識別。打開工具:https://www.google.com/webmasters/tools/robots-testing-tool,選擇資源(先得到谷歌站長工具中驗證網站所有權):

測試無誤后,點擊提交:

Tags:robots.txt robots協議