新智元報道

編輯:潤 好困

【新智元導讀】最近,兩位哈佛輟學生共同創立的AI芯片公司,估值已達3400萬美元,并計劃明年交付一款名為「Sohu」的AI推理加速芯片——其LLM推理性能達到H100的10倍,而單價吞吐量更是高達140倍。

像Pika一樣的神級創業故事又要再次上演了?

兩位哈佛退學的年輕人,想要制造一款專用于大語言模型加速的AI加速器芯片,將于2024年第三季度交付,推理性能達H100的10倍。

在今年6月份,兩位創始人Gavin Uberti和Chris Zhu創立了Etched.ai,獲得了包括Ebay前CEO Devin Wenig在內一眾風投機構的536萬美元的種子輪投資。

公司估值更是高達3400萬美元!

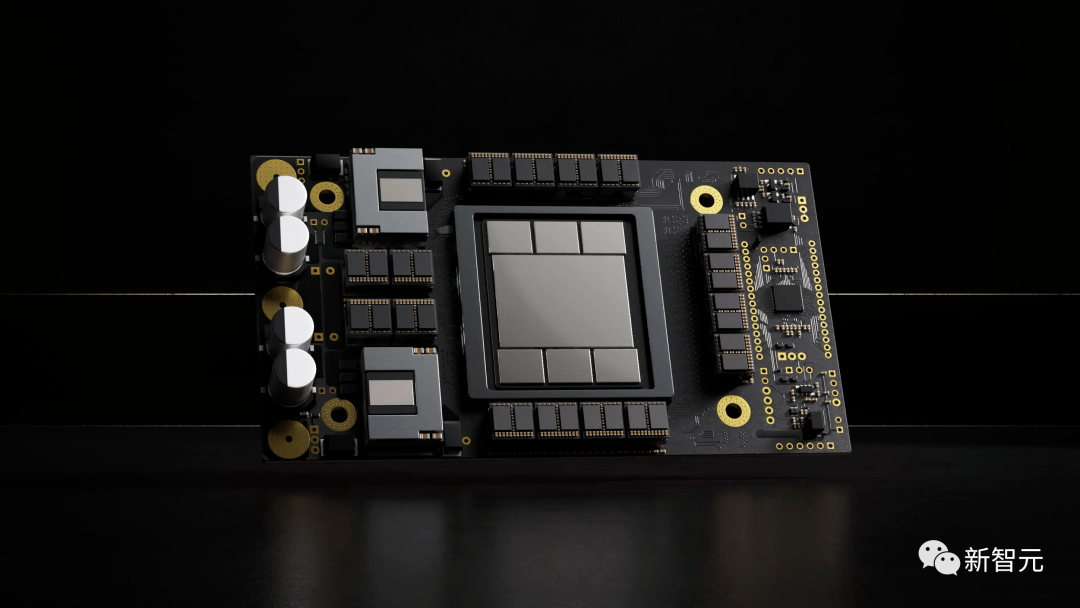

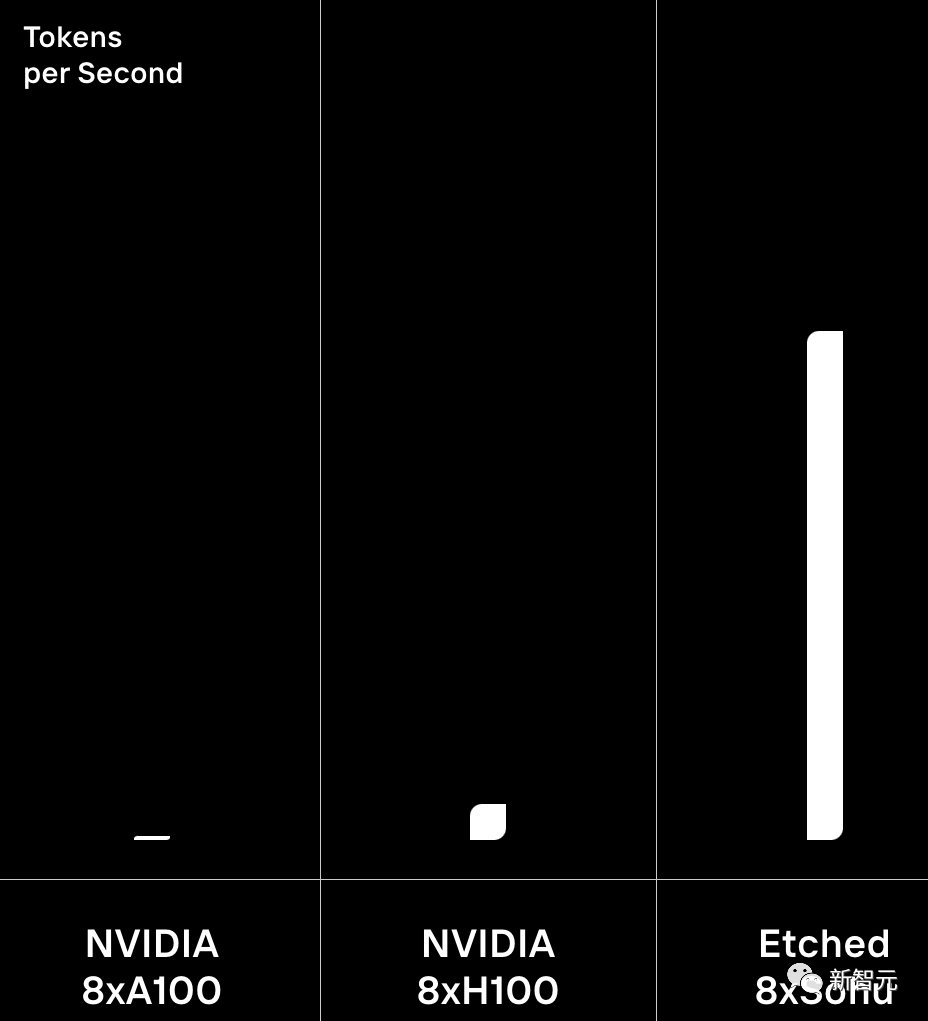

根據公司官網上放出的數據,這款芯片將在硬件層面上集成Transformer構架,將推理速度相比于英偉達H100提升了8-10倍!

他們將第一款LLM加速芯片命名為「Sohu」,號稱可以在毫秒級別的時間里處理數千個單詞。

芯片還支持通過樹搜索更好地編碼,能夠并行比較數百個響應。

還支持多重推測解碼(Multicast speculative decoding),可以實時生成新的內容。

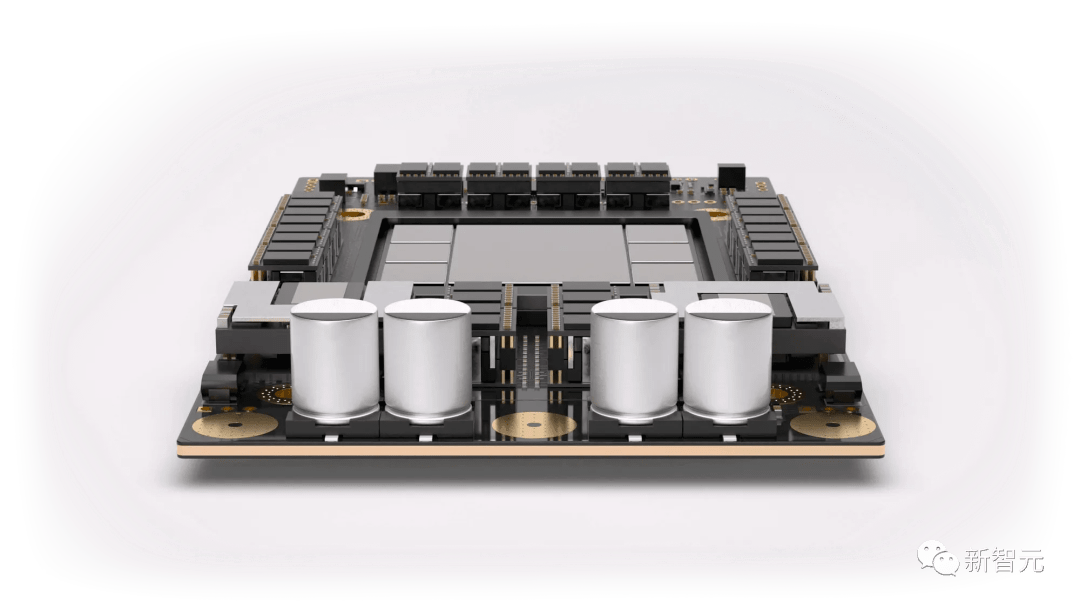

根據官方公布的具體細節,這款芯片只有一個核心,但是配備了144GB的HBM3e顯存:

- 完全開源的軟件棧,可擴展至100T參數型號

- 支持波束搜索(Beam search)和MCTS解碼

- 支持MoE和Transformer的各種變體

兩個哈佛輟學本科生挑戰芯片行業最頂尖業務

兩人原本計劃從哈佛休學一年,在一家芯片公司找到了一份負責ApacheTVM開源編譯器和微內核的工作。

但在工作中,他們發現Arm的指令集中的一些低效設計使得他們的工作效率很差。

當他們思考如何系統性地解決這個問題時,發現可以利用這個思路來設計一款針對當下爆火的AI加速芯片。

在創始人之一的Uberti看來,通用設計無法獲得他們正在研發的專有加速芯片所能帶來的那種性能提升:

「必須在單一架構上下大力氣,讓芯片處理AI任務,目標太大了,必須要針對更具體的任務來設計芯片......我們認為英偉達最終會這么做。」

在他們兩人看來,這個市場機會太大了,一定不能錯過。

「如果你回顧四年前的GPT-2,與Meta最近的 Llama模型相比,只有兩個區別——大小和激活函數。訓練方式存在差異,但這對于推理來說并不重要。」

Transformer的基本組件是固定的,雖然存在細微差別,但他們并不擔心短期之內就會出現新的構架代替Transformer。

所以他們決定做一個Transformer構架的專用集成電路(ASIC),在未來和英偉達等一系列芯片巨頭在大模型推理市場中競爭。

他們認為,Etched.ai推出的第一款芯片,相比于H100,單位價格內將獲得140倍的吞吐量性能!

二到底是什么樣的背景,能讓兩個本科還沒有畢業的學生,敢于挑戰芯片業目前最炙手可熱的賽道呢?

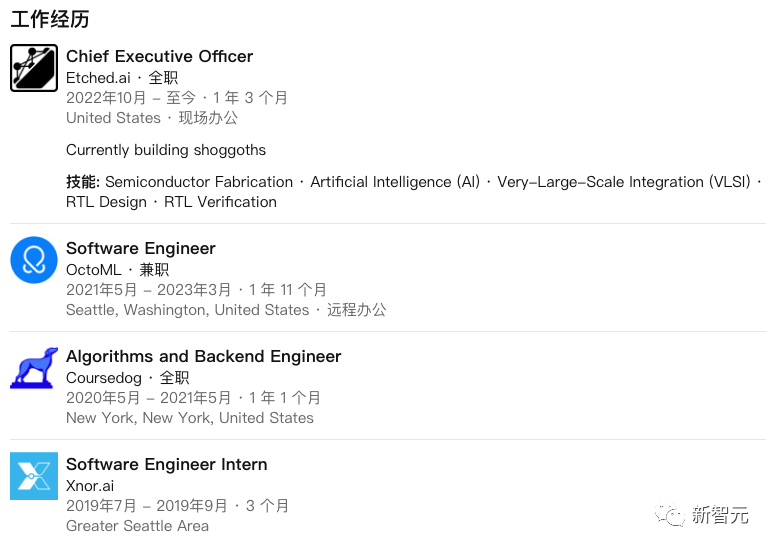

創始人兼公司CEO Gavin Uberti自從2020進入哈佛之后,就一直在校外兼職,在2022年底,成立了Etched.ai。

在進入大學之前,他參與了美國最著名的青少年科技創新大賽FIRST Tech Challenge,團隊獲得了Top 10獎項。團隊開發的自動駕駛軟件排在600個參賽團隊第二名。

另一位創始人Chris Zhu,也是在哈佛就讀時就在校外瘋狂實習,甚至還沒有從哈佛畢業,就已經成為兼職教員。

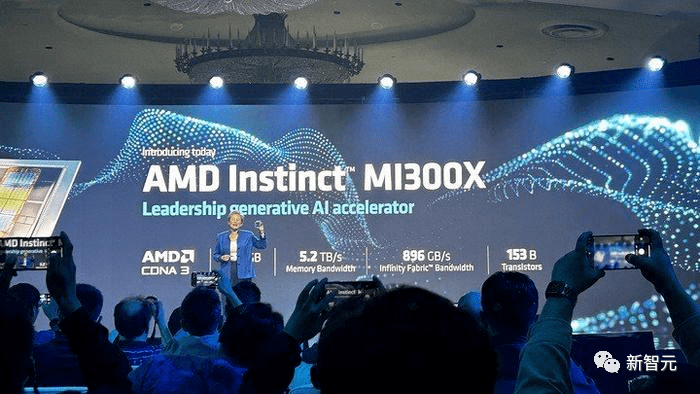

AMD MI300X決戰NVIDIA H100

而英偉達和AMD這邊,最近打得更是熱火朝天,甚至連官方都直接下場寫博客硬剛。

就在前段時間,AMD高調發布了自家最強的AI芯片MI300X。

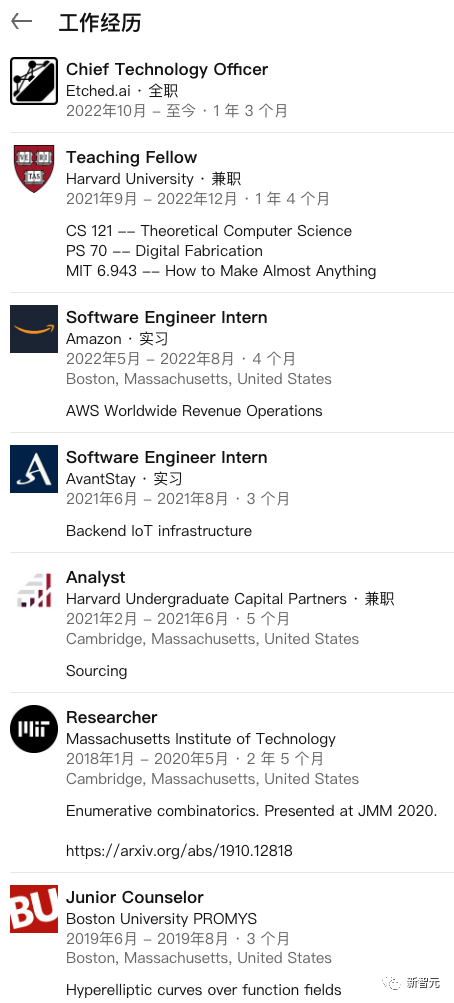

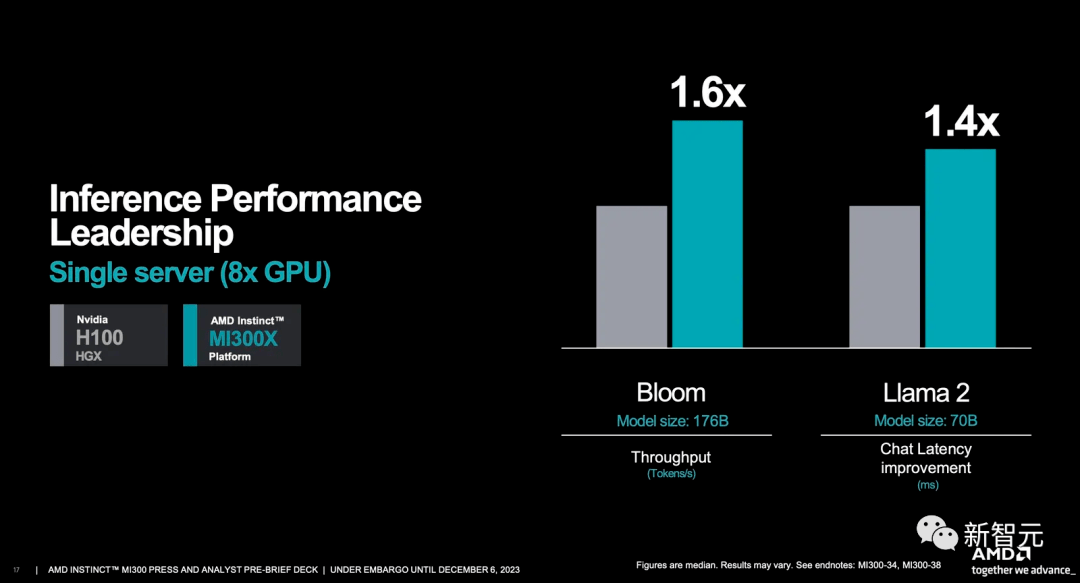

PPT顯示,由8塊MI300X組成的服務器在大模型推理方面的表現,要比同樣規模的H100速度最高提升1.6倍之多。

對于AMD來說,這種直接對標,實屬罕見。

對此,英偉達很快就發表了一篇博客文章,駁斥AMD的評測不客觀。

英偉達表示,如果H100 GPU使用了優化過的軟件進行正確的基準測試,它的性能將大大超過MI300X。

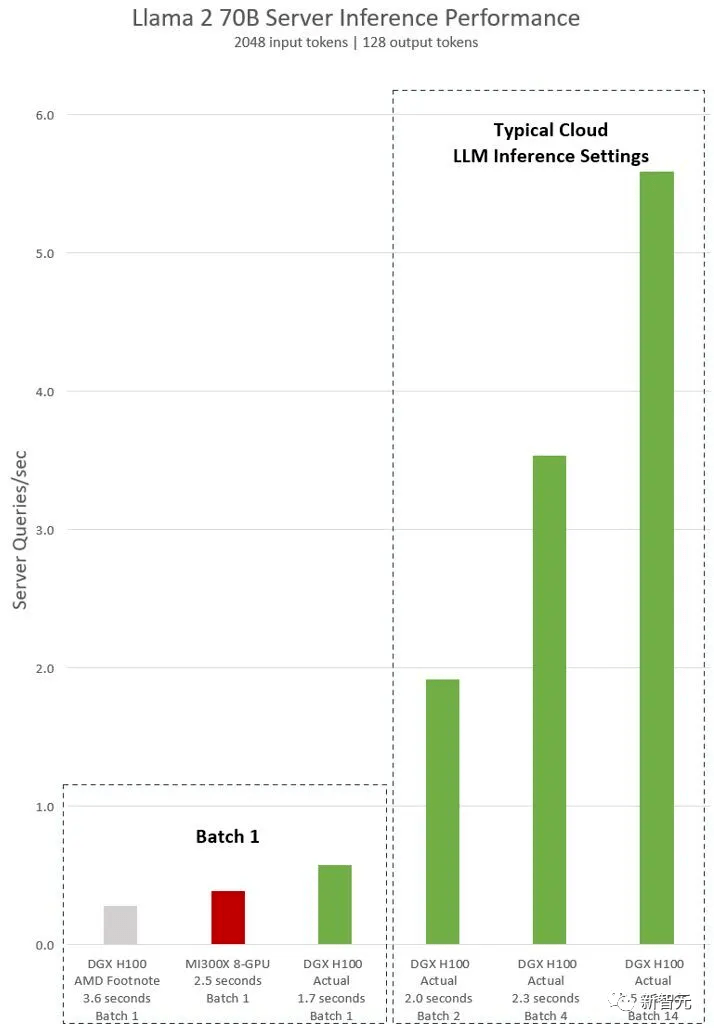

作為回應,英偉達展示了采用TensorRT-LLM優化設置后,兩款GPU在Llama 2 70B上的比較結果。

文章地址:https://developer.nvidia.com/blog/achieving-top-inference-performance-with-the-nvidia-h100-tensor-core-gpu-and-nvidia-tensorrt-llm/

可以看到,當批處理大小設置為1時,H100的性能達到了MI300X的2倍。

甚至,當采用與AMD相同的2.5秒延遲時,H100的性能可以達到MI300X的14倍之多。

英偉達表示,AMD采用的替代軟件不支持Hopper的Transformer Engine,并且忽略了TensorRT-LLM中的關鍵優化功能。而這些都可以在Github上免費獲取。

AMD毫不示弱

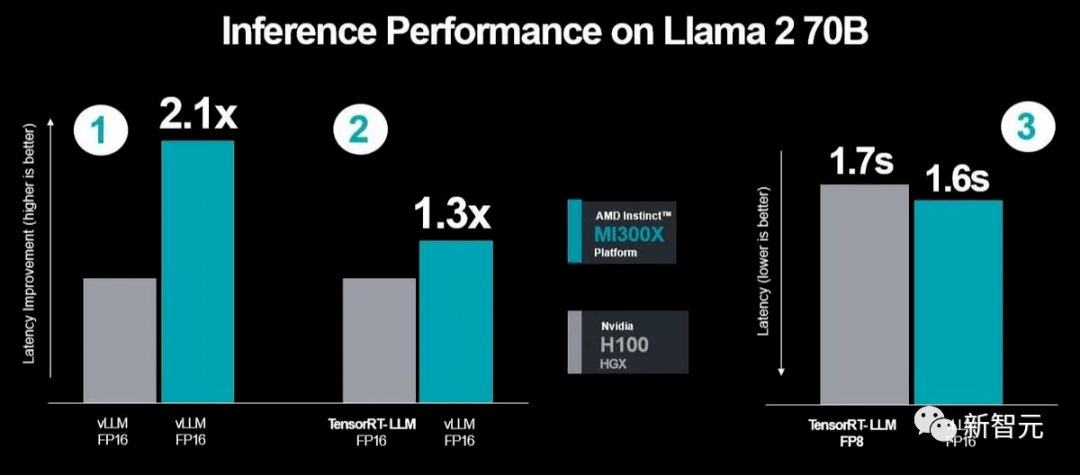

見狀,AMD也發文表示,既然要用優化,那就大家都用。

而即便是在這種情況下,MI300X的性能依然比H100強了30%。

文章地址:https://community.amd.com/t5/instinct-accelerators/competitive-performance-claims-and-industry-leading-inference/ba-p/652304

具體來說:

1. 在同樣采用vLLM FP16的設置時,相比于發布會上展示的1.4倍性能,AMD最新的優化已經讓這一優勢擴大到了2.1倍。

2. 與使用TensorRT-LLM優化的H100相比,使用vLLM的MI300X實現了1.3倍的延遲改善。

3. 相比于采用低精度FP8和TensorRT-LLM的H100,使用vLLM和高精度FP16的MI300X在絕對延遲方面,表現更好。

AMD指出,英偉達在H100上進行基準測試時使用的是自家專有的技術TensorRT-LLM,而非更廣泛使用的vLLM。

此外,在延遲方面,英偉達只關注吞吐量的性能,卻忽視了實際工作中的延遲問題。

最后,AMD表示,之所以選擇使用FP16,是因為它非常流行,而且目前vLLM還不支持FP8。

GPU大戰進入白熱化

在人工智能加速器領域,一些公司擁有針對特定工作負載的專門架構。

數據中心的專用架構主要集中在DLRM(深度學習推薦模型),因為GPU很難加速這類任務。

Meta最近宣布已經構建了自己的DLRM推理芯片,并且已經得到廣泛部署。

而對于Transformer構架的加速,英偉達是通過在H100 GPU中部署Transformer Engine的軟件功能來實現的。

Transformer Engine使得LLM推理無需進一步量化即可進行,大大加速了GPU推理LLM的效果。

而Etched.ai要做的就是更近一步,在硬件層面完成這個設計,從而使得LLM的推理速度和能效都更上一層樓。

而投資人之所以愿意給兩位本科輟學生投入如此之大的一筆錢,更重要的是迄今為止,所有人都認為現在LLM推理的成本過高,其中一定有創新的空間。

除了這樣的明星初創公司以外,傳統巨頭對于大模型推理市場同樣抱有很高的期待。

蘇媽在各種場合不斷表示,未來大模型推理市場的規模將遠遠大于模型訓練市場。所以AMD也一直在強調自己的產品已經對這個市場做好了充分地準備。

從英偉達和AMD首次公開對比自家產品的性能這件事來看,GPU領域的競爭顯然正在加劇。

目前,英偉達除了要面對AMD的挑戰之外,還需要考慮英特爾和Cerebras取得的快速進展。

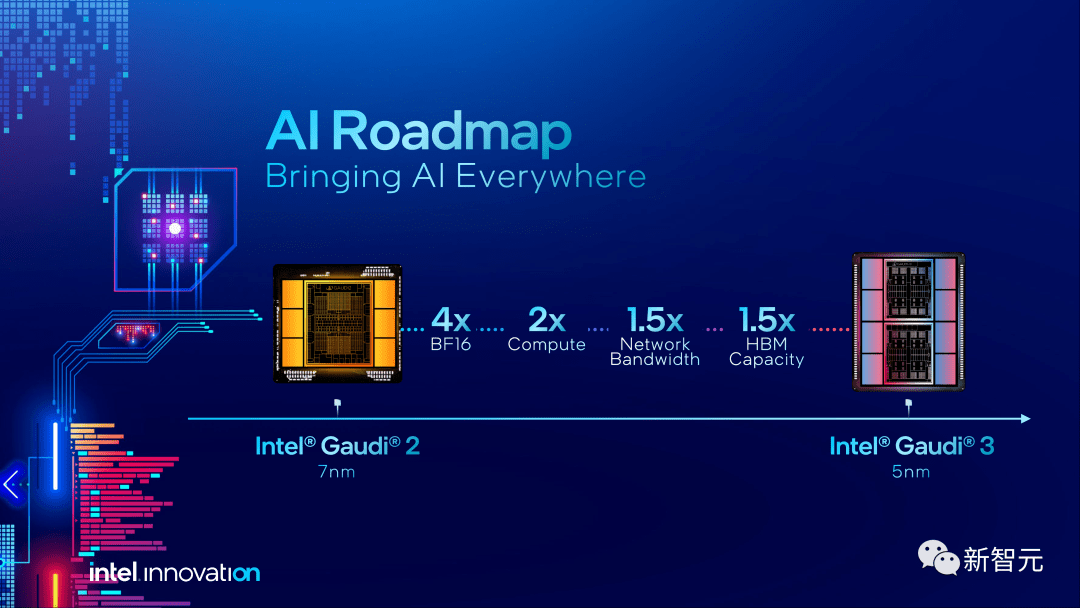

就在12月14日,首席執行官Pat Gelsinger展示了英特爾最新的AI芯片——采用5nm工藝制程,性能提升了1.5倍的Gaudi 3。

相比于上一代Gaudi 2,Gaudi 3的BFloat16性能提升了4倍,計算能力提升2倍,顯存容量提升50%達到144GB,并且采用的是HBM3或HBM3e。

同樣,英偉達也計劃在明年初推出GH200超級芯片。

鑒于競爭如此激烈,AMD可能會被諸如微軟、Meta和甲骨文這些已經宣布將其技術集成到數據中心的公司,視為備選方案。

Gelsinger預測,到2027年,GPU市場規模將達到驚人的4000億美元,這無疑為激烈的競爭提供了廣闊的舞臺。

Cerebras Systems的CEO Andrew Feldman更是毫不遮掩自己的野心:「我們正在努力超越英偉達,到明年,我們將構建高達36 exaflops的AI算力。」

參考資料:

https://www.etched.ai/

https://analyticsindiamag.com/gpu-battle-nvidia-vs-amd/

https://www.eetimes.com/harvard-dropouts-raise-5-million-for-llm-accelerator/